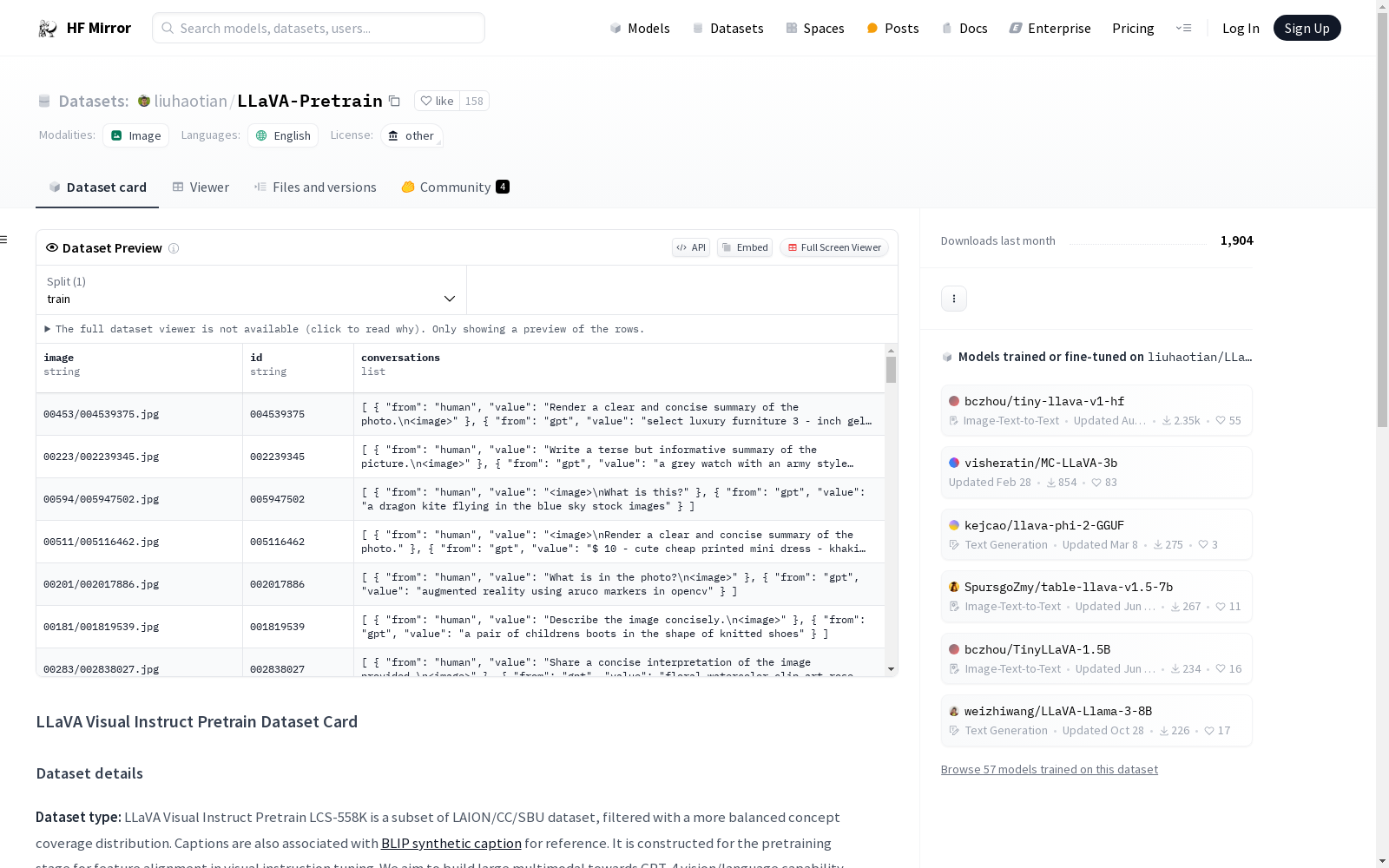

liuhaotian/LLaVA-Pretrain|人工智能数据集|多模态学习数据集

收藏LLaVA Visual Instruct Pretrain 数据集卡片

数据集详情

数据集类型: LLaVA Visual Instruct Pretrain LCS-558K 是 LAION/CC/SBU 数据集的一个子集,经过筛选以实现更平衡的概念覆盖分布。字幕与 BLIP 合成字幕 相关联,供参考。该数据集用于视觉指令调优的预训练阶段,旨在构建面向 GPT-4 视觉/语言能力的大型多模态模型。

数据集日期: LLaVA Visual Instruct CC3M Pretrain 595K 创建于 2023 年 5 月。

数据集结构:

blip_laion_cc_sbu_558k.json包含从图像-字幕对生成的多模态合成对话,通过添加随机选择的指令,如 "描述这张图片"。用于 LLaVA 的预训练。我们使用原始 CC-3M 字幕作为默认答案。blip_laion_cc_sbu_558k_meta.json包含图像文件名、图像 URL 和合成 BLIP 字幕的元数据。images.zip包含从 LAION/CC/SBU 筛选出的子集的所有原始图像。重要提示:根据社区请求,由于原始 LAION/CC/SBU 数据集的约 15% 图像不再可访问,我们上传了 images.zip 以便更好地在研究社区中复现我们的工作。这些图像不得用于任何其他目的。使用这些图像必须遵守 LAION/CC/SBU 许可。当原始 LAION/CC/SBU 数据集所有者或引用图像所有者请求时,这些图像可能会被删除。

更多信息资源或论文: LLaVA 项目页面

许可: 必须遵守 CC-3M 和 BLIP(如果您使用他们的合成字幕)的许可。

CC-3M 该数据集可自由用于任何目的,尽管对 Google LLC ("Google") 作为数据源的认可将受到赞赏。该数据集以 "AS IS" 形式提供,没有任何明示或暗示的保证。Google 不承担因使用该数据集而导致的任何直接或间接损害的责任。

关于模型的疑问或评论发送至: LLaVA GitHub 问题页面

预期用途

主要预期用途: LLaVA 的主要用途是进行大型多模态模型和聊天机器人的研究。

主要预期用户: 该模型的主要预期用户是计算机视觉、自然语言处理、机器学习和人工智能领域的研究人员和爱好者。

中国空气质量数据集(2014-2020年)

数据集中的空气质量数据类型包括PM2.5, PM10, SO2, NO2, O3, CO, AQI,包含了2014-2020年全国360个城市的逐日空气质量监测数据。监测数据来自中国环境监测总站的全国城市空气质量实时发布平台,每日更新。数据集的原始文件为CSV的文本记录,通过空间化处理生产出Shape格式的空间数据。数据集包括CSV格式和Shape格式两数数据格式。

国家地球系统科学数据中心 收录

Awesome JSON Datasets

一个精选的无需认证的JSON数据集列表。

github 收录

猫狗图像数据集

该数据集包含猫和狗的图像,每类各12500张。训练集和测试集分别包含10000张和2500张图像,用于模型的训练和评估。

github 收录

Online Retail II

该在线零售II数据集包含了一家英国注册的非实体店铺在线零售商在2009年12月1日至2011年12月9日期间发生的所有交易记录。该公司主要销售各种场合的独特礼品。该公司的许多客户是批发商。

github 收录

NREL Wind Integration National Dataset (WIND) Toolkit

NREL Wind Integration National Dataset (WIND) Toolkit 是一个包含美国大陆风能资源和电力系统集成数据的综合数据集。该数据集提供了高分辨率的风速、风向、风能密度、电力输出等数据,覆盖了美国大陆的多个地理区域。这些数据有助于研究人员和工程师进行风能资源评估、电力系统规划和集成研究。

www.nrel.gov 收录