openai/webgpt_comparisons|自然语言处理数据集|问答系统数据集

收藏数据集卡片 for WebGPT Comparisons

数据集描述

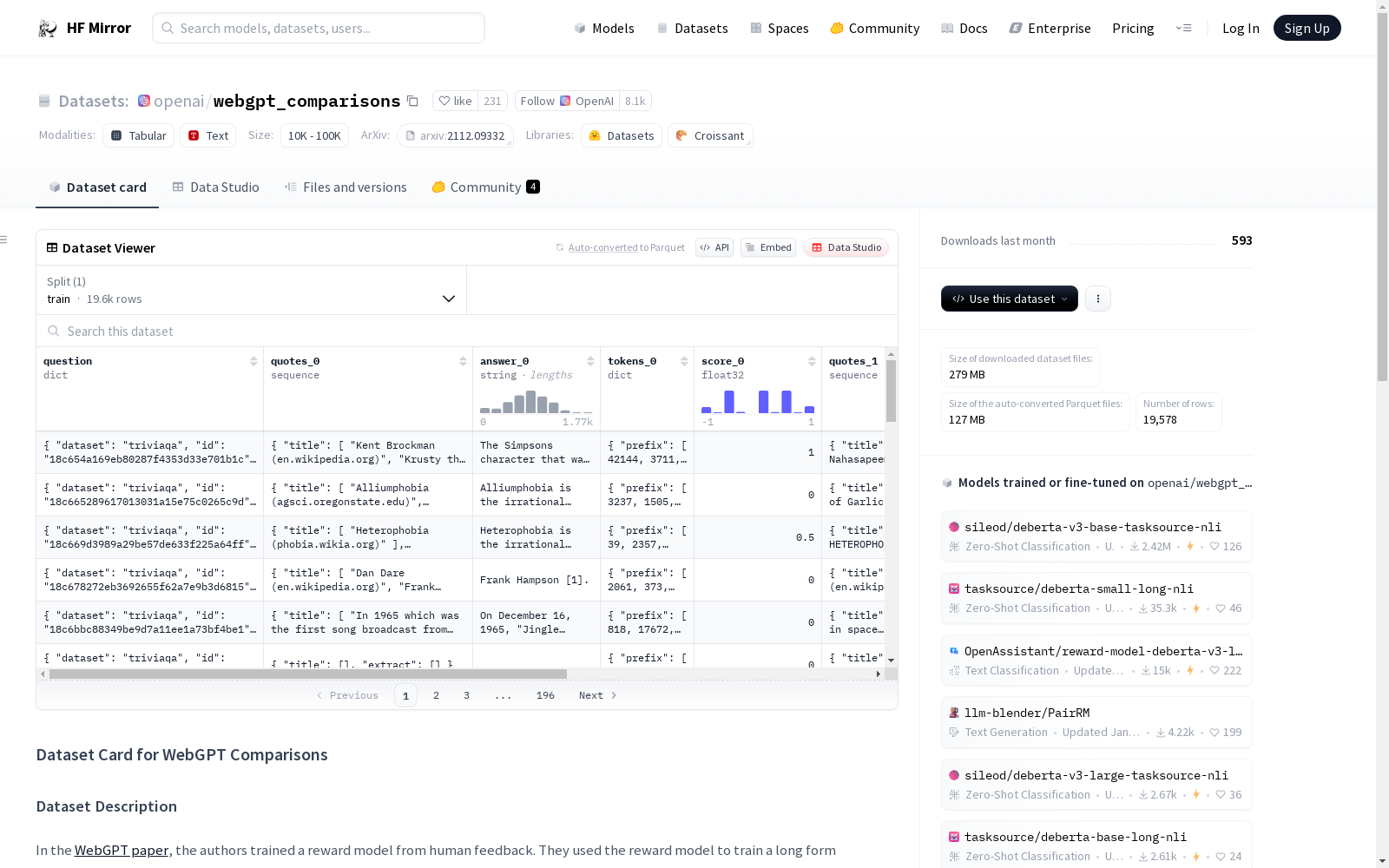

该数据集包含WebGPT项目中所有被标记为适合奖励建模的比较。总共有19,578个比较。每个示例包含一对针对某个问题的模型答案及其相关元数据。每个答案都有一个来自人类的偏好分数,用于确定两个答案中哪个更好。

每个示例包含以下字段:

question:问题的文本,以及问题来源的数据集名称和唯一ID。quotes_0:模型在浏览以生成answer_0时找到的摘录,以及摘录所在页面的标题(由页面的HTML标题和域名构成)。answer_0:模型使用quotes_0编写的最终答案。tokens_0:在生成answer_0的最后一步中会提供给模型的前缀,以及模型或人类给出的完成。前缀由问题和引用组成,并进行了一些截断,完成部分就是答案。两者都使用GPT-2分词器进行分词。前缀和完成的连接是用于奖励建模的输入。score_0:answer_0相对于answer_1的偏好强度,取值范围为-1到1。它与score_1之和为0,当且仅当其分数为正时,答案被偏好。对于奖励建模,我们将分数为0视为软50%标签,所有其他分数视为硬标签(仅使用其符号)。quotes_1:与quotes_0对应。answer_1:与answer_0对应。tokens_1:与tokens_0对应。score_1:与score_0对应。

这些信息来自WebGPT论文的附录K。

Granary

Granary是一个包含25种欧洲语言的大规模语音识别和翻译数据集,由NVIDIA等多家机构联合创建。数据集通过伪标签技术生成,旨在解决低资源语言的语音处理问题。数据集包含约643,237.57小时的语音数据,经过精心筛选和处理,旨在提高数据质量并减少数据中的错误。该数据集可用于自动语音识别(ASR)和自动语音翻译(AST)等领域的研究,有助于提高语音模型在低资源语言上的准确性和鲁棒性。

arXiv 收录

Wind Turbine Data

该数据集包含风力涡轮机的运行数据,包括风速、风向、发电量等参数。数据记录了多个风力涡轮机在不同时间点的运行状态,适用于风能研究和风力发电系统的优化分析。

www.kaggle.com 收录

学生课堂行为数据集 (SCB-dataset3)

学生课堂行为数据集(SCB-dataset3)由成都东软学院创建,包含5686张图像和45578个标签,重点关注六种行为:举手、阅读、写作、使用手机、低头和趴桌。数据集覆盖从幼儿园到大学的不同场景,通过YOLOv5、YOLOv7和YOLOv8算法评估,平均精度达到80.3%。该数据集旨在为学生行为检测研究提供坚实基础,解决教育领域中学生行为数据集的缺乏问题。

arXiv 收录

双色球开奖号码数据集

双色球开奖号码数据集从2003001-2025011

魔搭社区 收录

Spambase

Spambase数据集是一个垃圾邮件数据集,包含57个属性和4601个实例。该数据集主要用于垃圾邮件的识别和分类。垃圾邮件的资源都来自邮件管理员和提交垃圾邮件的个人。可用于构建垃圾邮件过滤器。 该数据集由惠普实验室在1999年7月发布,马克·霍普金斯、埃里克·里伯、乔治·福尔曼和雅普·苏蒙德为主要贡献者。

OpenDataLab 收录