Reuters-21578 Text Categorization Collection|文本分类数据集

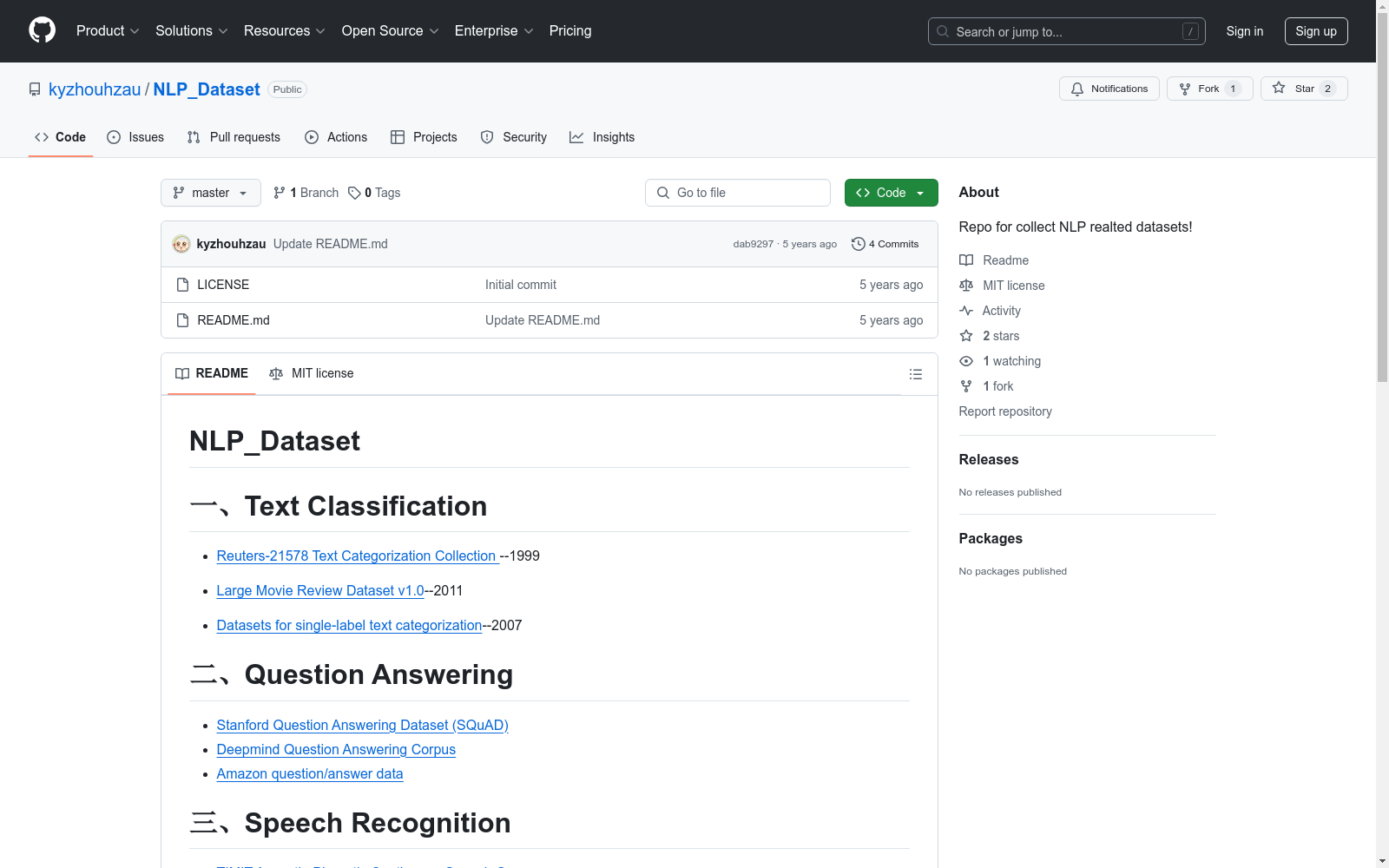

收藏NLP_Dataset 数据集概述

一、文本分类

- Reuters-21578 Text Categorization Collection (1999)

- Large Movie Review Dataset v1.0 (2011)

- Datasets for single-label text categorization (2007)

二、问答系统

- Stanford Question Answering Dataset (SQuAD)

- Deepmind Question Answering Corpus

- Amazon question/answer data

三、语音识别

- TIMIT Acoustic-Phonetic Continuous Speech Corpus

- voxforge

- LibriSpeech ASR corpus

四、机器翻译

- Aligned Hansards of the 36th Parliament of Canada Release 2001-1a

- European Parliament Proceedings Parallel Corpus 1996-2011

五、文档摘要

- The AQUAINT Corpus of English News Text

- Legal Case Reports Data Set

六、更多数据集

生物医学领域

- Mutation extraction

- MutationFinder(MF)

- extractor of mutation(EMU)

- tmVar

- Reuters-21578 Text Categorization Collection首次发布,作为文本分类研究的标准数据集。

- 数据集经过修订和更新,成为Reuters-21578,广泛应用于信息检索和机器学习领域。

- 数据集在多个国际会议和期刊上被引用,成为文本分类和自然语言处理研究的重要基准。

- 随着深度学习技术的发展,Reuters-21578被用于验证新型算法和模型的有效性。

- 数据集继续被广泛使用,支持了大量关于文本分类、情感分析和信息检索的研究工作。

- 1Reuters-21578 Text Categorization Test CollectionUniversity of Massachusetts · 1997年

- 2A Study of Cross-Domain Text CategorizationUniversity of Waterloo · 2010年

- 3Text Categorization with Support Vector Machines: Learning with Many Relevant FeaturesUniversity of Technology, Sydney · 1998年

- 4A Comparative Study of TF-IDF, LSI and Multi-Words for Text ClassificationUniversity of Malaya · 2015年

- 5Deep Learning for Text Classification with Reuters-21578 DatasetStanford University · 2018年

凯斯西储大学滚动轴承数据集(CWRU)

美国凯斯西储大学提供的滚动轴承数据集,包括了正常数据、轴承外圈故障数据、内圈故障数据、滚动体故障数据,可用于建立故障诊断分类任务

AI_Studio 收录

中国区域地面气象要素驱动数据集 v2.0(1951-2024)

中国区域地面气象要素驱动数据集(China Meteorological Forcing Data,以下简称 CMFD)是为支撑中国区域陆面、水文、生态等领域研究而研发的一套高精度、高分辨率、长时间序列数据产品。本页面发布的 CMFD 2.0 包含了近地面气温、气压、比湿、全风速、向下短波辐射通量、向下长波辐射通量、降水率等气象要素,时间分辨率为 3 小时,水平空间分辨率为 0.1°,时间长度为 74 年(1951~2024 年),覆盖了 70°E~140°E,15°N~55°N 空间范围内的陆地区域。CMFD 2.0 融合了欧洲中期天气预报中心 ERA5 再分析数据与气象台站观测数据,并在辐射、降水数据产品中集成了采用人工智能技术制作的 ISCCP-ITP-CNN 和 TPHiPr 数据产品,其数据精度较 CMFD 的上一代产品有显著提升。 CMFD 历经十余年的发展,其间发布了多个重要版本。2019 年发布的 CMFD 1.6 是完全采用传统数据融合技术制作的最后一个 CMFD 版本,而本次发布的 CMFD 2.0 则是 CMFD 转向人工智能技术制作的首个版本。此版本与 1.6 版具有相同的时空分辨率和基础变量集,但在其它诸多方面存在大幅改进。除集成了采用人工智能技术制作的辐射和降水数据外,在制作 CMFD 2.0 的过程中,研发团队尽可能采用单一来源的再分析数据作为输入并引入气象台站迁址信息,显著缓解了 CMFD 1.6 中因多源数据拼接和气象台站迁址而产生的虚假气候突变。同时,CMFD 2.0 数据的时间长度从 CMFD 1.6 的 40 年大幅扩展到了 74 年,并将继续向后延伸。CMFD 2.0 的网格空间范围虽然与 CMFD 1.6 相同,但其有效数据扩展到了中国之外,能够更好地支持跨境区域研究。为方便用户使用,CMFD 2.0 还在基础变量集之外提供了若干衍生变量,包括近地面相对湿度、雨雪分离降水产品等。此外,CMFD 2.0 摒弃了 CMFD 1.6 中通过 scale_factor 和 add_offset 参数将实型数据化为整型数据的压缩技术,转而直接将实型数据压缩存储于 NetCDF4 格式文件中,从而消除了用户使用数据时进行解压换算的困扰。 本数据集原定版本号为 1.7,但鉴于本数据集从输入数据到研制技术都较上一代数据产品有了大幅的改变,故将其版本号重新定义为 2.0。

国家青藏高原科学数据中心 收录

Amazon电影评论数据集

该数据集包含从1997年8月至2012年10月期间,Amazon用户对253,059种产品的7,911,684条评论。数据集被添加了真实标签,这些标签是通过爬取/抓取Amazon.com获得的,用于分类产品。

github 收录

TUT dataset

TUT数据集用于结构裂缝分割模型CrackSCF的训练和测试。

github 收录

Chinese-Poetry-Corpus

本语料库收集自互联网,包含了从先秦到当代的古诗词数据,以CSV格式进行存储。经过去重后,包含诗词共计1014508首。古诗词按朝代进行划分,存储于文件夹下,命名规则为朝代.csv。每首诗词数据包含五个字段,分别为标题、朝代、作者、体裁、内容。

github 收录