MEAD+ (Multimodal EmotionLines Dataset+)|情感识别数据集|多模态情感分析数据集

收藏

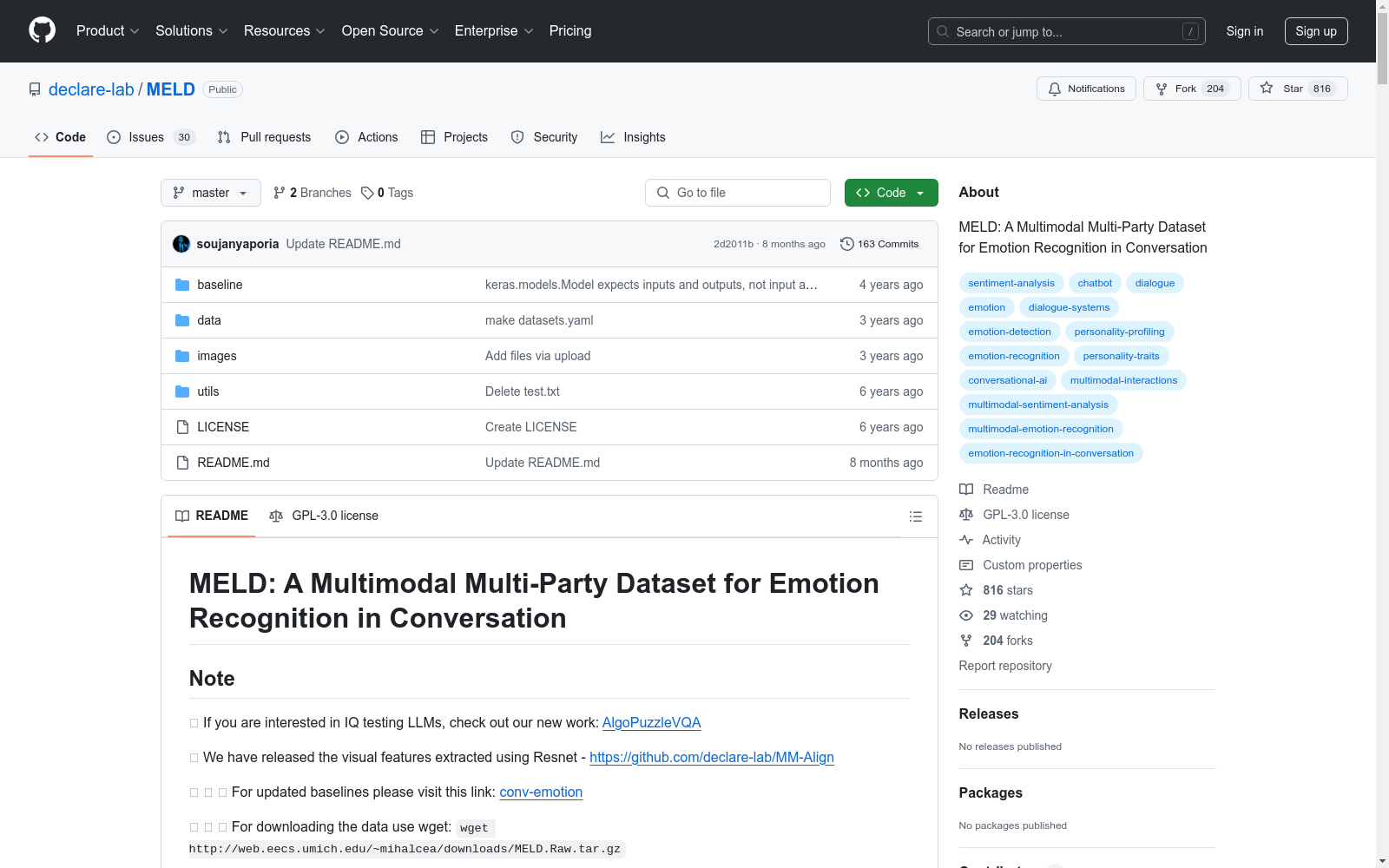

- MEAD+数据集首次发表,作为对原始EmotionLines数据集的扩展,增加了多模态情感分析的功能。

- MEAD+数据集首次应用于多模态情感识别研究,展示了其在跨模态情感分析中的潜力。

- MEAD+数据集被广泛应用于多个情感分析竞赛和研究项目中,进一步验证了其数据质量和实用性。

- MEAD+数据集的更新版本发布,增加了更多的对话样本和情感类别,提升了数据集的多样性和覆盖范围。

OMIM (Online Mendelian Inheritance in Man)

OMIM是一个包含人类基因和遗传疾病信息的在线数据库。它提供了详细的遗传疾病描述、基因定位、相关文献和临床信息。数据集内容包括疾病名称、基因名称、基因定位、遗传模式、临床特征、相关文献引用等。

www.omim.org 收录

CatMeows

该数据集包含440个声音样本,由21只属于两个品种(缅因州库恩猫和欧洲短毛猫)的猫在三种不同情境下发出的喵声组成。这些情境包括刷毛、在陌生环境中隔离和等待食物。每个声音文件都遵循特定的命名约定,包含猫的唯一ID、品种、性别、猫主人的唯一ID、录音场次和发声计数。此外,还有一个额外的zip文件,包含被排除的录音(非喵声)和未剪辑的连续发声序列。

huggingface 收录

DAT

DAT是一个统一的跨场景跨领域基准,用于开放世界无人机主动跟踪。它提供了24个视觉复杂的场景,以评估算法的跨场景和跨领域泛化能力,并具有高保真度的现实机器人动力学建模。

github 收录

CE-CSL

CE-CSL数据集是由哈尔滨工程大学智能科学与工程学院创建的中文连续手语数据集,旨在解决现有数据集在复杂环境下的局限性。该数据集包含5,988个从日常生活场景中收集的连续手语视频片段,涵盖超过70种不同的复杂背景,确保了数据集的代表性和泛化能力。数据集的创建过程严格遵循实际应用导向,通过收集大量真实场景下的手语视频材料,覆盖了广泛的情境变化和环境复杂性。CE-CSL数据集主要应用于连续手语识别领域,旨在提高手语识别技术在复杂环境中的准确性和效率,促进聋人与听人社区之间的无障碍沟通。

arXiv 收录

ReferCOCO数据集

ReferCOCO数据集包括refcoco、refcoco+和refcocog三个子集,用于视觉定位任务。数据集包含图像和对应的描述性文本,用于训练和测试模型识别图像中特定对象的能力。

github 收录