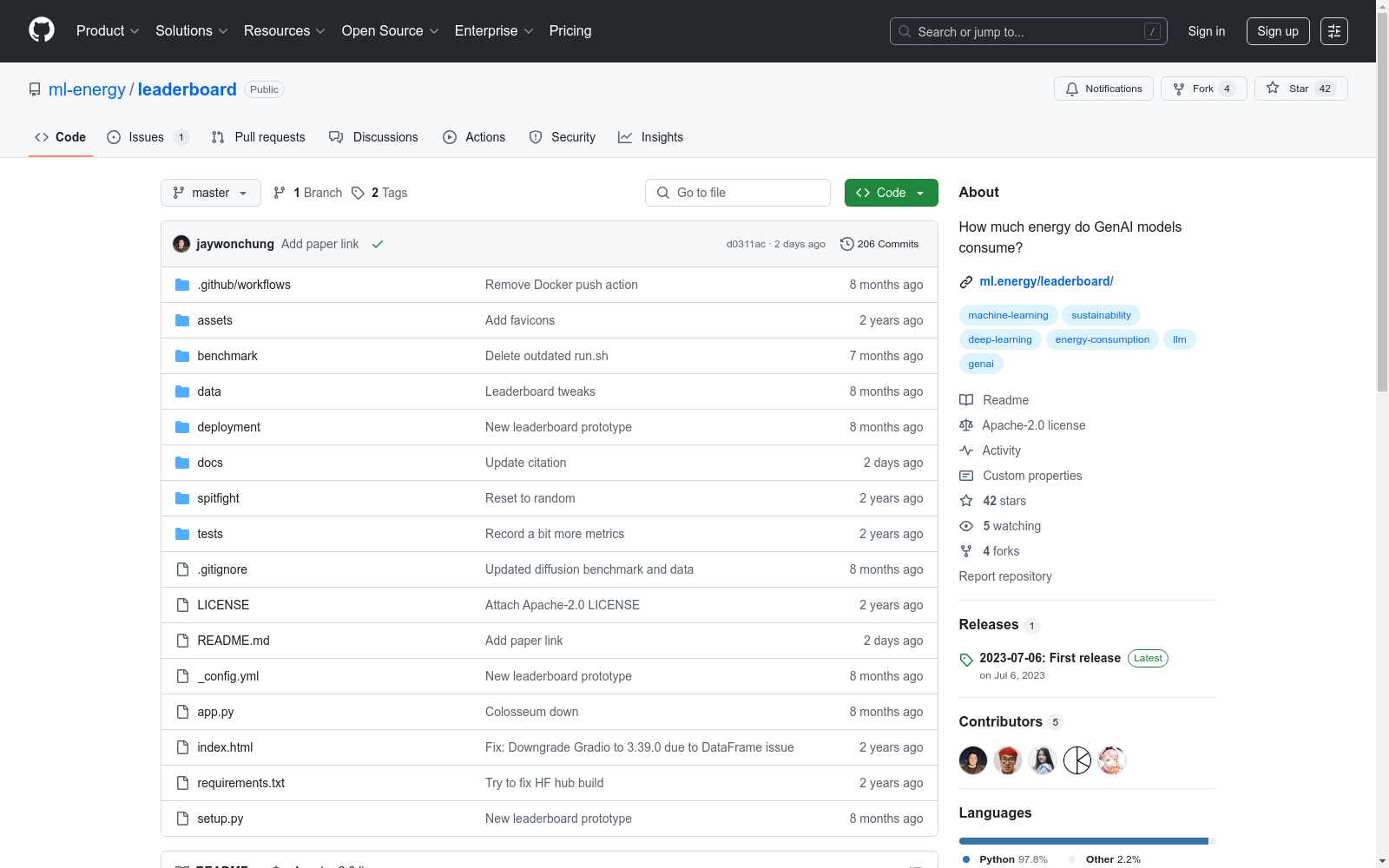

ML.ENERGY Benchmark|人工智能数据集|能耗优化数据集

收藏

poi

本项目收集国内POI兴趣点,当前版本数据来自于openstreetmap。

github 收录

LIDC-IDRI

LIDC-IDRI 数据集包含来自四位经验丰富的胸部放射科医师的病变注释。 LIDC-IDRI 包含来自 1010 名肺部患者的 1018 份低剂量肺部 CT。

OpenDataLab 收录

DALY

DALY数据集包含了全球疾病负担研究(Global Burden of Disease Study)中的伤残调整生命年(Disability-Adjusted Life Years, DALYs)数据。该数据集提供了不同国家和地区在不同年份的DALYs指标,用于衡量因疾病、伤害和早逝导致的健康损失。

ghdx.healthdata.org 收录

中国行政区划shp数据

中国行政区划数据是重要的基础地理信息数据,目前不同来源的全国行政区划数据非常多,但能够开放获取的高质量行政区域数据少之又少。基于此,锐多宝的地理空间制作一套2013-2023年可开放获取的高质量行政区划数据。该套数据以2022年国家基础地理信息数据中的县区划数据作为矢量基础,辅以高德行政区划数据、天地图行政区划数据,参考历年来民政部公布的行政区划为属性基础,具有时间跨度长、属性丰富、国界准确、更新持续等特性。 中国行政区划数据统计截止时间是2023年2月12日,包含省、市、县、国界、九段线等矢量shp数据。该数据基于2020年行政区划底图,按时间顺序依次制作了2013-2023年初的行政区划数据。截止2023年1月1日,我国共有34个省级单位,分别是4个直辖市、23个省、5个自治区和2个特别行政区。截止2023年1月1日,我国共有333个地级单位,分别是293个地级市、7个地区、30个自治州和3个盟,其中38个矢量要素未纳入统计(比如直辖市北京等、特别行政区澳门等、省直辖县定安县等)。截止2023年1月1日,我国共有2843个县级单位,分别是1301个县、394个县级市、977个市辖区、117个自治县、49个旗、3个自治旗、1个特区和1个林区,其中9个矢量要素未纳入县级类别统计范畴(比如特别行政区香港、无县级单位的地级市中山市东莞市等)。

CnOpenData 收录

网易云音乐数据集

该数据集包含了网易云音乐平台上的歌手信息、歌曲信息和歌单信息,数据通过爬虫技术获取并整理成CSV格式,用于音乐数据挖掘和推荐系统构建。

github 收录