MultiChartQA|多模态学习数据集|视觉问答数据集

收藏arXiv2024-10-18 更新2024-10-22 收录

下载链接:

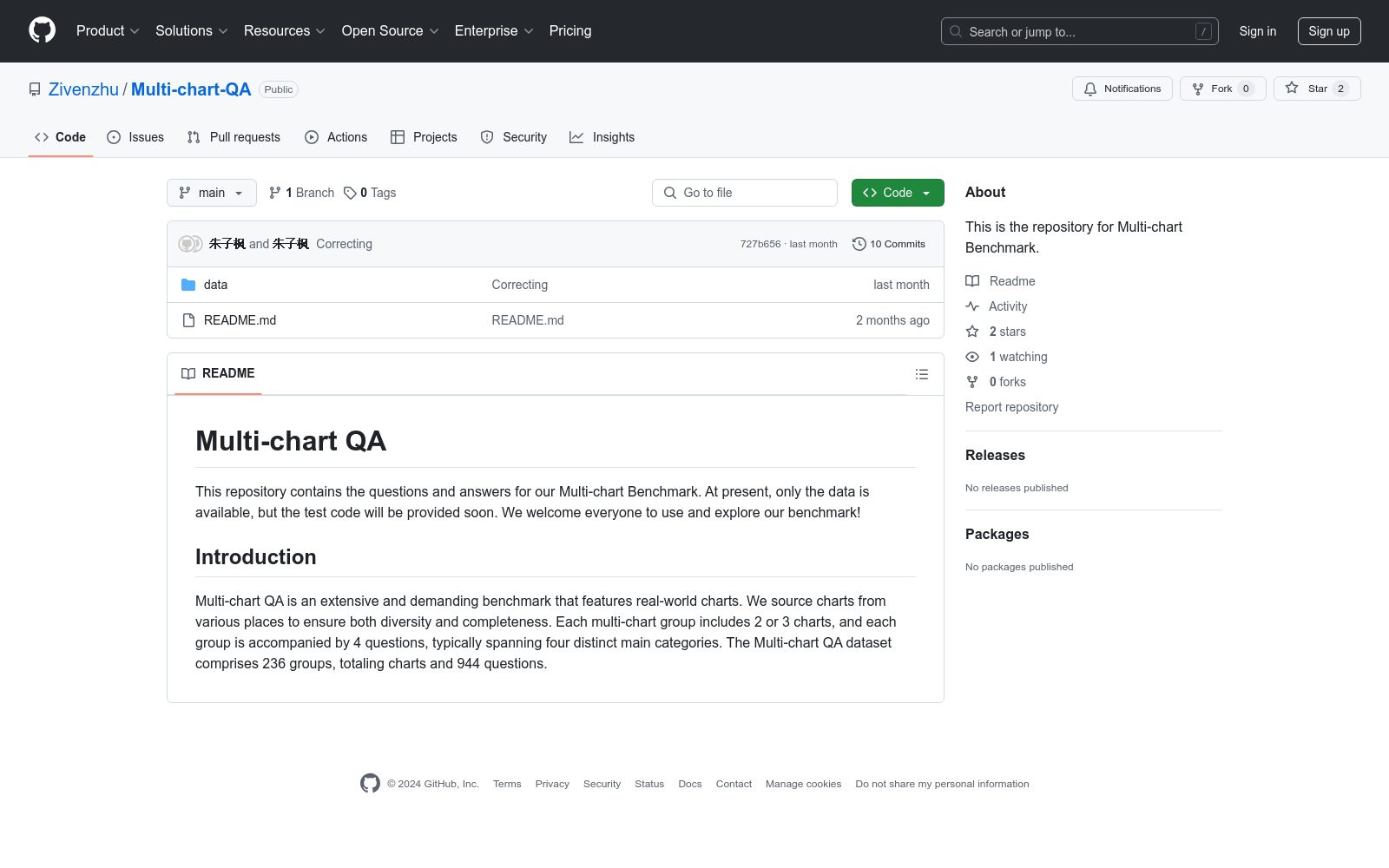

https://github.com/Zivenzhu/Multi-chart-QA

下载链接

链接失效反馈资源简介:

MultiChartQA 是一个用于评估多模态大语言模型(MLLMs)在多图表场景中能力的基准数据集。该数据集由西安交通大学和圣母大学的研究团队创建,包含来自ArXiv、OECD、OWID和Pew Research Center的655个图表和944个问题。数据集设计了四种问题类型,涵盖直接问答、并行问答、比较推理和顺序推理,旨在全面评估模型在多图表理解中的能力。数据集的创建过程包括从多个公共资源中收集图表,并手动注释问题和答案,以确保高质量。MultiChartQA 主要应用于多图表理解和视觉问答领域,旨在解决现有基准在复杂多图表场景中的不足。

提供机构:

西安交通大学, 圣母大学

创建时间:

2024-10-18

原始信息汇总

Multi-chart QA 数据集概述

简介

Multi-chart QA 是一个广泛且具有挑战性的基准测试数据集,包含真实世界的图表。数据集中的图表来自多个来源,以确保多样性和完整性。每个多图表组包含2到3个图表,每个组伴随4个问题,通常涵盖四个不同的主要类别。

数据集规模

- 数据集包含236个多图表组。

- 总计包含944个问题。

AI搜集汇总

数据集介绍

构建方式

MultiChartQA 数据集的构建旨在填补现有图表理解基准在处理多图表场景中的不足。该数据集从多个公开资源中收集了包含多图表的文章,包括 Arxiv、OECD、OWID 和 Pew Research Center。通过这些资源,设计了四种不同类型的问题,每种问题类型都与同一文章中的多个图表配对:直接问答、并行问答、比较推理和顺序推理。所有问题和答案均经过人工标注以确保高质量。

特点

MultiChartQA 数据集的显著特点在于其复杂性和多样性。它不仅涵盖了单图表任务中常见的直接问答,还引入了需要跨图表进行多跳推理的并行问答、比较推理和顺序推理任务。这种设计使得数据集能够全面评估多模态大语言模型在处理实际应用中常见多图表场景的能力。

使用方法

MultiChartQA 数据集适用于评估和提升多模态大语言模型在多图表理解任务中的表现。使用该数据集时,模型需要能够准确识别相关图表,提取并整合来自多个图表的信息,进行多跳推理以得出正确答案。数据集提供了详细的评估指标和脚本,便于研究人员和开发者进行模型性能的量化评估和改进。

背景与挑战

背景概述

MultiChartQA 数据集由西安交通大学和圣母大学的研究人员于近期创建,旨在评估多模态大语言模型(MLLMs)在多图表场景中的能力。该数据集的核心研究问题是如何在实际应用中,如新闻文章和科学文档中,处理涉及多个图表的信息整合和多步推理任务。MultiChartQA 通过引入四种关键任务类型——直接问答、并行问答、比较推理和顺序推理,填补了现有图表理解基准在多图表场景中的空白。这一创新显著提升了对 MLLMs 在复杂图表理解任务中表现的评估能力,推动了该领域的发展。

当前挑战

MultiChartQA 数据集面临的挑战主要集中在两个方面。首先,解决领域问题的挑战在于如何有效地从多个图表中提取和整合信息,这需要模型具备高级的多图表编码、精确的信息定位和多步推理能力。其次,构建过程中遇到的挑战包括数据集的收集和标注,由于多图表场景的复杂性,确保每个问题和答案的高质量标注是一项耗时且资源密集的任务。此外,现有模型在处理多图表任务时表现出的显著性能差距,也凸显了进一步提升 MLLMs 在复杂图表理解任务中能力的迫切需求。

常用场景

经典使用场景

MultiChartQA 数据集的经典使用场景在于评估多模态大语言模型(MLLMs)在多图表场景中的能力。该数据集通过设计四种关键任务:直接问答、并行问答、比较推理和顺序推理,全面测试模型在处理多个图表时的信息提取和整合能力。例如,模型需要从多个图表中提取信息,进行多步推理以回答复杂问题,这在实际应用如新闻文章和科学文档中非常常见。

衍生相关工作

MultiChartQA 数据集的推出催生了一系列相关研究工作,特别是在多模态大语言模型的改进和优化方面。研究者们通过使用该数据集进行模型训练和评估,提出了多种增强模型多图表处理能力的方法,如链式推理(Chain of Thought)和多图像编码技术。此外,该数据集还激发了对图表理解任务的进一步细分研究,推动了图表数据提取和信息整合技术的进步。

数据集最近研究

最新研究方向

在多模态大语言模型(MLLMs)领域,MultiChartQA数据集的出现填补了现有图表相关任务基准在多图表场景复杂性捕捉方面的不足。当前的研究方向主要集中在通过MultiChartQA评估MLLMs在四个关键领域的性能:直接问答、并行问答、比较推理和顺序推理。这些任务不仅要求模型能够准确识别包含所需信息的特定图表,还需要在多个图表之间进行信息整合和多跳推理。研究结果表明,尽管MLLMs在视觉问答和图表理解等任务中表现出色,但在处理多图表场景时仍存在显著性能差距。MultiChartQA的引入不仅揭示了多图表理解的挑战,还为推动该领域的发展提供了新的动力和方向。

相关研究论文

- 1MultiChartQA: Benchmarking Vision-Language Models on Multi-Chart Problems西安交通大学, 圣母大学 · 2024年

以上内容由AI搜集并总结生成