GUI-Xplore|GUI自动化数据集|跨任务泛化数据集

收藏GUI-Xplore数据集概述

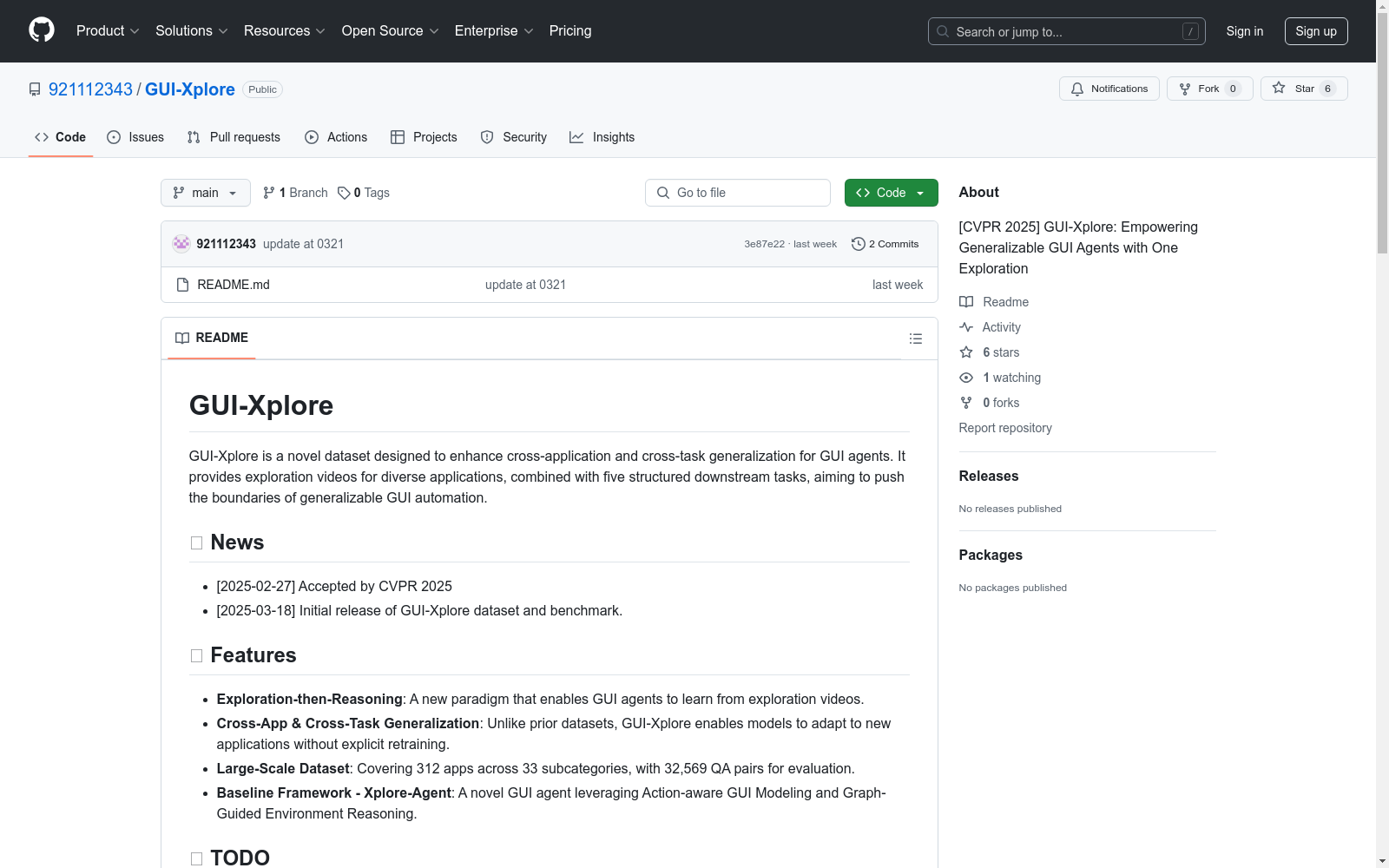

1. 数据集简介

- 名称:GUI-Xplore

- 目的:增强GUI代理在跨应用和跨任务场景中的泛化能力

- 特点:提供探索视频和结构化下游任务,推动通用GUI自动化的发展

- 学术认可:被CVPR 2025接收

2. 核心特性

- 探索-推理范式:通过探索视频学习GUI代理

- 跨应用/任务泛化:无需显式重新训练即可适应新应用

- 大规模数据:

- 覆盖312个应用(33个子类别)

- 包含32,569个问答对

- 基准框架:Xplore-Agent(基于动作感知GUI建模和图引导环境推理)

3. 数据集构成

- 应用范围:6大类别(娱乐、生产力、健康、购物、旅行、新闻)

- 数据内容:

- 探索视频:115+小时

- 5个层次化下游任务:

- 应用概览

- 页面分析

- 应用使用

- 动作回忆

- 动作序列验证

4. 下载信息

- 存储位置:HuggingFace(https://huggingface.co/datasets/9211sun/GUI-Xplore)

- 数据格式:

- .mp4(视频)

- .json/.png(标注)

5. 基准模型(Xplore-Agent)

- 核心技术:

- 动作感知GUI建模

- 图引导环境推理

- 处理流程:

- 动作感知关键帧提取

- 视图层次结构生成

- GUI聚类

- GUI转换图构建

- 任务特定推理

6. 基准测试结果

跨应用泛化性能

| 方法 | 元素准确率 | 操作准确率 | StepSR |

|---|---|---|---|

| Xplore-Agent | 30.73% | 84.63% | 30.39% |

多任务评估

| 方法 | 综合得分 |

|---|---|

| Xplore-Agent | 64.24% |

7. 引用方式

bibtex @article{your2025gui-xplore, title = {GUI-Xplore: Exploration-Guided Generalization for GUI Agents}, author = {Yuchen Sun, Shanhui Zhao, Tao Yu, Hao Wen, Samith Va, Mengwei Xu, Yuanchun Li, Chongyang Zhang}, journal = {CVPR 2025}, year = {2025} }

8. 联系方式

- 邮箱:sunyc22@sjtu.edu.cn

- GitHub Issues:通过仓库提交问题

Open Power System Data

Open Power System Data is a free-of-charge data platform dedicated to electricity system researchers. We collect, check, process, document, and publish data that are publicly available but currently inconvenient to use. The project is a service provider to the modeling community: a supplier of a public good. Learn more about its background or just go ahead and explore the data platform.

re3data.org 收录

中国交通事故深度调查(CIDAS)数据集

交通事故深度调查数据通过采用科学系统方法现场调查中国道路上实际发生交通事故相关的道路环境、道路交通行为、车辆损坏、人员损伤信息,以探究碰撞事故中车损和人伤机理。目前已积累深度调查事故10000余例,单个案例信息包含人、车 、路和环境多维信息组成的3000多个字段。该数据集可作为深入分析中国道路交通事故工况特征,探索事故预防和损伤防护措施的关键数据源,为制定汽车安全法规和标准、完善汽车测评试验规程、

北方大数据交易中心 收录

学生课堂行为数据集 (SCB-dataset3)

学生课堂行为数据集(SCB-dataset3)由成都东软学院创建,包含5686张图像和45578个标签,重点关注六种行为:举手、阅读、写作、使用手机、低头和趴桌。数据集覆盖从幼儿园到大学的不同场景,通过YOLOv5、YOLOv7和YOLOv8算法评估,平均精度达到80.3%。该数据集旨在为学生行为检测研究提供坚实基础,解决教育领域中学生行为数据集的缺乏问题。

arXiv 收录

PCLT20K

PCLT20K数据集是由湖南大学等机构创建的一个大规模PET-CT肺癌肿瘤分割数据集,包含来自605名患者的21,930对PET-CT图像,所有图像都带有高质量的像素级肿瘤区域标注。该数据集旨在促进医学图像分割研究,特别是在PET-CT图像中肺癌肿瘤的分割任务。

arXiv 收录

TCIA

TCIA(The Cancer Imaging Archive)是一个公开的癌症影像数据集,包含多种癌症类型的医学影像数据,如CT、MRI、PET等。这些数据通常与临床和病理信息相结合,用于癌症研究和临床试验。

www.cancerimagingarchive.net 收录