DeFi-Protocol-Data-on-Ethereum-2023-2024|去中心化金融数据集|以太坊数据集

收藏数据集概述

数据集基本信息

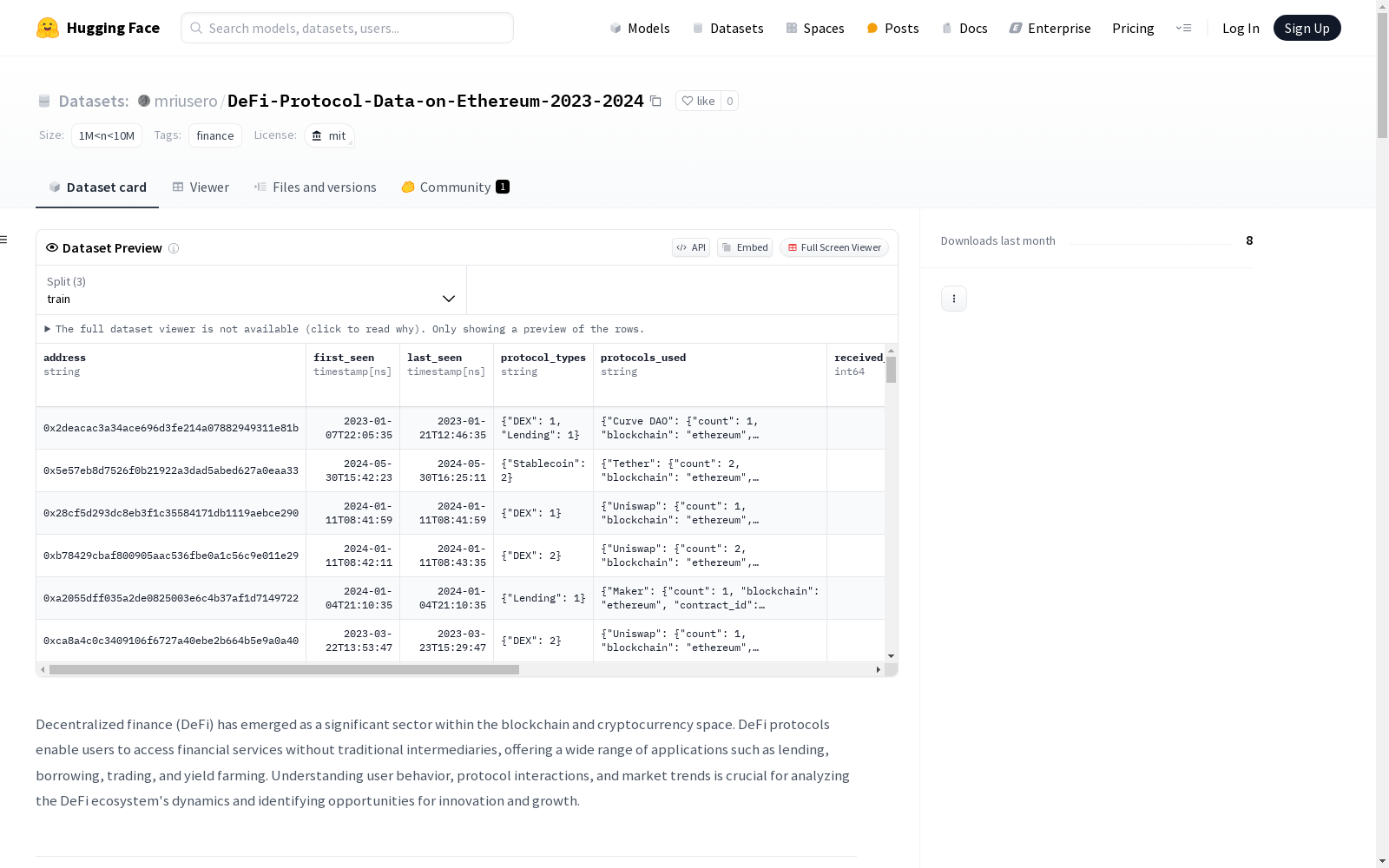

- 数据集名称: DeFi-Protocol-Data-on-Ethereum-2023-2024

- 许可证: MIT

- 标签: finance

- 数据规模: 1M < n < 10M

数据集描述

该数据集旨在分析以太坊区块链上的去中心化金融(DeFi)协议和交易。数据集涵盖了用户行为、协议交互、交易动态和市场趋势的分析,提供了对DeFi生态系统的全面洞察。

数据集结构

数据集包含以下文件:

- contracts.parquet: 包含选定DeFi协议的合约详细信息。

- transactions.parquet: 包含以太坊合约的交易数据。

- market.parquet: 包含带有聚合交易指标的市场数据。

- users.parquet: 基于交易数据的用户档案。

时间范围

- 开始时间: 2022-12-31T22:59:59.000Z

- 结束时间: 2024-12-30T23:00:11.000Z

文件目标

users.parquet

- 目标: 分析用户行为、活动趋势和协议交互。

- 潜在用例:

- 分析用户在DeFi中的活动生命周期。

- 识别活跃用户或休眠用户。

- 映射用户与各种协议之间的交互。

market.parquet

- 目标: 提供市场相关数据的聚合,洞察协议表现和市场动态。

- 潜在用例:

- 理解DeFi协议和代币的市场趋势。

- 分析交易量、交易活动和价格波动。

- 识别特定代币或协议的高活动期或低活动期。

transactions.parquet

- 目标: 提供交易级别的数据,理解DeFi生态系统中的资金流动。

- 潜在用例:

- 追踪地址之间的资金流动。

- 分析交易成本(gas)和失败率。

- 识别异常或欺诈交易。

contracts.parquet

- 目标: 记录与各种DeFi协议相关的智能合约详细信息。

- 潜在用例:

- 按协议、类型和用例分类合约。

- 分析特定合约标准(如ERC-20、ERC-721)的采用情况。

- 探索合约属性与协议表现之间的关系。

数据来源

- CoinGecko API: 用于获取DeFi协议及其市场详细信息的合约数据。

- Etherscan API: 用于提取以太坊智能合约的交易数据。

- Yahoo Finance API: 用于获取市场数据,包括代币的开盘价、最高价、最低价、收盘价(OHLC)和交易量。

- MongoDB: 用于管理和存储大量交易和协议数据。

- Ethereum Blockchain: 作为支持这些协议和交易的去中心化金融基础设施。

变量描述

users.parquet

address: 用户的钱包地址。first_seen: 用户的首次活动记录时间。last_seen: 用户的最近活动记录时间。protocol_types: 用户交互的协议类型。protocols_used: 用户交互的具体协议。received_count: 用户接收的交易总数。total_received (ETH): 用户接收的ETH总量。sent_count: 用户发送的交易总数。total_sent (ETH): 用户发送的ETH总量。transactions: 用户参与的交易总数。

market.parquet

timestamp: 数据记录的时间。blockchain: 区块链网络(如以太坊、币安智能链)。protocol_name: 与数据相关的协议名称。symbol: 加密货币或代币的符号。type: 资产类型(如代币、NFT)。contract_address: 与资产相关的合约地址。open (usd): 时间间隔内的开盘价(美元)。high (usd): 时间间隔内的最高价(美元)。low (usd): 时间间隔内的最低价(美元)。close (usd): 时间间隔内的收盘价(美元)。volume: 时间间隔内的总交易量。nb_tx_1h,nb_tx_24h: 过去1小时和24小时内的交易数量。total_value_eth_1h,total_value_eth_24h: 过去1小时和24小时内转移的ETH总量。total_gas_used_1h,total_gas_used_24h: 过去1小时和24小时内使用的总gas量。nb_unique_receivers_1h,nb_unique_receivers_24h: 过去1小时和24小时内的唯一接收地址数量。nb_unique_senders_1h,nb_unique_senders_24h: 过去1小时和24小时内的唯一发送地址数量。std_value_eth_1h,std_value_eth_24h: 过去1小时和24小时内交易值的标准差(ETH)。std_gas_used_1h,std_gas_used_24h: 过去1小时和24小时内使用的gas的标准差。avg_gas_used_1h,avg_gas_used_24h: 过去1小时和24小时内使用的平均gas量。avg_value_eth_per_tx_1h,avg_value_eth_per_tx_24h: 过去1小时和24小时内每笔交易的平均ETH值。max_gas_used_1h,max_gas_used_24h: 过去1小时和24小时内使用的最大gas量。max_value_eth_1h,max_value_eth_24h: 过去1小时和24小时内转移的最大ETH值。median_value_eth_1h,median_value_eth_24h: 过去1小时和24小时内交易值的中位数(ETH)。min_gas_used_1h,min_gas_used_24h: 过去1小时和24小时内使用的最小gas量。min_value_eth_1h,min_value_eth_24h: 过去1小时和24小时内转移的最小ETH值。num_errors_1h,num_errors_24h: 过去1小时和24小时内的错误数量。error_rate_1h,error_rate_24h: 过去1小时和24小时内的错误率。

transactions.parquet

timestamp: 交易发生的时间。transaction_hash: 交易的唯一哈希标识。from: 发送方的钱包地址。to: 接收方的钱包地址。value (ETH): 转移的ETH值。gas: 交易指定的gas限制。gas_used: 交易实际使用的gas量。is_error: 指示交易是否导致错误。error_code: 错误代码(如果适用)。metadata: 与交易相关的附加元数据。

contracts.parquet

contract_address: 智能合约的唯一地址。blockchain: 合约部署的区块链网络。type: 合约类型(如ERC-20、ERC-721)。protocol_name: 合约所属的协议名称。protocol_symbol: 协议或代币的符号。description: 合约用途或功能的描述。website_url: 合约或协议的官方网站URL。

UAVDT

UAVDT是一个用于目标检测任务的数据集。

github 收录

Materials Project

材料项目是一组标有不同属性的化合物。数据集链接: MP 2018.6.1(69,239 个材料) MP 2019.4.1(133,420 个材料)

OpenDataLab 收录

中国劳动力动态调查

“中国劳动力动态调查” (China Labor-force Dynamics Survey,简称 CLDS)是“985”三期“中山大学社会科学特色数据库建设”专项内容,CLDS的目的是通过对中国城乡以村/居为追踪范围的家庭、劳动力个体开展每两年一次的动态追踪调查,系统地监测村/居社区的社会结构和家庭、劳动力个体的变化与相互影响,建立劳动力、家庭和社区三个层次上的追踪数据库,从而为进行实证导向的高质量的理论研究和政策研究提供基础数据。

中国学术调查数据资料库 收录

Nexdata/chinese_dialect

该数据集包含25,000小时的中文方言语音数据,收集自多个方言区域的本地方言使用者,涵盖闽南语、粤语、四川话、河南话、东北话、上海话、维吾尔语和藏语等。数据格式为16kHz、16bit、未压缩的wav文件,单声道。句子准确率超过95%。数据集支持的任务包括自动语音识别(ASR)和音频说话人识别。

hugging_face 收录

中国区域交通网络数据集

该数据集包含中国各区域的交通网络信息,包括道路、铁路、航空和水路等多种交通方式的网络结构和连接关系。数据集详细记录了各交通节点的位置、交通线路的类型、长度、容量以及相关的交通流量信息。

data.stats.gov.cn 收录