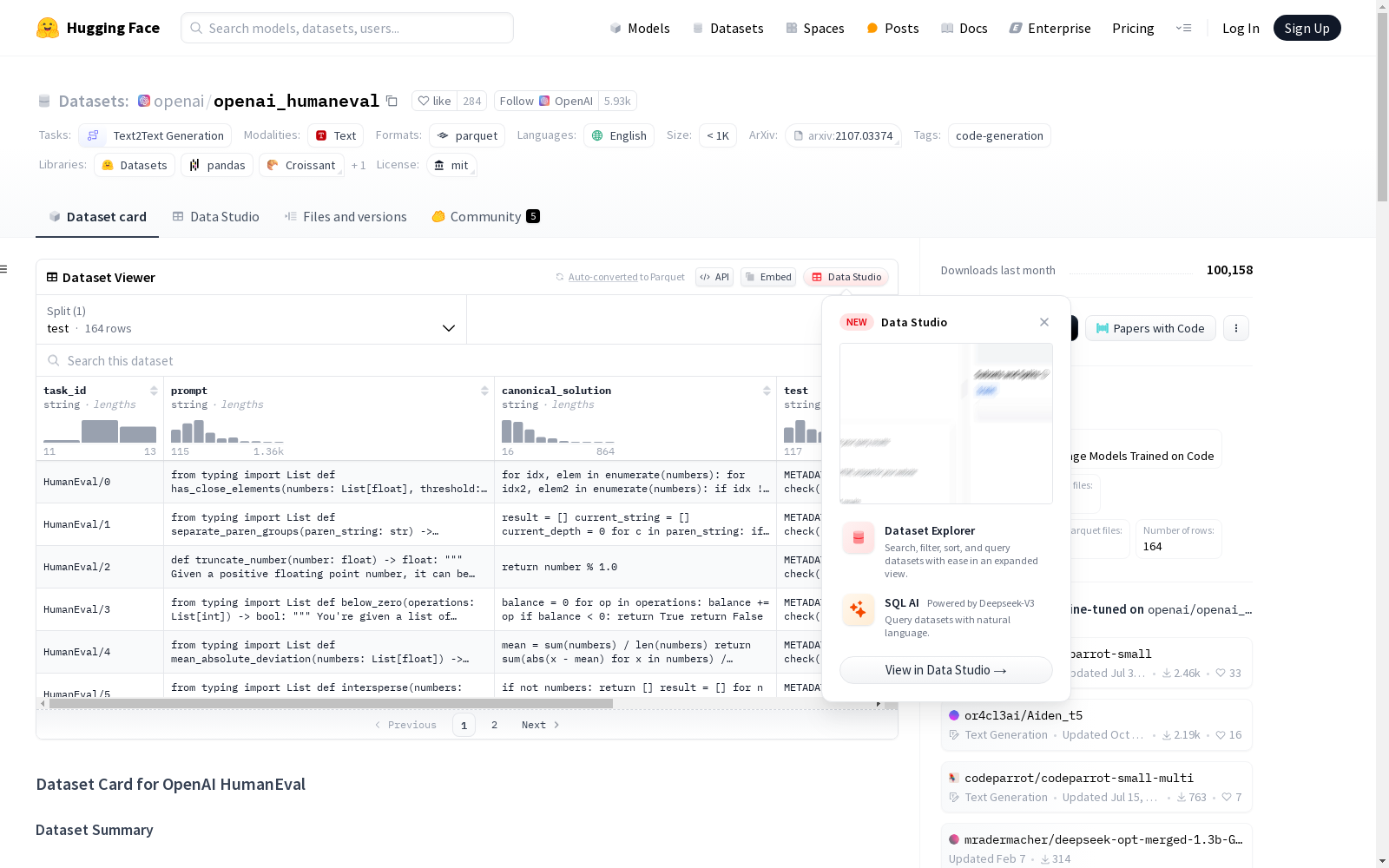

HumanEval|软件工程数据集|代码生成评估数据集

收藏

IndustryCorpus_agriculture

该数据集是通过应用22个行业数据处理操作符,从超过100TB的开放源数据集中筛选出的3.4TB高质量多行业分类的中英文预训练数据集。筛选后的数据包括1TB的中文数据和2.4TB的英文数据,并进行了12种类型的标签标注。数据集涵盖18个行业类别,包括医疗、教育、文学、金融等,并提供了各行业类别的数据大小。

huggingface 收录

中国近海台风路径集合数据集(1945-2024)

1945-2024年度,中国近海台风路径数据集,包含每个台风的真实路径信息、台风强度、气压、中心风速、移动速度、移动方向。 数据源为获取温州台风网(http://www.wztf121.com/)的真实观测路径数据,经过处理整合后形成文件,如使用csv文件需使用文本编辑器打开浏览,否则会出现乱码,如要使用excel查看数据,请使用xlsx的格式。

国家海洋科学数据中心 收录

ChineseSafe

ChineseSafe是由南方科技大学统计与数据科学系创建的一个中文安全评估基准数据集,旨在评估大型语言模型在识别中文不安全内容方面的能力。该数据集包含205,034个样本,涵盖4个类别和10个子类别的安全问题,特别关注政治敏感性、色情内容和变体/同音词等新型安全问题。数据集通过从开源数据集和互联网资源中收集数据,经过数据清洗和去重处理,确保了数据集的高质量和多样性。ChineseSafe的应用领域主要集中在大型语言模型的安全评估,旨在帮助开发者和研究者提升模型在实际应用中的安全性。

arXiv 收录

YOLO Drone Detection Dataset

为了促进无人机检测模型的开发和评估,我们引入了一个新颖且全面的数据集,专门为训练和测试无人机检测算法而设计。该数据集来源于Kaggle上的公开数据集,包含在各种环境和摄像机视角下捕获的多样化的带注释图像。数据集包括无人机实例以及其他常见对象,以实现强大的检测和分类。

github 收录

BBGRE

The Brain & Body Genetic Resource Exchange (BBGRE) provides a resource for investigating the genetic basis of neurodisability. It combines phenotype information from patients with neurodevelopmental and behavioural problems with clinical genetic data, and displays this information on the human genome map.

国家生物信息中心 收录