UnifiedReward Training Dataset|图像理解数据集|视频理解数据集

收藏github2025-03-13 更新2025-03-10 收录

下载链接:

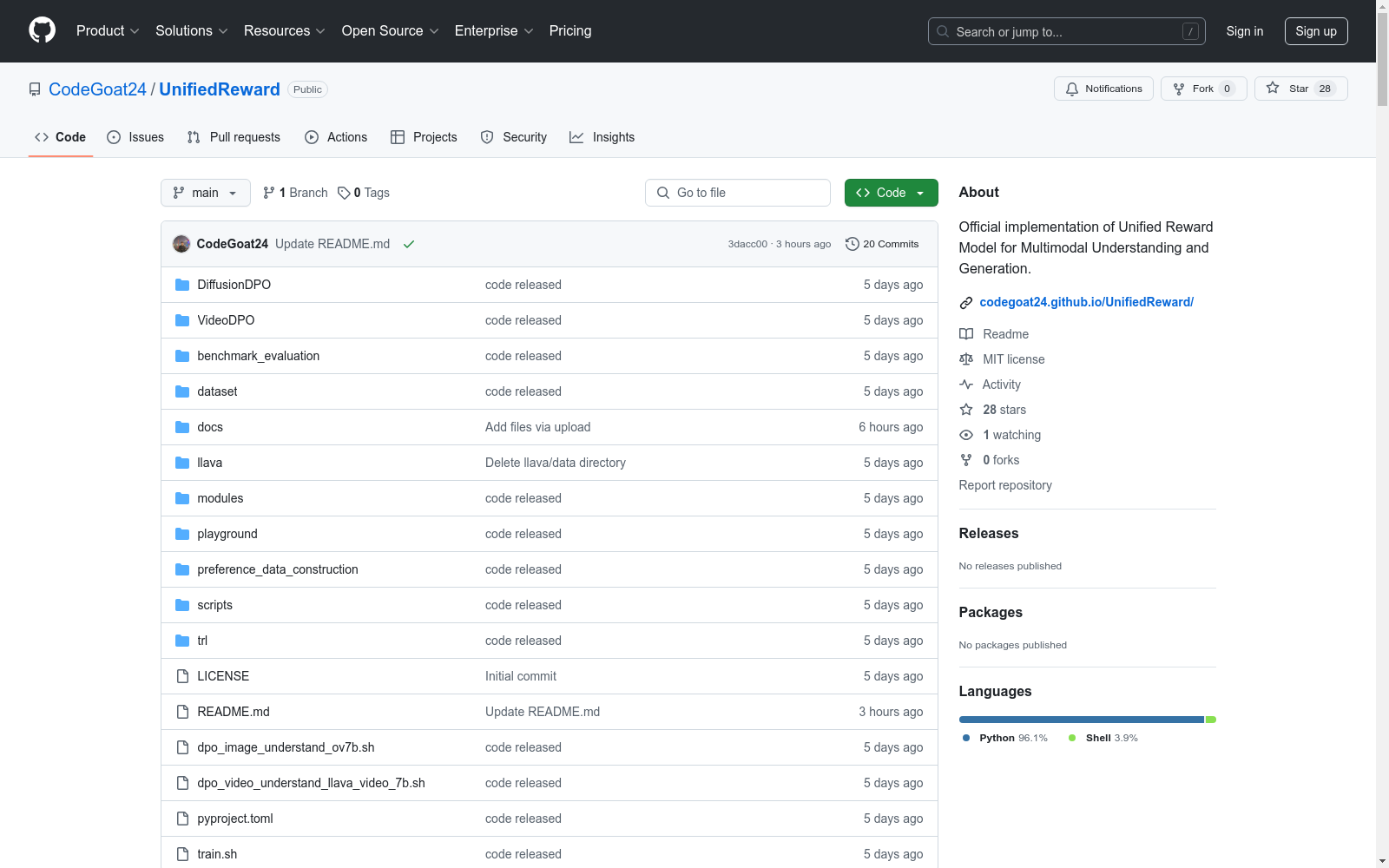

https://github.com/CodeGoat24/UnifiedReward

下载链接

链接失效反馈资源简介:

这是一个用于多模态理解和生成评估的统一训练数据集,支持成对排序和点评分,可用于视觉模型偏好对齐。

创建时间:

2025-03-04

原始信息汇总

Unified Reward Model for Multimodal Understanding and Generation

数据集概述

- 数据集名称:UnifiedReward

- 创建者:Yibin Wang, Yuhang Zang, Hao Li, Cheng Jin, Jiaqi Wang

- 所属机构:Fudan University, Shanghai Innovation Institute, Shanghai AI Lab, Shanghai Academy of AI for Science

- 数据集类型:统一奖励模型,适用于多模态理解和生成评估

- 主要特点:支持配对排名和点式评分,可用于视觉模型偏好对齐

数据集内容

-

统一偏好训练数据集:包含多个子数据集,如EvalMuse, HPD, LiFT-HRA, LLaVA-Critic, OIP, ShareGPTVideo, VideoDPO, VideoFeedback等

-

数据集结构:

dataset/ ├── EvalMuse

│ ├── pairwise

│ └── pointwise │ └── ... ├── HPD

├── LiFT-HRA ├── LLaVA-Critic │ ├── pairwise

│ └── pointwise │ └── ... ├── OIP ├── ShareGPTVideo │ ├── pairwise

│ └── pointwise │ └── ... ├── VideoDPO ├── VideoFeedback └── train_data.yaml

数据集使用

- 环境搭建:使用conda创建python环境,安装必要的依赖

- 训练:使用提供的脚本进行统一奖励模型的训练

- 偏好优化:提供图像和视频理解和生成的直接偏好优化代码和训练流程

评估

- 评估代码:提供多个评估代码,支持多种基准测试,如GenAI-Bench-Video, GenAI-Bench-Image, VideoGen-RewardBench, VL-RewardBench等

- 评估工具:使用LMMs-Eval和VLMEvalKit工具包进行评估

联系方式

- 问题反馈:通过GitHub issues或直接联系Yibin Wang

致谢

- 基于的项目:LLaVA-Next, DiffusionDPO, VideoDPO, LMMs-Eval, VLMEvalKit

引用

- 引用格式:待提供

AI搜集汇总

数据集介绍

构建方式

UnifiedReward训练数据集的构建采用了一种统一的多模态理解和生成评估框架,该框架既支持成对排序又支持点评分,能够应用于视觉模型偏好对齐。数据集包含了多种类型的数据,如图片、视频、文本等,旨在为多模态任务提供全面的数据支持。

特点

该数据集的特点在于其统一性、多样性和全面性。它不仅涵盖了图像和视频生成、理解和评估的数据,还包括了成对和点式的偏好数据,能够满足不同类型的多模态任务需求。此外,数据集在Huggingface平台提供,便于用户获取和使用。

使用方法

使用该数据集时,用户首先需要从Huggingface平台下载数据集,并将其放置在指定目录下。然后,根据具体的任务类型,用户需要按照数据集的结构准备训练数据,并运行相应的训练脚本。对于不同的多模态任务,如图像理解、视频理解、图像生成和视频生成,都有相应的偏好数据构造和训练流程。

背景与挑战

背景概述

UnifiedReward训练数据集是由Yibin Wang、Yuhang Zang、Hao Li、Cheng Jin和Jiaqi Wang等研究人员于2025年创建,隶属于复旦大学、上海创新研究院、上海AI实验室和上海科学院AI科研团队。该数据集旨在支持统一奖励模型的研究,该模型适用于多模态理解和生成评估,能够实现成对排序和点式评分,进而用于视觉模型偏好对齐。UnifiedReward模型的发布,为多模态交互领域的模型评估提供了新的方法和工具,具有重要的研究价值和广泛的应用前景。

当前挑战

该数据集在构建过程中面临的挑战主要包括:1) 多模态数据的一致性处理,确保图像、视频等不同类型数据在统一框架下的有效融合;2) 偏好数据的构建与标注,需要大量的人力物力投入,且主观性较强,难以保证数据的一致性和准确性;3) 数据集的规模和多样性,为了使模型具有更强的泛化能力,需要大量且多样的数据支持。在所解决的领域问题上,UnifiedReward模型面临的挑战包括:如何准确捕捉用户的偏好,生成符合用户期望的内容,以及在多模态交互中如何实现有效的理解和生成评估。

常用场景

经典使用场景

UnifiedReward训练数据集是首个用于多模态理解和生成评估的统一奖励模型的数据集,其经典使用场景在于支持视觉模型偏好对齐,通过提供成对的排名和点式评分,为多模态任务中的图像生成、图像理解、视频生成和视频理解提供评估标准。

实际应用

实际应用中,UnifiedReward训练数据集可用于优化多模态系统的性能,例如在图像和视频生成、理解等领域,通过直接偏好优化方法,提升模型的生成质量和理解能力。

衍生相关工作

基于该数据集,衍生出了多项相关工作,包括图像和视频的直接偏好优化方法,以及针对不同多模态任务的评估基准,这些工作进一步推动了多模态理解和生成领域的研究进展。

以上内容由AI搜集并总结生成