alexshengzhili/mllm-dpo|多模态语言模型数据集|视觉问答数据集

收藏数据集概述

模型与数据集设计

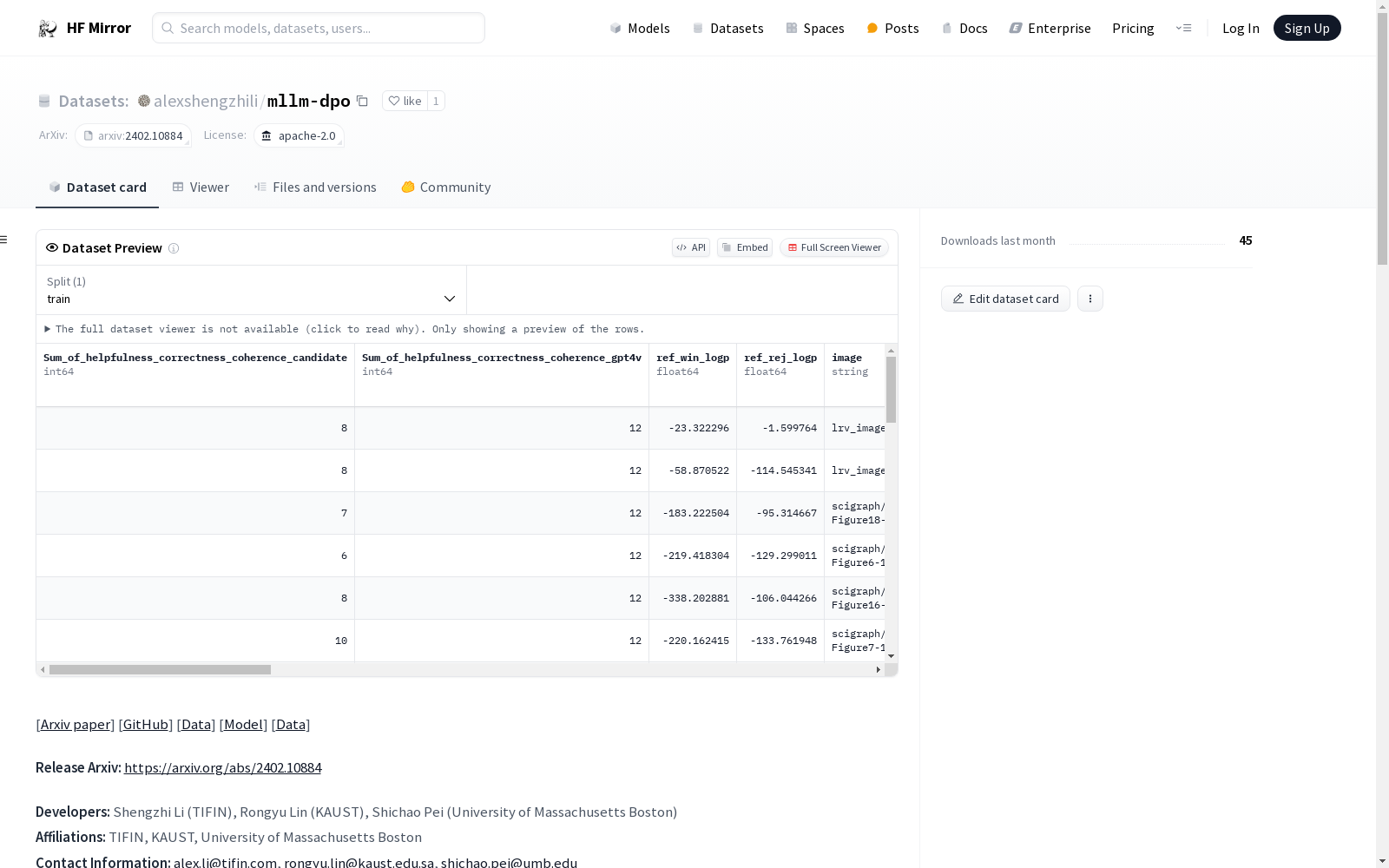

- 目的: 提升多模态大型语言模型(MLLMs)的指令遵循能力,特别是在视觉指令调优可能降低语言熟练度的场景中。

- 技术: 采用直接偏好优化(DPO)方法和6K条目VQA偏好数据集。

预期用途

- 主要应用: 文本和图像模态整合任务,如视觉问答(VQA)、图像标注和多模态指令遵循。

- 目标用户: 自然语言处理、计算机视觉和多模态AI领域的研究者和实践者。

训练数据

- 数据集: 使用6K条目的轻量级VQA偏好数据集,针对5个质量指标进行细致标注。

评估

- 性能提升: 在多个基准测试中超越基线模型,如Vicuna和LLaVA。

- 具体成绩: 在MT-Bench上得分6.73,MM-Vet上提升4.9%,LLaVA-Bench上提升6%。

伦理考量

- 关注点: 用户应考虑训练数据和模型输出中可能存在的偏见和局限性,特别是在多样化和敏感环境中部署时。

限制

- 数据集大小: 6K条目的数据集可能限制模型在更广泛或多样的多模态任务中的泛化能力。

- 性能评估: 性能提升基于当前评估的基准和数据集,可能在不同或更具挑战性的环境中表现不同。

致谢

- 贡献者: Shengzhi Li, Rongyu Lin, Shichao Pei。

- 支持机构: TIFIN, KAUST, University of Massachusetts Boston。

引用信息

- 引用格式: bibtex @misc{li2024multimodal, title={Multi-modal preference alignment remedies regression of visual instruction tuning on language model}, author={Shengzhi Li and Rongyu Lin and Shichao Pei}, year={2024}, eprint={2402.10884}, archivePrefix={arXiv}, primaryClass={cs.CL} }

CE-CSL

CE-CSL数据集是由哈尔滨工程大学智能科学与工程学院创建的中文连续手语数据集,旨在解决现有数据集在复杂环境下的局限性。该数据集包含5,988个从日常生活场景中收集的连续手语视频片段,涵盖超过70种不同的复杂背景,确保了数据集的代表性和泛化能力。数据集的创建过程严格遵循实际应用导向,通过收集大量真实场景下的手语视频材料,覆盖了广泛的情境变化和环境复杂性。CE-CSL数据集主要应用于连续手语识别领域,旨在提高手语识别技术在复杂环境中的准确性和效率,促进聋人与听人社区之间的无障碍沟通。

arXiv 收录

MUStARD++

MUStARD++是一个多模态讽刺检测数据集,由萨里大学创建,旨在通过语言、语音和视觉线索全面捕捉讽刺现象。数据集包含1202个视频样本,来源于多个流行电视节目,通过手动标注确保高质量的讽刺标签。创建过程中,研究者们通过多轮标注和验证确保数据的准确性和多样性。该数据集主要应用于自动讽刺检测,帮助机器理解并识别讽刺语境,解决讽刺识别中的多模态挑战。

arXiv 收录

中国农村金融统计数据

该数据集包含了中国农村金融的统计信息,涵盖了农村金融机构的数量、贷款余额、存款余额、金融服务覆盖率等关键指标。数据按年度和地区分类,提供了详细的农村金融发展状况。

www.pbc.gov.cn 收录

GME Data

关于2021年GameStop股票活动的数据,包括每日合并的GME短期成交量数据、每日失败交付数据、可借股数、期权链数据以及不同时间框架的开盘/最高/最低/收盘/成交量条形图。

github 收录

Breast Cancer Dataset

该项目专注于清理和转换一个乳腺癌数据集,该数据集最初由卢布尔雅那大学医学中心肿瘤研究所获得。目标是通过应用各种数据转换技术(如分类、编码和二值化)来创建一个可以由数据科学团队用于未来分析的精炼数据集。

github 收录