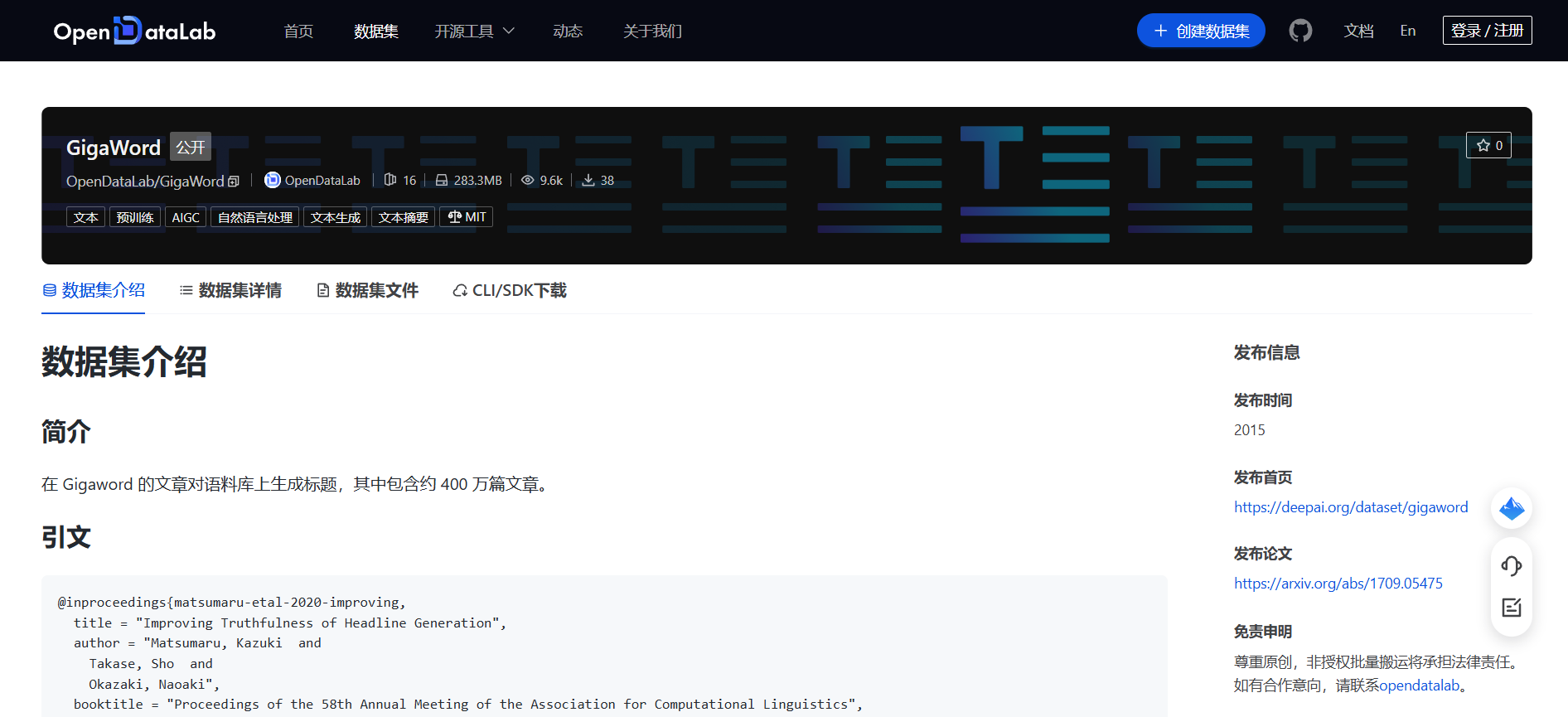

GigaWord|自然语言处理数据集|文本摘要数据集

收藏

- GigaWord数据集首次发表,包含超过10亿个中文词汇,标志着大规模中文文本数据集的诞生。

- GigaWord数据集首次应用于自然语言处理研究,特别是在中文信息检索和机器翻译领域,显著提升了模型的性能。

- GigaWord数据集的扩展版本发布,增加了更多的语料和多样性,进一步推动了中文自然语言处理技术的发展。

- GigaWord数据集被广泛应用于深度学习模型训练,特别是在神经机器翻译和文本分类任务中,成为重要的基准数据集。

- GigaWord数据集的最新版本发布,引入了更多的领域和语种,继续为中文自然语言处理研究提供丰富的资源。

- 1Gigaword Corpus: Third EditionLinguistic Data Consortium (LDC) · 2011年

- 2A Neural Attention Model for Abstractive Sentence SummarizationUniversity of Cambridge · 2015年

- 3Deep Recurrent Generative Decoder for Abstractive Text SummarizationUniversity of Science and Technology of China · 2017年

- 4A Survey on Neural Network-Based Summarization MethodsUniversity of Edinburgh · 2018年

- 5Multi-News: A Large-Scale Multi-Document Summarization Dataset and Abstractive Hierarchical ModelNew York University · 2019年

中国劳动力动态调查

“中国劳动力动态调查” (China Labor-force Dynamics Survey,简称 CLDS)是“985”三期“中山大学社会科学特色数据库建设”专项内容,CLDS的目的是通过对中国城乡以村/居为追踪范围的家庭、劳动力个体开展每两年一次的动态追踪调查,系统地监测村/居社区的社会结构和家庭、劳动力个体的变化与相互影响,建立劳动力、家庭和社区三个层次上的追踪数据库,从而为进行实证导向的高质量的理论研究和政策研究提供基础数据。

中国学术调查数据资料库 收录

Yahoo Finance

Dataset About finance related to stock market

kaggle 收录

马达加斯加岛 – 世界地理数据大百科辞条

马达加斯加岛在非洲的东南部,位于11o56′59″S - 25o36′25″S及43o11′18″E - 50o29′36″E之间。通过莫桑比克海峡与位于非洲大陆的莫桑比克相望,最近距离为415千米。临近的岛屿分别为西北部的科摩罗群岛、北部的塞舌尔群岛、东部的毛里求斯岛和留尼汪岛等。在google earth 2015年遥感影像基础上研发的马达加斯加海岸线数据集表明,马达加斯加岛面积591,128.68平方千米,其中马达加斯加本岛面积589,015.06平方千米,周边小岛面积为2,113.62平方千米。马达加斯加本岛是非洲第一大岛,是仅次于格陵兰、新几内亚岛和加里曼丹岛的世界第四大岛屿。岛的形状呈南北走向狭长纺锤形,南北向长1,572千米;南北窄,中部宽,最宽处达574千米。海岸线总长16,309.27千米, 其中马达加斯加本岛海岸线长10,899.03千米,周边小岛海岸线长5,410.24千米。马达加斯加岛属于马达加斯加共和国。全国共划分22个区,119个县。22个区分别为:阿那拉芒加区,第亚那区,上马齐亚特拉区,博爱尼区,阿齐那那那区,阿齐莫-安德列发那区,萨瓦区,伊达西区,法基南卡拉塔区,邦古拉法区,索非亚区,贝齐博卡区,梅拉基区,阿拉奥特拉-曼古罗区,阿那拉兰基罗富区,阿莫罗尼马尼亚区,法土法韦-非图韦那尼区,阿齐莫-阿齐那那那区,伊霍罗贝区,美那贝区,安德罗伊区和阿诺西区。首都安塔那那利佛(Antananarivo)位于岛屿的中东部。马达加斯加岛是由火山及喀斯特地貌为主。贯穿海岛的是巨大火山岩山体-察腊塔纳山,其主峰马鲁穆库特鲁山(Maromokotro)海拔2,876米,是全国最高峰。马达加斯加自然景观垂直地带性分异显著,是热带雨林和热带草原广布的地区。岛上大约有20多万种动植物,其中包括马达加斯加特有物种狐猴(Lemur catta)、马达加斯加国树猴面包树(Adansonia digitata L.)等。

国家对地观测科学数据中心 收录

CE-CSL

CE-CSL数据集是由哈尔滨工程大学智能科学与工程学院创建的中文连续手语数据集,旨在解决现有数据集在复杂环境下的局限性。该数据集包含5,988个从日常生活场景中收集的连续手语视频片段,涵盖超过70种不同的复杂背景,确保了数据集的代表性和泛化能力。数据集的创建过程严格遵循实际应用导向,通过收集大量真实场景下的手语视频材料,覆盖了广泛的情境变化和环境复杂性。CE-CSL数据集主要应用于连续手语识别领域,旨在提高手语识别技术在复杂环境中的准确性和效率,促进聋人与听人社区之间的无障碍沟通。

arXiv 收录

ReferCOCO数据集

ReferCOCO数据集包括refcoco、refcoco+和refcocog三个子集,用于视觉定位任务。数据集包含图像和对应的描述性文本,用于训练和测试模型识别图像中特定对象的能力。

github 收录