gpt-2-output-dataset|自然语言处理数据集|文本生成数据集

收藏github2022-12-09 更新2024-05-31 收录

下载链接:

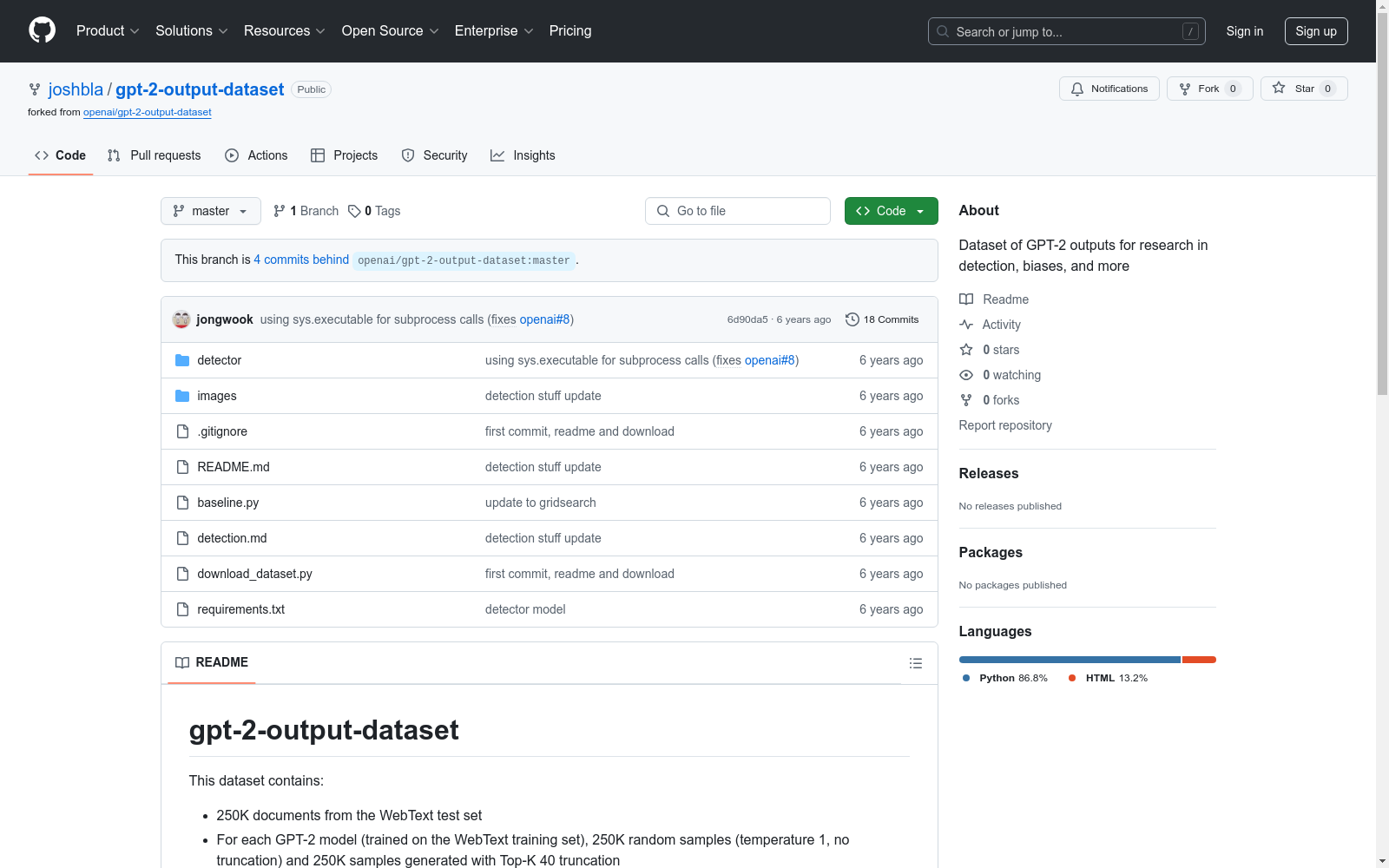

https://github.com/Ordowix/gpt-2-output-dataset

下载链接

链接失效反馈资源简介:

该数据集包含来自WebText测试集的25万个文档,以及每个GPT-2模型(基于WebText训练集训练)的25万个随机样本和25万个使用Top-K 40截断生成的样本。

This dataset comprises 250,000 documents from the WebText test set, along with 250,000 random samples from each GPT-2 model (trained on the WebText training set) and 250,000 samples generated using Top-K 40 truncation.

创建时间:

2019-11-06

原始信息汇总

gpt-2-output-dataset 数据集概述

数据集内容

- 原始数据: 包含250,000份来自WebText测试集的文档。

- 生成数据:

- 每个GPT-2模型(基于WebText训练集训练)生成的250,000个随机样本(温度1,无截断)。

- 每个GPT-2模型生成的250,000个样本,使用Top-K 40截断。

数据集结构

- 文件分布: 数据存储于Google Cloud Storage,路径为

gs://gpt-2/output-dataset/v1。 - 文件类型:

webtext.${split}.jsonlsmall-117M.${split}.jsonlsmall-117M-k40.${split}.jsonlmedium-345M.${split}.jsonlmedium-345M-k40.${split}.jsonllarge-762M.${split}.jsonllarge-762M-k40.${split}.jsonlxl-1542M.${split}.jsonlxl-1542M-k40.${split}.jsonl其中,${split}代表train、test和valid。

额外数据

- 微调模型样本: 提供了一个GPT-2全模型微调后生成的亚马逊评论样本,存储路径为

gs://gpt-2/output-dataset/v1-amazonfinetune/。

数据下载

- 下载脚本: 提供了一个名为

download_dataset.py的脚本,用于下载所有数据文件。

AI搜集汇总

数据集介绍

构建方式

gpt-2-output-dataset数据集的构建基于WebText测试集的25万份文档,并结合了不同规模的GPT-2模型生成的文本。具体而言,每个模型均生成了25万份随机样本(温度为1,无截断)以及25万份采用Top-K 40截断策略的样本。此外,数据集还包含了针对微调模型的研究数据,特别是针对亚马逊评论生成的微调模型样本。所有数据均存储在Google Cloud Storage中,便于研究者下载和使用。

特点

该数据集的特点在于其多样性和规模。它不仅涵盖了WebText测试集的原始文档,还包含了多种GPT-2模型生成的文本,涵盖了从117M到1542M不同规模的模型。此外,数据集还提供了随机生成和Top-K 40截断生成的对比样本,为研究生成文本的检测性提供了丰富的数据基础。特别值得一提的是,数据集还包含了微调模型的生成样本,为研究微调模型的检测性提供了独特的数据支持。

使用方法

使用gpt-2-output-dataset时,研究者可以通过Google Cloud Storage下载数据集中的各个文件。数据集按模型规模和生成策略进行了分类,并提供了训练集、验证集和测试集的划分。下载脚本`download_dataset.py`可帮助用户快速获取所有数据。此外,数据集还提供了针对微调模型的研究数据,用户可以通过指定路径访问这些数据。研究者可以利用这些数据进行生成文本的检测性研究,或探索微调模型对生成文本检测的影响。

背景与挑战

背景概述

gpt-2-output-dataset是由OpenAI于2019年发布的一个大规模文本生成数据集,旨在支持自然语言处理领域的研究,特别是针对GPT-2模型生成的文本检测与分析。该数据集包含了从WebText测试集中提取的25万份文档,以及基于不同规模GPT-2模型生成的文本样本,涵盖了随机采样和Top-K截断两种生成策略。GPT-2作为当时最先进的生成模型,其输出文本的质量和多样性引发了广泛关注,同时也带来了文本生成检测的挑战。该数据集的发布为研究社区提供了丰富的实验材料,推动了生成模型的可解释性和安全性研究。

当前挑战

gpt-2-output-dataset的核心挑战在于如何有效检测由GPT-2模型生成的文本。尽管生成模型的输出质量接近人类写作,但其潜在的滥用风险(如虚假信息传播)使得检测技术成为研究重点。数据集中包含的随机采样和Top-K截断样本为检测算法提供了多样化的测试场景,但同时也增加了检测难度。此外,数据集的构建过程中面临了生成样本的多样性与真实性平衡问题,以及如何确保生成文本的版权合规性。这些挑战不仅推动了文本检测技术的发展,也为生成模型的伦理与安全研究提供了重要参考。

常用场景

经典使用场景

gpt-2-output-dataset数据集在自然语言处理领域中被广泛应用于生成文本的多样性和质量评估。研究者通过分析不同GPT-2模型生成的文本样本,探讨模型在不同温度参数和截断策略下的表现,从而优化文本生成算法。

解决学术问题

该数据集为解决生成文本的检测问题提供了重要支持。通过提供大量GPT-2模型生成的文本样本,研究者能够开发出更有效的检测算法,以区分人工生成文本与机器生成文本,进而提升文本生成模型的安全性和可靠性。

衍生相关工作

基于gpt-2-output-dataset,研究者们开发了多种文本检测算法和工具,如基于深度学习的分类器和基于统计特征的检测方法。这些工作不仅推动了文本生成模型的研究,还为相关领域的应用提供了技术基础。

以上内容由AI搜集并总结生成