VATE|情感计算数据集|多模态学习数据集

收藏VATE 数据集概述

概览

VATE 是一个用于情感评估的视频-音频-文本多模态数据集。该数据集收集了多种自发人类情感状态的多模态数据,包含 21,871 个原始视频以及来自多个情感诱发访谈的语音记录和文本转录。VATE 专门设计用于人类情感状态的对比自监督表示学习,优先考虑数据的数量和质量,而不是情感的人工标注,后者在现代情感计算中往往是主观、不一致和有争议的。为了突出我们提案的实用性,我们发布了一个采用对比视频-语言-音频预训练程序的多模态编码器,该程序在 VATE 数据集上进行。实验结果表明,与不同下游任务上的完全监督基线相比,该模型展现出更好的少样本泛化能力。

数据集的概览可以在以下路径找到:

sh VATE/output/VATE/metadata.json

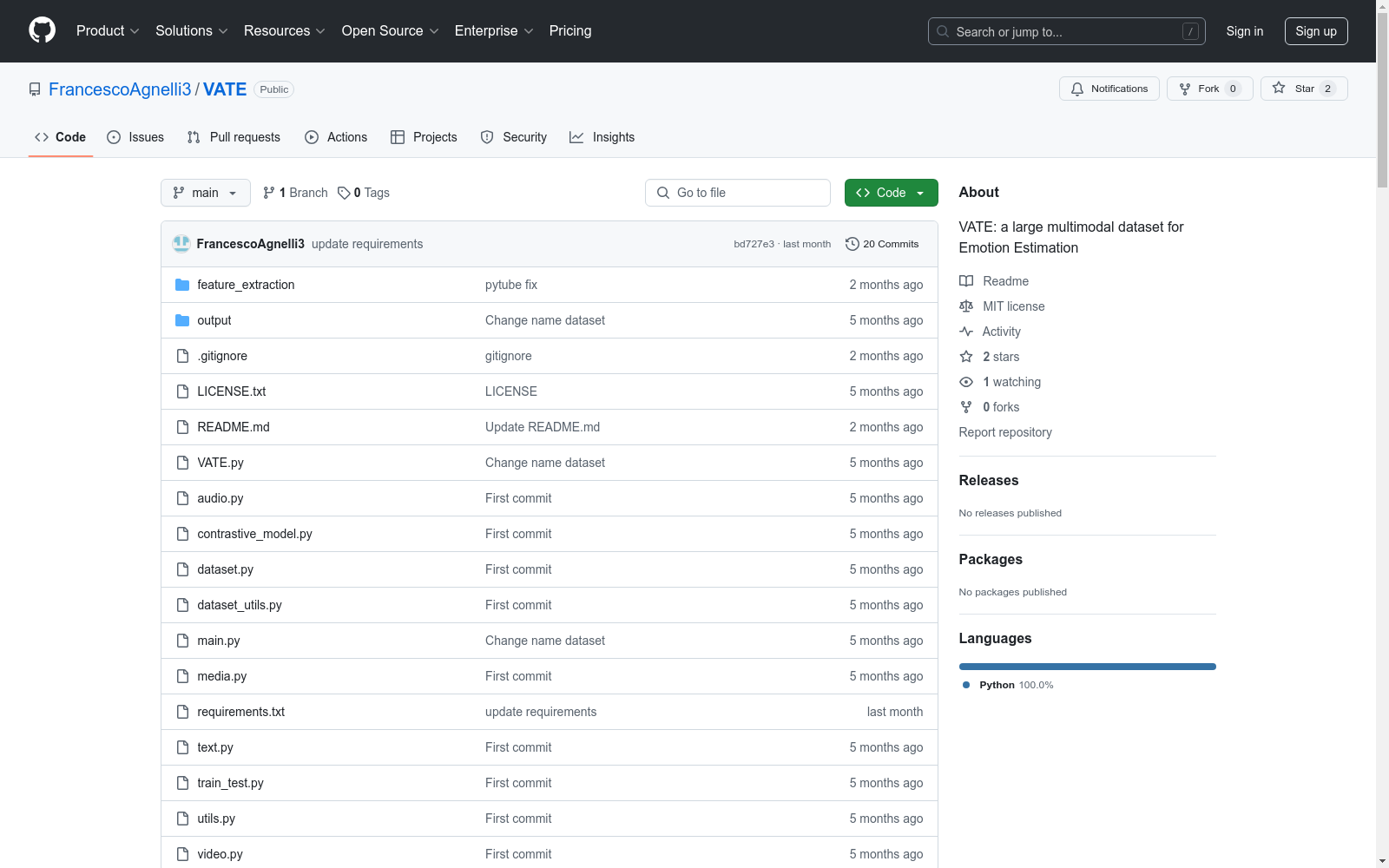

仓库结构

sh └── VATE/ ├── VATE.py ├── README.md ├── audio.py ├── contrastive_model.py ├── dataset.py ├── dataset_utils.py ├── feature_extraction │ ├── VATE │ ├── collect_yb.py │ ├── couples.txt │ ├── cut_video.py │ ├── input.txt │ ├── main.py │ └── write_video.py ├── main.py ├── media.py ├── output │ └── VATE │ ├── best_model_contrastive.pt │ └── metadata.json ├── text.py ├── train_test.py ├── utils.py └── video.py

入门指南

安装

- 克隆 VATE 仓库:

sh git clone https://github.com/FrancescoAgnelli3/VATE

- 切换到项目目录:

sh cd VATE

- 安装依赖项:

sh pip install -r requirements.txt

下载 VATE

使用以下命令下载 VATE 数据集:

- 切换到项目目录:

sh cd feature_extraction

- 下载数据集:

sh python main.py

数据集将下载到以下文件夹:

sh VATE/feature_extraction/VATE

如果你想添加其他 YouTube 播放列表到数据集,可以将其添加到 Python 文件并运行:

sh python collect_yb.py

然后再次运行:

sh python main.py

对比模型

- 在数据集上训练对比模型,切换到项目目录:

sh cd ..

- 训练模型:

sh python main.py

- 模型将保存在以下文件夹(或可以直接下载已预训练的模型):

sh VATE/output/VATE/best_model_contrastive.pt

贡献

要为项目做出贡献,请遵循以下指南:

-

fork 仓库并将其克隆到本地机器。

-

为你的功能或错误修复创建一个新分支。

-

进行更改并提交它们,并附上描述性的提交消息。

-

将你的分支推送到你 fork 的仓库。

-

向主仓库提交拉取请求。

许可证

该项目受 MIT LICENSE 许可证保护。

CE-CSL

CE-CSL数据集是由哈尔滨工程大学智能科学与工程学院创建的中文连续手语数据集,旨在解决现有数据集在复杂环境下的局限性。该数据集包含5,988个从日常生活场景中收集的连续手语视频片段,涵盖超过70种不同的复杂背景,确保了数据集的代表性和泛化能力。数据集的创建过程严格遵循实际应用导向,通过收集大量真实场景下的手语视频材料,覆盖了广泛的情境变化和环境复杂性。CE-CSL数据集主要应用于连续手语识别领域,旨在提高手语识别技术在复杂环境中的准确性和效率,促进聋人与听人社区之间的无障碍沟通。

arXiv 收录

Wind Turbine Data

该数据集包含风力涡轮机的运行数据,包括风速、风向、发电量等参数。数据记录了多个风力涡轮机在不同时间点的运行状态,适用于风能研究和风力发电系统的优化分析。

www.kaggle.com 收录

VEDAI

用于训练YOLO模型的VEDAI数据集,包含图像和标签,用于目标检测和跟踪。

github 收录

CosyVoice 2

CosyVoice 2是由阿里巴巴集团开发的多语言语音合成数据集,旨在通过大规模多语言数据集训练,实现高质量的流式语音合成。数据集通过有限标量量化技术改进语音令牌的利用率,并结合预训练的大型语言模型作为骨干,支持流式和非流式合成。数据集的创建过程包括文本令牌化、监督语义语音令牌化、统一文本-语音语言模型和块感知流匹配模型等步骤。该数据集主要应用于语音合成领域,旨在解决高延迟和低自然度的问题,提供接近人类水平的语音合成质量。

arXiv 收录

MedDialog

MedDialog数据集(中文)包含了医生和患者之间的对话(中文)。它有110万个对话和400万个话语。数据还在不断增长,会有更多的对话加入。原始对话来自好大夫网。

github 收录