u-math|数学推理数据集|多模态数据数据集

收藏huggingface2024-12-05 更新2024-12-12 收录

下载链接:

https://huggingface.co/datasets/toloka/u-math

下载链接

链接失效反馈资源简介:

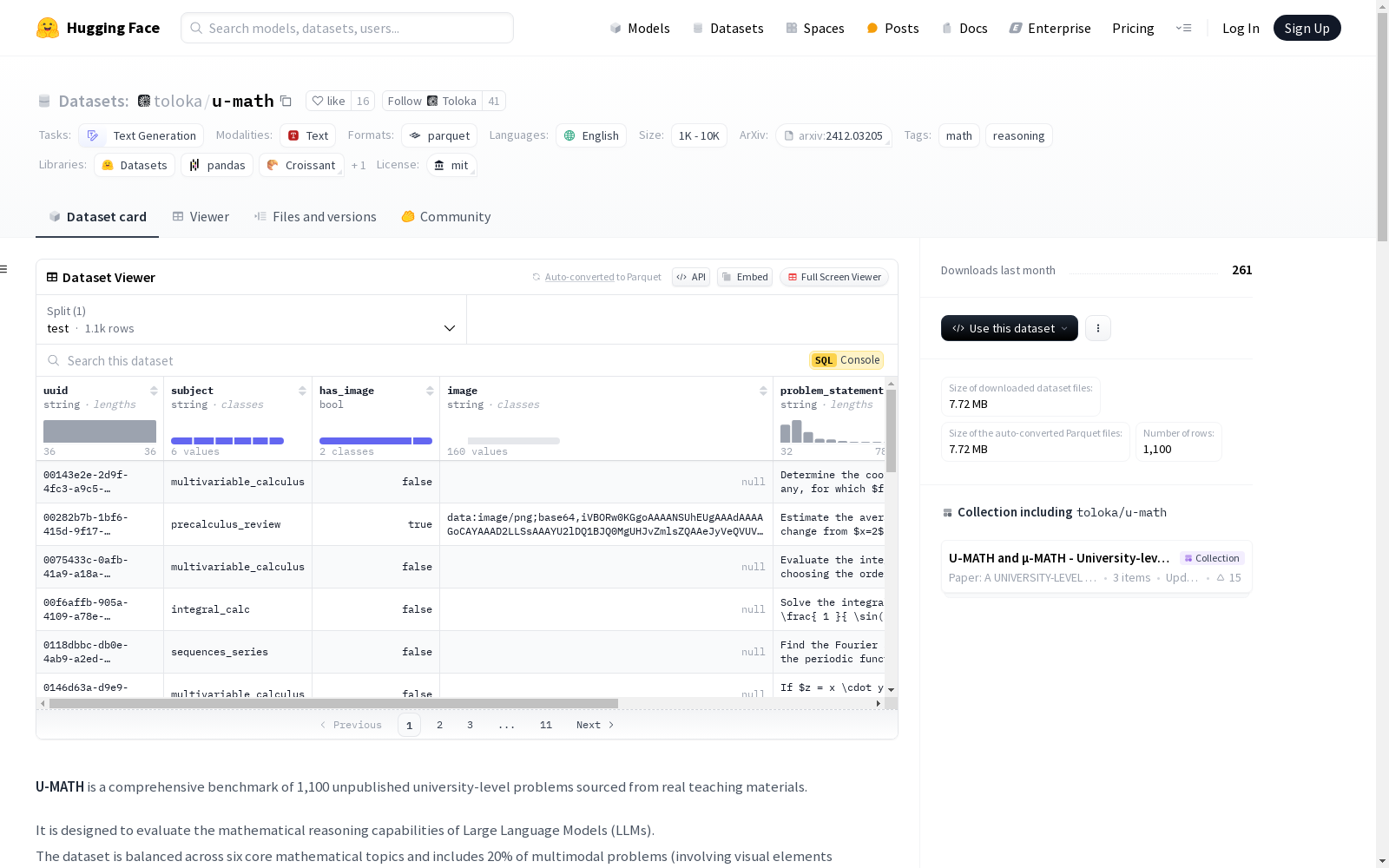

U-MATH数据集是一个包含1,100个未公开的大学水平数学问题的综合基准,来源于真实的教学材料。该数据集旨在评估大型语言模型(LLMs)的数学推理能力。数据集涵盖了六个核心数学主题,并且包括20%的多模态问题(涉及视觉元素如图形和图表)。数据集的特征包括问题ID、主题标签、是否包含图像、图像数据、问题陈述和正确答案。数据集分为测试集,包含1100个样本。数据集的内容根据MIT许可证发布。

创建时间:

2024-12-03

原始信息汇总

U-MATH 数据集概述

基本信息

- 许可证: MIT

- 名称: U-MATH

- 任务类别: 文本生成

- 语言: 英语

- 标签: 数学, 推理

- 数据规模: 1K<n<10K

数据集结构

特征

- uuid: 问题ID (字符串)

- subject: 问题所属主题 (字符串)

- has_image: 是否包含图像 (布尔值)

- image: 图像数据 (字符串)

- problem_statement: 问题陈述 (字符串)

- golden_answer: 正确答案 (字符串)

数据分割

- test: 1100个样本

数据集配置

- config_name: default

- data_files:

- split: test

- path: data/test-*

关键特性

- 涵盖主题: 预积分, 代数, 微分积分, 积分, 多变量积分, 序列与级数

- 问题格式: 自由形式答案, LLM判断

- 评估指标: 准确性; 按主题和文本与多模态问题类型划分

- 数据来源: 由数学教授原创, 用于大学课程, 由Toloka AI和Gradarius的数学专家验证

使用方法

python from datasets import load_dataset ds = load_dataset(toloka/u-math, split=test)

数据集字段

- uuid: 问题ID

- has_image: 是否为多模态问题

- image: 图像数据, 文本问题为空

- subject: 问题所属主题

- problem_statement: 问题陈述

- golden_answer: 正确答案

许可证信息

所有数据集内容均在MIT许可证下可用。

引用

bibtex @inproceedings{umath2024, title={U-MATH: A University-Level Benchmark for Evaluating Mathematical Skills in LLMs}, author={Konstantin Chernyshev, Vitaliy Polshkov, Ekaterina Artemova, Alex Myasnikov, Vlad Stepanov, Alexei Miasnikov and Sergei Tilga}, year={2024} }

联系信息

- 邮箱: kchernyshev@toloka.ai

AI搜集汇总

数据集介绍

构建方式

U-MATH数据集的构建基于1,100道未公开的大学级别数学问题,这些问题源自真实的教学材料。数据集涵盖了六个核心数学领域,包括初等数学、代数、微分学、积分学、多元微积分以及序列与级数。值得注意的是,该数据集包含了20%的多模态问题,这些问题涉及视觉元素如图形和图表。所有问题均由数学教授原创,并经过Toloka AI和Gradarius的数学专家验证,确保了数据集的高质量和学术严谨性。

使用方法

使用U-MATH数据集进行模型评估时,可以通过HuggingFace的datasets库轻松加载。具体操作如下:首先,导入datasets库并加载'toloka/u-math'数据集的测试集。数据集包含多个字段,如问题ID(uuid)、是否包含图像(has_image)、图像数据(image)、问题所属学科(subject)、问题陈述(problem_statement)以及正确答案(golden_answer)。通过这些字段,用户可以进行详细的性能评估和模型优化。

背景与挑战

背景概述

U-MATH数据集是由Toloka AI与Gradarius合作开发的一个综合性基准,旨在评估大型语言模型(LLMs)在高等数学领域的推理能力。该数据集包含了1,100道未公开的大学级别数学问题,这些问题来源于实际的教学材料,涵盖了六个核心数学主题:初等数学、代数、微分学、积分学、多元微积分以及数列与级数。U-MATH数据集的独特之处在于其20%的问题涉及多模态元素,如图形和图表,这为模型在处理视觉信息与文本结合的任务时提供了挑战。该数据集的构建得到了数学教授和专家的验证,确保了问题的质量和难度。U-MATH的发布不仅为LLMs在数学推理方面的研究提供了宝贵的资源,还为相关领域的研究者提供了一个标准化的评估工具。

当前挑战

U-MATH数据集在构建和应用过程中面临多项挑战。首先,数据集的多样性和复杂性要求模型能够处理多种数学主题和问题类型,这对模型的泛化能力提出了高要求。其次,多模态问题的引入增加了数据处理的复杂性,模型需要同时理解文本和视觉信息,这对现有的多模态处理技术构成了挑战。此外,数据集的验证过程需要数学专家的参与,确保问题的准确性和解答的正确性,这一过程耗时且成本高昂。最后,如何有效地评估模型的数学推理能力,特别是在处理复杂和多步骤问题时的表现,是该数据集应用中的一个重要挑战。

常用场景

经典使用场景

U-MATH数据集的经典使用场景主要集中在评估大型语言模型(LLMs)在高等数学领域的推理能力。该数据集包含了1100道未公开的大学级别数学问题,涵盖了预积分、代数、微积分等多个核心数学主题。通过提供自然语言描述的问题和对应的正确答案,U-MATH允许研究者对LLMs在数学推理任务中的表现进行细致的评估,尤其是在处理多模态问题(如包含图表和图像的问题)时的表现。

解决学术问题

U-MATH数据集解决了在评估LLMs数学推理能力时面临的挑战,特别是在处理复杂数学问题和多模态数据时的表现。通过提供高质量、经过专家验证的数学问题,该数据集为研究者提供了一个标准化的基准,用于比较不同模型在数学推理任务中的性能。这不仅有助于推动LLMs在数学教育领域的应用,还为开发更智能的数学辅导系统提供了理论基础。

实际应用

在实际应用中,U-MATH数据集可用于开发和优化数学教育工具,如智能辅导系统和自动评分系统。通过训练和测试LLMs在处理大学级别数学问题的能力,教育科技公司可以构建更高效的学习平台,帮助学生更好地理解和解决复杂的数学问题。此外,该数据集还可用于评估和改进现有的数学教学方法,推动教育领域的智能化进程。

数据集最近研究

最新研究方向

近年来,随着大语言模型(LLMs)在数学推理领域的应用日益广泛,U-MATH数据集作为评估大学级别数学问题解决能力的重要基准,受到了学术界的广泛关注。该数据集涵盖了六个核心数学主题,并引入了20%的多模态问题,旨在全面评估模型在处理复杂数学问题时的表现。当前的研究方向主要集中在优化LLMs在数学推理任务中的性能,特别是在多模态问题上的表现。此外,研究者们也在探索如何通过元评估(meta-evaluation)来提升模型对数学问题的判断能力,从而推动数学教育领域的智能化发展。U-MATH数据集的提出不仅为LLMs的数学推理能力提供了量化评估标准,也为未来智能教育系统的开发奠定了坚实基础。

以上内容由AI搜集并总结生成