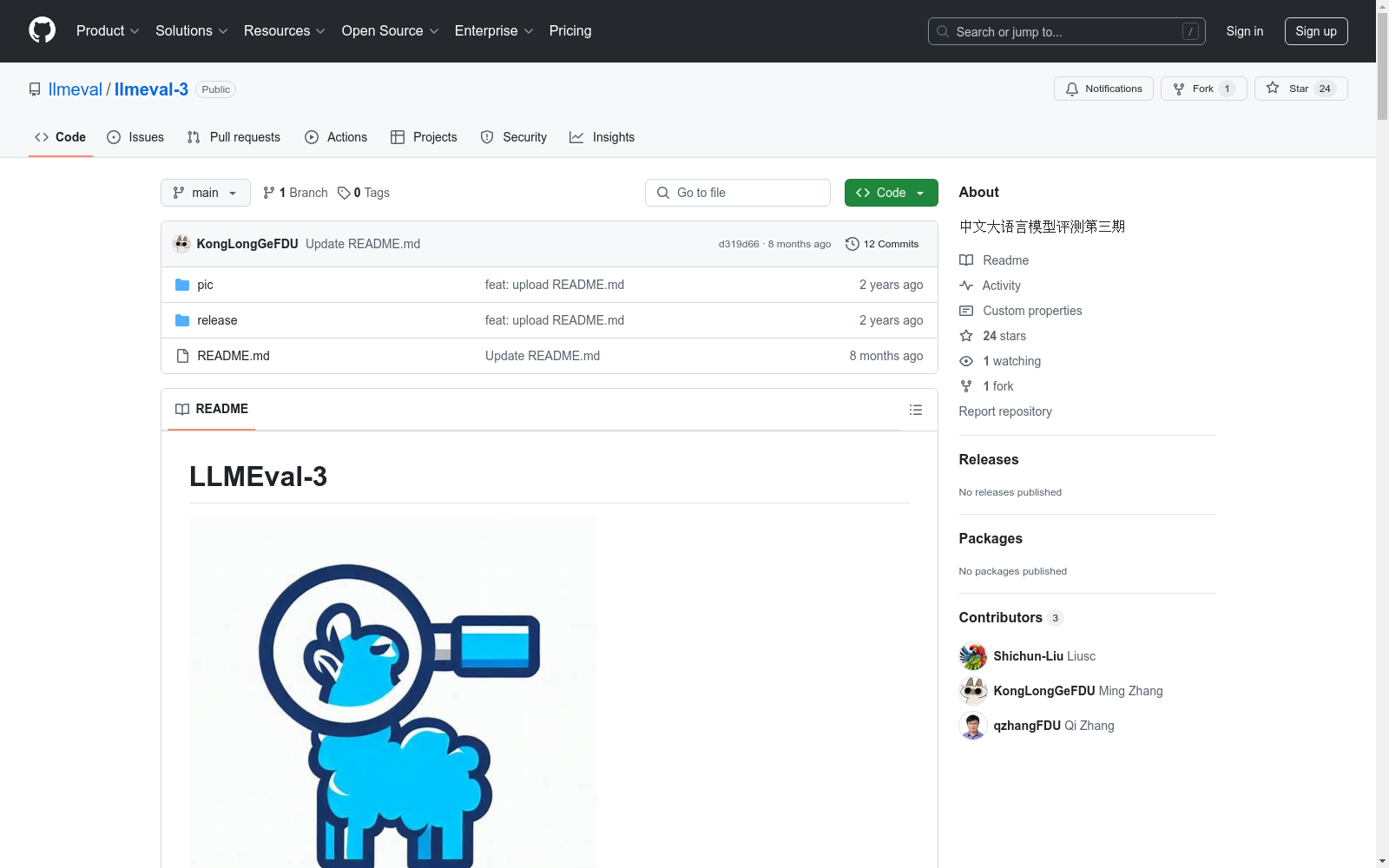

LLMEVAL-3|学术评估数据集|模型性能测试数据集

收藏LLMEval-3 数据集概述

数据集基本信息

- 名称:LLMEval-3

- 主题:专业知识能力评测

- 学科覆盖:哲学、经济学、法学、教育学、文学、历史学、理学、工学、农学、医学、军事学、管理学、艺术学等13个学科门类、50余个二级学科

- 题目数量:约20W道标准生成式问答题目(计划扩充至100W)

- 题目来源:大学本科课后作业、大学本科期中期末考试、研究生入学考试等非互联网公开渠道

- 数据格式:原始为PDF和Word文件,经过OCR识别与数据清洗后格式化处理

题目特点

- 题型:生成式知识问答,包括简答、计算、判断、辨析、写作等多种题型

- 评测形式:全流程自动化,提供标准接口

评测流程

- 题目抽样:每个参与评测的系统需完成从总题库中随机抽样的1000题

- 防作弊机制:

- 针对同一机构的模型确保每次评测题目不重复

- 在线评测,题目发送串行进行

- 评测模型:GPT4 Turbo

- 评分标准:

- 每道题得分范围:0-3分

- 评分聚焦于回答的核心正确性和解释正确性

- 评分prompt标准化

评测指标

- 绝对分数:模型在1000道题目的单题得分之和并映射到[0, 100]区间

- 相对分数:

- 相对于GPT-3.5-turbo的分位并映射到[0, 100]区间

- 相对于GPT-4的分位并映射到[0, 100]区间

评测结果(截至2024年3月10日22:00)

综合排行榜

| 模型名称 | 相对分数-GPT4 Turbo | 相对分数-GPT3.5 | 绝对分数 |

|---|---|---|---|

| GPT4 Turbo(gpt-4-1106-preview) | 100 | 141.81 | 73.6 |

| gpt-4-0125-preview | 97.28 | 137.96 | 71.6 |

| Baidu4.0 | 95.56 | 135.52 | 70.33 |

| Yi-34B-Chat | 89.27 | 126.59 | 65.70 |

| Baidu3.5 | 87.95 | 124.73 | 64.73 |

各学科分数(部分示例)

| 模型名称 | 工学 | 经济学 | 教育学 | 法学 | 文学 |

|---|---|---|---|---|---|

| GPT4 Turbo(gpt-4-1106-preview) | 6.97 | 8.17 | 8.33 | 7.8 | 6.0 |

| gpt-4-10125-preview | 6.9 | 7.4 | 8.03 | 7.3 | 6.0 |

| Baidu4.0 | 7.27 | 7.23 | 7.67 | 7.43 | 5.63 |

系统性分析

- 评测稳定性:以GPT-4作为基准模型的相对分数稳定性优于GPT-3.5-turbo

- 模型表现:大部分模型相对GPT-4分数的二次相对偏差小于5%

- 中文模型进展:国内开源模型在最近3个月有大幅度提升

联系方式

- 官网:http://llmeval.com/

- 邮箱:mingzhang23@m.fudan.edu.cn

- 微信:zanyingluan

中国裁判文书网

中国裁判文书网是中国最高人民法院设立的官方网站,旨在公开各级法院的裁判文书。该数据集包含了大量的法律文书,如判决书、裁定书、调解书等,涵盖了民事、刑事、行政、知识产权等多个法律领域。

wenshu.court.gov.cn 收录

ICESat-2 Data

ICESat-2 Data 是由美国国家航空航天局(NASA)发布的卫星数据集,主要用于全球冰层和陆地高程的测量。该数据集包括高精度激光测高数据,用于研究冰川、海冰、植被和地形变化。

icesat-2.gsfc.nasa.gov 收录

YOLO Drone Detection Dataset

为了促进无人机检测模型的开发和评估,我们引入了一个新颖且全面的数据集,专门为训练和测试无人机检测算法而设计。该数据集来源于Kaggle上的公开数据集,包含在各种环境和摄像机视角下捕获的多样化的带注释图像。数据集包括无人机实例以及其他常见对象,以实现强大的检测和分类。

github 收录

KAIST dataset

KAIST数据集,用于多光谱行人检测。

github 收录

专精特新“小巨人”合肥企业名单(第一批~第四批)

根据工信部的定义,专精特新“小巨人”企业是“专精特新”中小企业中的佼佼者,是专注于细分市场、创新能力强、市场占有率高、掌握关键核心技术、质量效益优的排头兵企业。 截止第四批,目前,全市“小巨人”企业总数达140户,占全国的1.6%,在全国城市及省会城市排名各进一位,位居全国城市第十四,省会城市第五。 2022 年 6 月,合肥市发布《专精特新中小企业倍增培育行动计划》,到2025年,合肥计划培育省级专精特新冠军企业和国家级专精特新“小巨人”企业300家,推动50家专精特新中小企业上市挂牌。接下来,合肥还将支持地方国有金融机构设立专精特新专项融资产品,力争每条产业链培育一批国家级专精特新“小巨人”企业。

合肥数据要素流通平台 收录