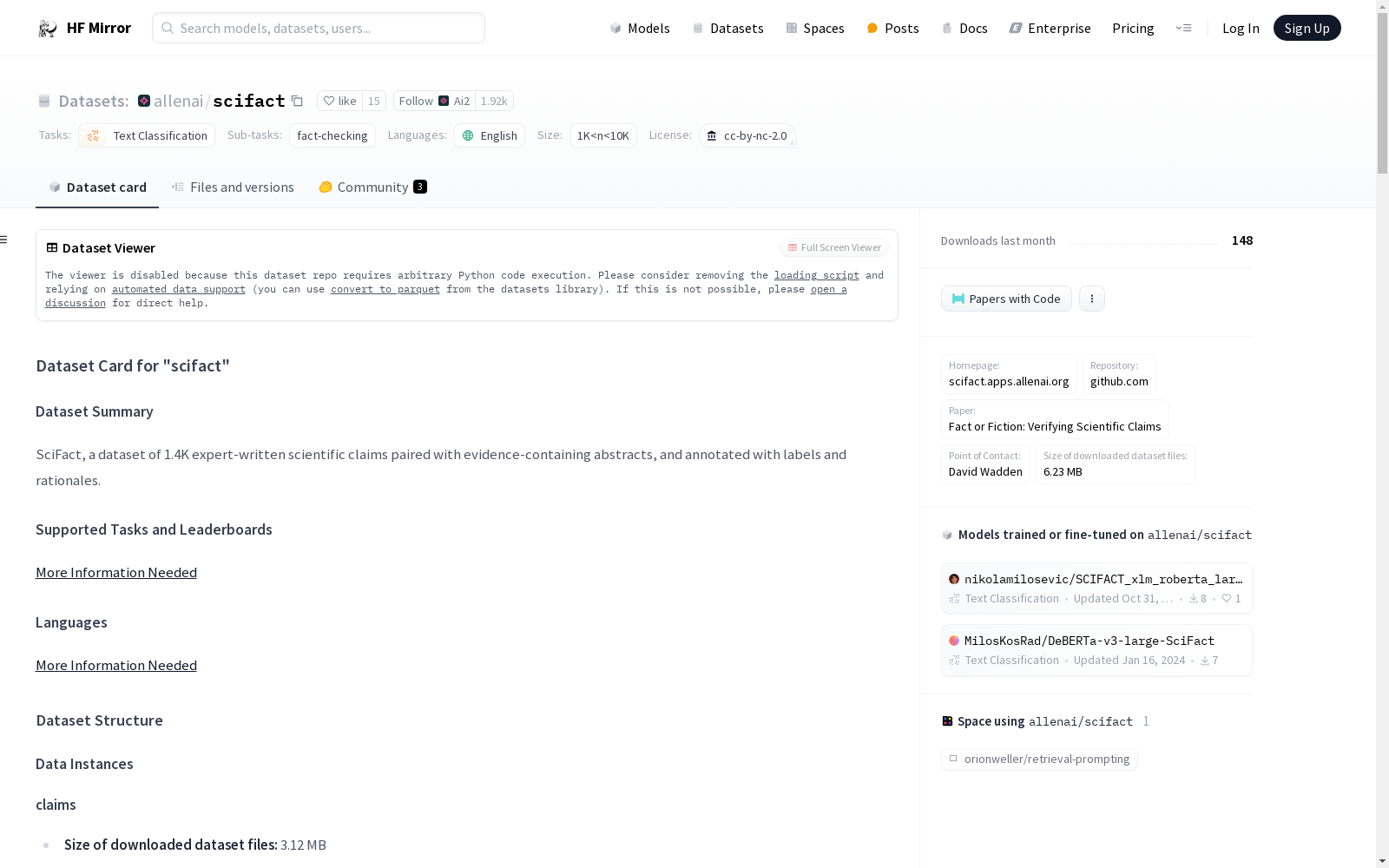

allenai/scifact|科学事实验证数据集|自然语言处理数据集

收藏数据集概述

数据集名称

- 名称: SciFact

语言

- 语言: 英语 (en)

许可证

- 许可证: CC BY-NC 2.0

多语言性

- 多语言性: 单语种

大小分类

- 大小分类: 1K<n<10K

源数据集

- 源数据集: 原始数据

任务类别

- 任务类别: 文本分类

任务ID

- 任务ID: fact-checking

论文代码ID

- 论文代码ID: scifact

数据集结构

配置名称

- 配置名称: corpus 和 claims

数据特征

corpus

- doc_id: int32

- title: string

- abstract: sequence of string

- structured: bool

claims

- id: int32

- claim: string

- evidence_doc_id: string

- evidence_label: string

- evidence_sentences: sequence of int32

- cited_doc_ids: sequence of int32

数据分割

corpus

- train: 5183 examples, 7993572 bytes

claims

- train: 1261 examples, 168627 bytes

- validation: 450 examples, 60360 bytes

- test: 300 examples, 33625 bytes

下载与数据集大小

- 下载大小: 3115079 bytes

- 数据集大小: corpus 7993572 bytes, claims 262612 bytes

数据集创建

许可证信息

- 许可证: CC BY-NC 2.0

引用信息

@inproceedings{wadden-etal-2020-fact, title = "Fact or Fiction: Verifying Scientific Claims", author = "Wadden, David and Lin, Shanchuan and Lo, Kyle and Wang, Lucy Lu and van Zuylen, Madeleine and Cohan, Arman and Hajishirzi, Hannaneh", booktitle = "Proceedings of the 2020 Conference on Empirical Methods in Natural Language Processing (EMNLP)", month = nov, year = "2020", address = "Online", publisher = "Association for Computational Linguistics", url = "https://aclanthology.org/2020.emnlp-main.609", doi = "10.18653/v1/2020.emnlp-main.609", pages = "7534--7550", }

中国1km分辨率逐月降水量数据集(1901-2024)

该数据集为中国逐月降水量数据,空间分辨率为0.0083333°(约1km),时间为1901.1-2024.12。数据格式为NETCDF,即.nc格式。该数据集是根据CRU发布的全球0.5°气候数据集以及WorldClim发布的全球高分辨率气候数据集,通过Delta空间降尺度方案在中国降尺度生成的。并且,使用496个独立气象观测点数据进行验证,验证结果可信。本数据集包含的地理空间范围是全国主要陆地(包含港澳台地区),不含南海岛礁等区域。为了便于存储,数据均为int16型存于nc文件中,降水单位为0.1mm。 nc数据可使用ArcMAP软件打开制图; 并可用Matlab软件进行提取处理,Matlab发布了读入与存储nc文件的函数,读取函数为ncread,切换到nc文件存储文件夹,语句表达为:ncread (‘XXX.nc’,‘var’, [i j t],[leni lenj lent]),其中XXX.nc为文件名,为字符串需要’’;var是从XXX.nc中读取的变量名,为字符串需要’’;i、j、t分别为读取数据的起始行、列、时间,leni、lenj、lent i分别为在行、列、时间维度上读取的长度。这样,研究区内任何地区、任何时间段均可用此函数读取。Matlab的help里面有很多关于nc数据的命令,可查看。数据坐标系统建议使用WGS84。

国家青藏高原科学数据中心 收录

中国近海台风路径集合数据集(1945-2024)

1945-2024年度,中国近海台风路径数据集,包含每个台风的真实路径信息、台风强度、气压、中心风速、移动速度、移动方向。 数据源为获取温州台风网(http://www.wztf121.com/)的真实观测路径数据,经过处理整合后形成文件,如使用csv文件需使用文本编辑器打开浏览,否则会出现乱码,如要使用excel查看数据,请使用xlsx的格式。

国家海洋科学数据中心 收录

WideIRSTD Dataset

WideIRSTD数据集包含七个公开数据集:SIRST-V2、IRSTD-1K、IRDST、NUDT-SIRST、NUDT-SIRST-Sea、NUDT-MIRSDT、Anti-UAV,以及由国防科技大学团队开发的数据集,包括模拟陆基和太空基数据,以及真实手动标注的太空基数据。数据集包含具有各种目标形状(如点目标、斑点目标、扩展目标)、波长(如近红外、短波红外和热红外)、图像分辨率(如256、512、1024、3200等)的图像,以及不同的成像系统(如陆基、空基和太空基成像系统)。

github 收录

UCF-Crime

UCF-犯罪数据集是128小时视频的新型大规模第一个数据集。它包含1900年长而未修剪的真实世界监控视频,其中包含13个现实异常,包括虐待,逮捕,纵火,殴打,道路交通事故,入室盗窃,爆炸,战斗,抢劫,射击,偷窃,入店行窃和故意破坏。之所以选择这些异常,是因为它们对公共安全有重大影响。这个数据集可以用于两个任务。首先,考虑一组中的所有异常和另一组中的所有正常活动的一般异常检测。第二,用于识别13个异常活动中的每一个。

OpenDataLab 收录

Chinese Tea Sprout Dataset

On the basis of autonomous mobile tea picking robot, aiming at the shortcomings of traditional tea bud identification methods such as slow speed, low accuracy and poor adaptability, as well as people's demand for high-quality tea, the research and experiment of tea bud quality classification recognition based on YOLOv5 were carried out. Through the construction of the autonomous mobile tea picking robot visual recognition system, the data set was constructed, which mainly included tea image acquisition, enhancement and annotation. YOLOv5 and SSD target detection algorithms were used to conduct model training experiments, and the experimental data was analyzed. The experimental results show that the average accuracy of YOLOv5 target detection algorithm is high.The analysis of experimental data shows that the YOLOv5 target detection algorithm has a good effect on classification identification of tea buds, which can provide technical support and theoretical guidance for classification identification of tea buds and intelligent picking.

Mendeley Data 收录