VeRi|车辆重识别数据集|图像识别数据集

收藏数据集概述

数据集名称

VeRi 数据集

数据集内容

- 包含超过50,000张车辆图像

- 涉及776辆车辆

- 由20个摄像头在24小时内拍摄

- 覆盖面积为1.0平方公里

数据集用途

主要用于车辆再识别(Vehicle Re-identification)及相关研究。

数据集获取

如需使用此数据集,请联系VeRi数据集的作者。

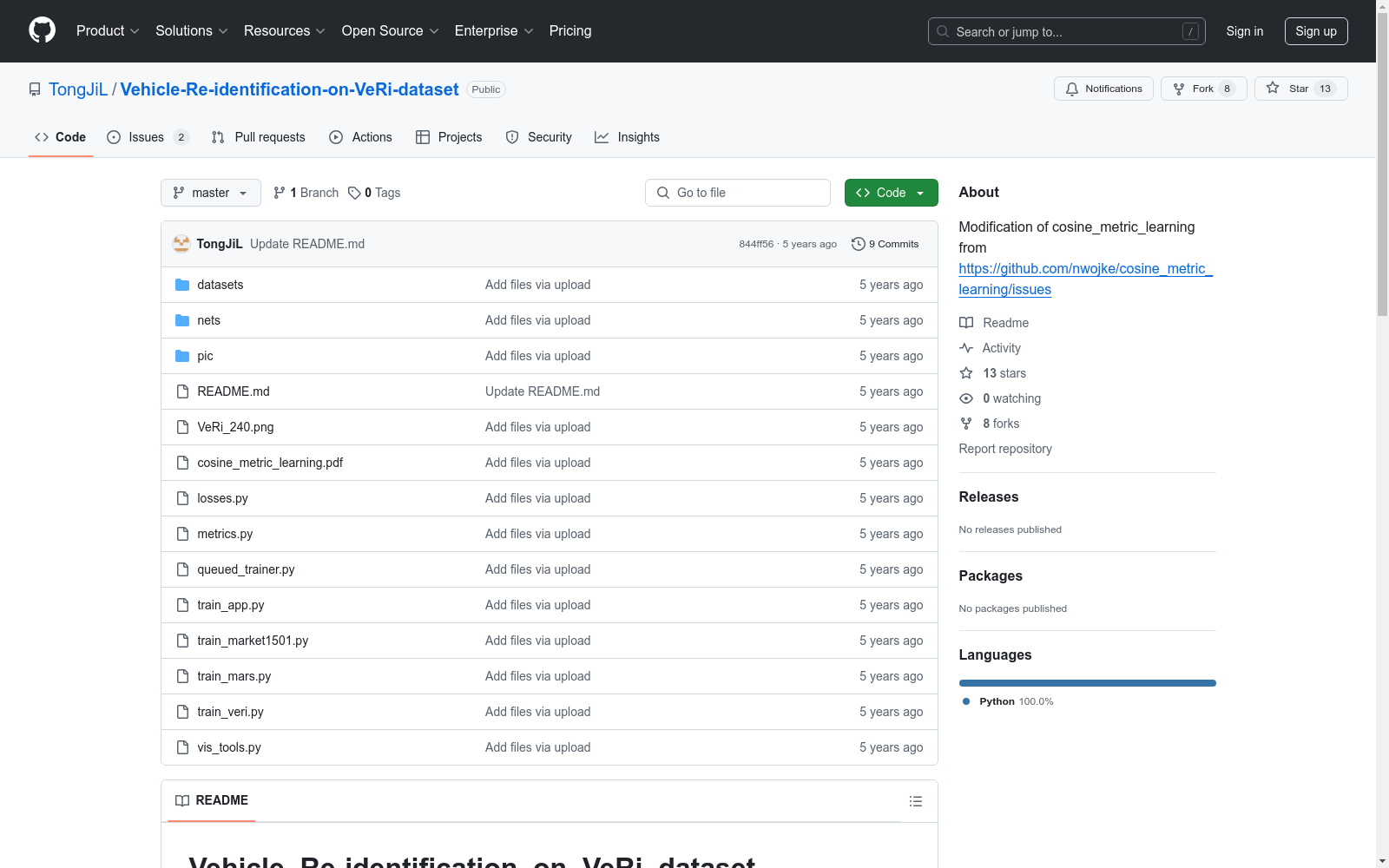

数据集训练

-

训练代码为

train_veri.py -

数据集预处理代码位于

datasets/veri.py -

训练命令示例: python train_veri.py --dataset_dir=./VeRi/ --loss_mode=cosine-softmax --log_dir=./output/veri/ --run_id=cosine-softmax

-

训练结果可通过TensorBoard监控: tensorboard --logdir ./output/veri/cosine-softmax --port 6006

模型导出

用于deep_sort tracker的模型导出命令:

python train_veri.py --mode=freeze --restore_path=PATH_TO_CHECKPOINT

中国区域地面气象要素驱动数据集 v2.0(1951-2024)

中国区域地面气象要素驱动数据集(China Meteorological Forcing Data,以下简称 CMFD)是为支撑中国区域陆面、水文、生态等领域研究而研发的一套高精度、高分辨率、长时间序列数据产品。本页面发布的 CMFD 2.0 包含了近地面气温、气压、比湿、全风速、向下短波辐射通量、向下长波辐射通量、降水率等气象要素,时间分辨率为 3 小时,水平空间分辨率为 0.1°,时间长度为 74 年(1951~2024 年),覆盖了 70°E~140°E,15°N~55°N 空间范围内的陆地区域。CMFD 2.0 融合了欧洲中期天气预报中心 ERA5 再分析数据与气象台站观测数据,并在辐射、降水数据产品中集成了采用人工智能技术制作的 ISCCP-ITP-CNN 和 TPHiPr 数据产品,其数据精度较 CMFD 的上一代产品有显著提升。 CMFD 历经十余年的发展,其间发布了多个重要版本。2019 年发布的 CMFD 1.6 是完全采用传统数据融合技术制作的最后一个 CMFD 版本,而本次发布的 CMFD 2.0 则是 CMFD 转向人工智能技术制作的首个版本。此版本与 1.6 版具有相同的时空分辨率和基础变量集,但在其它诸多方面存在大幅改进。除集成了采用人工智能技术制作的辐射和降水数据外,在制作 CMFD 2.0 的过程中,研发团队尽可能采用单一来源的再分析数据作为输入并引入气象台站迁址信息,显著缓解了 CMFD 1.6 中因多源数据拼接和气象台站迁址而产生的虚假气候突变。同时,CMFD 2.0 数据的时间长度从 CMFD 1.6 的 40 年大幅扩展到了 74 年,并将继续向后延伸。CMFD 2.0 的网格空间范围虽然与 CMFD 1.6 相同,但其有效数据扩展到了中国之外,能够更好地支持跨境区域研究。为方便用户使用,CMFD 2.0 还在基础变量集之外提供了若干衍生变量,包括近地面相对湿度、雨雪分离降水产品等。此外,CMFD 2.0 摒弃了 CMFD 1.6 中通过 scale_factor 和 add_offset 参数将实型数据化为整型数据的压缩技术,转而直接将实型数据压缩存储于 NetCDF4 格式文件中,从而消除了用户使用数据时进行解压换算的困扰。 本数据集原定版本号为 1.7,但鉴于本数据集从输入数据到研制技术都较上一代数据产品有了大幅的改变,故将其版本号重新定义为 2.0。CMFD 2.0 的数据内容与此前宣传的 CMFD 1.7 基本一致,仅对 1983 年 7 月以后的向下短/长波辐射通量数据进行了更新,以修正其长期趋势存在的问题。

国家青藏高原科学数据中心 收录

中国1km分辨率逐月降水量数据集(1901-2024)

该数据集为中国逐月降水量数据,空间分辨率为0.0083333°(约1km),时间为1901.1-2024.12。数据格式为NETCDF,即.nc格式。该数据集是根据CRU发布的全球0.5°气候数据集以及WorldClim发布的全球高分辨率气候数据集,通过Delta空间降尺度方案在中国降尺度生成的。并且,使用496个独立气象观测点数据进行验证,验证结果可信。本数据集包含的地理空间范围是全国主要陆地(包含港澳台地区),不含南海岛礁等区域。为了便于存储,数据均为int16型存于nc文件中,降水单位为0.1mm。 nc数据可使用ArcMAP软件打开制图; 并可用Matlab软件进行提取处理,Matlab发布了读入与存储nc文件的函数,读取函数为ncread,切换到nc文件存储文件夹,语句表达为:ncread (‘XXX.nc’,‘var’, [i j t],[leni lenj lent]),其中XXX.nc为文件名,为字符串需要’’;var是从XXX.nc中读取的变量名,为字符串需要’’;i、j、t分别为读取数据的起始行、列、时间,leni、lenj、lent i分别为在行、列、时间维度上读取的长度。这样,研究区内任何地区、任何时间段均可用此函数读取。Matlab的help里面有很多关于nc数据的命令,可查看。数据坐标系统建议使用WGS84。

国家青藏高原科学数据中心 收录

中国近海地形数据集(渤海,黄海,东海,南海)

本数据集包含历年来通过收集和实测方法取得的中国近海水深点数据、地形图数据(ArcGIS格式),以及黄河口、莱州湾东部、辽东湾、山东南部沿海、南海部分海域的单波束、多波束水深测量数据,包括大尺度的低密度水深数据与局部高密度水深数据。

地球大数据科学工程 收录

TongueDx Dataset

TongueDx数据集是一个专为远程舌诊研究设计的综合性舌象图像数据集,由香港理工大学和新加坡管理大学的研究团队创建。该数据集包含5109张图像,涵盖了多种环境条件下的舌象,图像通过智能手机和笔记本电脑摄像头采集,具有较高的多样性和代表性。数据集不仅包含舌象图像,还提供了详细的舌面属性标注,如舌色、舌苔厚度等,并附有受试者的年龄、性别等人口统计信息。数据集的创建过程包括图像采集、舌象分割、标准化处理和多标签标注,旨在解决远程医疗中舌诊图像质量不一致的问题。该数据集的应用领域主要集中在远程医疗和中医诊断,旨在通过自动化技术提高舌诊的准确性和可靠性。

arXiv 收录

MedDialog

MedDialog数据集(中文)包含了医生和患者之间的对话(中文)。它有110万个对话和400万个话语。数据还在不断增长,会有更多的对话加入。原始对话来自好大夫网。

github 收录