youtube-1M-dataset, youtube-2M-dataset, youtube-15M-dataset|视频内容分析数据集|跨模态检索数据集

收藏github2024-12-20 更新2024-12-21 收录

下载链接:

https://github.com/SeahorseDB/dataset

下载链接

链接失效反馈资源简介:

包含CLIP生成的嵌入和1M、2M、15M YouTube视频场景的元数据。这些数据集存储在Parquet格式中,便于高效存储和处理。

创建时间:

2024-12-11

原始信息汇总

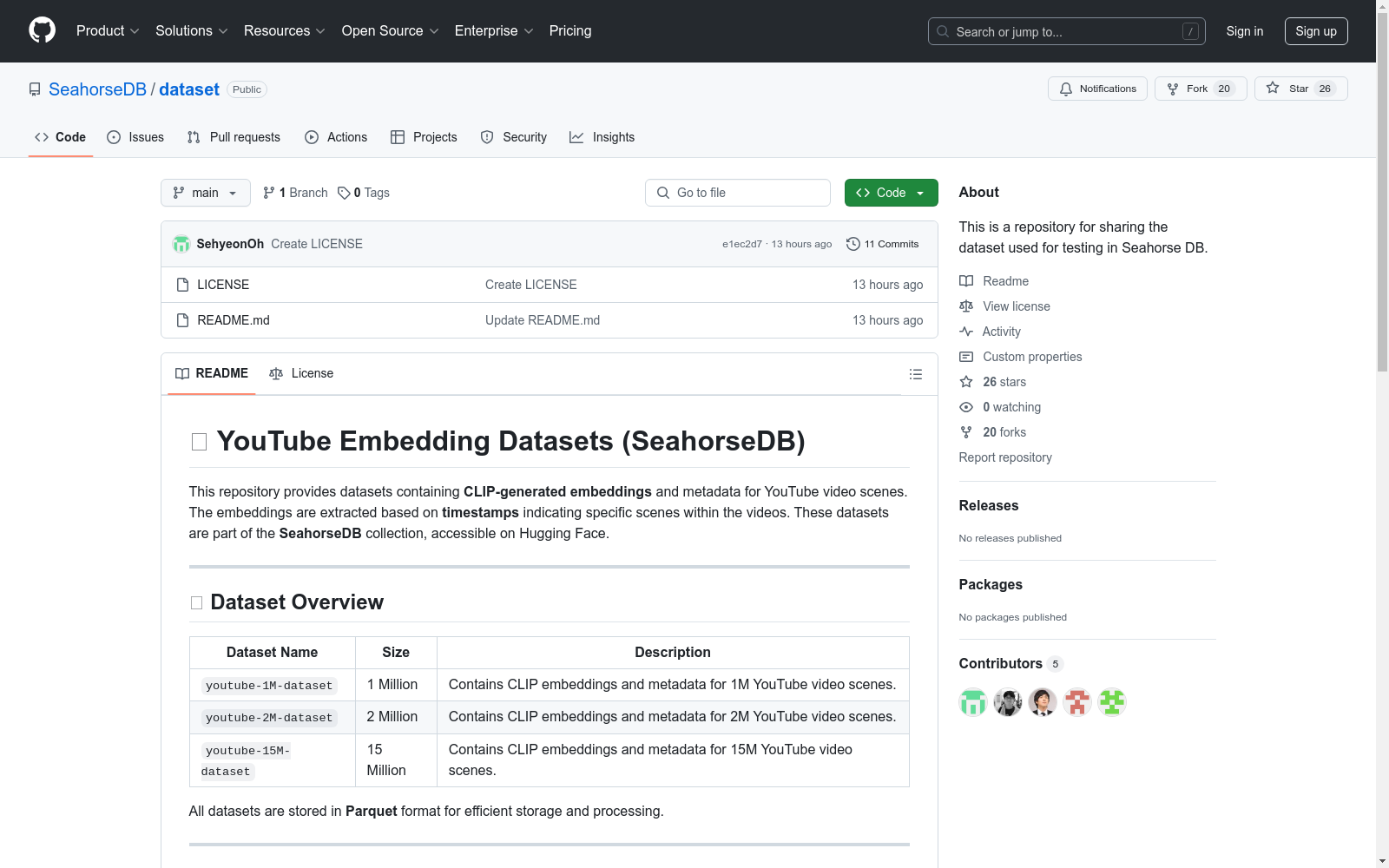

YouTube Embedding Datasets (SeahorseDB)

数据集概述

该数据集包含基于YouTube视频场景生成的CLIP嵌入和元数据。嵌入是根据视频中的时间戳提取的,表示特定场景。数据集属于SeahorseDB集合,可在Hugging Face上访问。

| 数据集名称 | 大小 | 描述 |

|---|---|---|

youtube-1M-dataset |

1百万 | 包含1百万YouTube视频场景的CLIP嵌入和元数据。 |

youtube-2M-dataset |

2百万 | 包含2百万YouTube视频场景的CLIP嵌入和元数据。 |

youtube-15M-dataset |

15百万 | 包含15百万YouTube视频场景的CLIP嵌入和元数据。 |

所有数据集均以Parquet格式存储,以便高效存储和处理。

数据集结构

每个数据集包含以下字段:

| 字段名称 | 数据类型 | 描述 |

|---|---|---|

feature |

sequence | 表示场景的1024维CLIP生成嵌入向量。 |

title |

string | YouTube视频的标题。 |

channel_name |

string | 托管视频的YouTube频道名称。 |

video_id |

string | YouTube视频的唯一标识符。 |

timestamp |

string | 指示视频中特定场景的时间戳。 |

id |

int64 | 每行的唯一标识符。 |

__index_level_0__ |

int64 | 虚拟字段。 |

访问方式

数据集可以直接从Hugging Face下载:

可以使用Pandas或PyArrow等库加载Parquet文件。

Python示例:

python import pandas as pd

加载1M数据集

df = pd.read_parquet("path/to/youtube-1M-dataset.parquet") print(df.head())

访问嵌入和元数据

embeddings = df[feature].tolist() # 1024维嵌入向量 timestamps = df[timestamp].tolist() metadata = df[title].tolist()

AI搜集汇总

数据集介绍

构建方式

该数据集通过提取YouTube视频中的特定场景,利用CLIP模型生成1024维的嵌入向量,并结合视频的元数据构建而成。每个场景的嵌入向量基于视频的时间戳进行标注,确保了数据的时间序列特性。数据集以Parquet格式存储,便于高效的数据存储和处理。

特点

该数据集的显著特点在于其大规模的场景嵌入数据,涵盖了从1百万到15百万不等的视频场景。每个场景的嵌入向量具有1024维的高维度特征,能够捕捉到视频内容的丰富语义信息。此外,数据集包含了视频的标题、频道名称、视频ID等元数据,为多维度的分析提供了可能。

使用方法

用户可以通过Hugging Face平台直接下载该数据集,并使用Pandas或PyArrow等库加载Parquet格式的数据文件。在Python环境中,用户可以轻松访问嵌入向量、时间戳以及视频的元数据,进行进一步的分析和应用,如视频内容推荐、场景分类等。

背景与挑战

背景概述

在视频内容分析与理解领域,YouTube Embedding Datasets(SeahorseDB)的推出标志着大规模视频场景嵌入技术的显著进步。该数据集由SeahorseDB团队创建,主要研究人员包括Sehyeon Oh、Donggyu Park等,旨在通过CLIP模型生成的高维嵌入向量,捕捉YouTube视频中特定场景的语义信息。这些数据集涵盖了从1百万到15百万不等的视频场景,为视频内容分析、推荐系统以及多模态学习等领域提供了宝贵的资源。其核心研究问题在于如何高效地提取和利用视频场景的嵌入信息,以推动视频内容的智能化处理与应用。

当前挑战

尽管YouTube Embedding Datasets在视频内容分析领域具有重要意义,但其构建与应用过程中仍面临诸多挑战。首先,数据集的规模庞大,处理15百万级别的视频场景嵌入需要高效的存储与计算资源,这对硬件基础设施提出了高要求。其次,CLIP模型生成的1024维嵌入向量在实际应用中可能面临维度灾难问题,如何有效降维并保持语义信息是一大挑战。此外,视频场景的多样性与复杂性使得嵌入的准确性与泛化能力成为关键问题,尤其是在跨领域应用中,如何确保嵌入的鲁棒性与一致性仍需进一步研究。

常用场景

经典使用场景

在视频内容分析与理解领域,YouTube Embedding Datasets(SeahorseDB)凭借其丰富的CLIP生成嵌入向量和元数据,成为研究视频场景识别与分类的经典工具。研究者可利用这些数据集对视频中的特定场景进行特征提取,进而实现视频内容的自动标注、分类与检索。通过分析嵌入向量,研究者能够深入探索视频内容的语义结构,为视频推荐系统、内容过滤及多媒体检索等应用提供强有力的支持。

衍生相关工作

基于YouTube Embedding Datasets,研究者们开展了多项经典工作,推动了视频内容分析领域的发展。例如,有研究利用该数据集进行视频场景的语义分割与分类,提升了视频内容理解的精度。此外,还有工作探索了如何将这些嵌入向量应用于跨模态检索,实现了文本与视频内容的高效匹配。这些衍生工作不仅丰富了视频内容分析的研究方法,还为实际应用提供了新的技术支持。

数据集最近研究

最新研究方向

在视频内容理解和语义分析领域,YouTube Embedding Datasets(SeahorseDB)凭借其大规模的CLIP生成嵌入数据,成为前沿研究的重要资源。这些数据集不仅提供了丰富的视频场景嵌入,还结合了详细的元数据,如视频标题、频道名称和时间戳,为视频内容的深度分析和检索提供了坚实基础。当前的研究主要集中在利用这些嵌入进行视频内容的语义搜索、跨模态检索以及视频推荐系统的优化。此外,随着多模态学习技术的进步,这些数据集在视频与文本、图像等多模态数据的融合研究中也展现出巨大潜力,推动了视频理解技术在智能推荐、内容审核等领域的应用深化。

以上内容由AI搜集并总结生成