MMDL: Multimodal Dataset of Daily Life, MMQADL: Multimodal Question Answering Dataset of Daily Life|具身AI数据集|多模态数据集数据集

收藏数据集概述

数据集简介

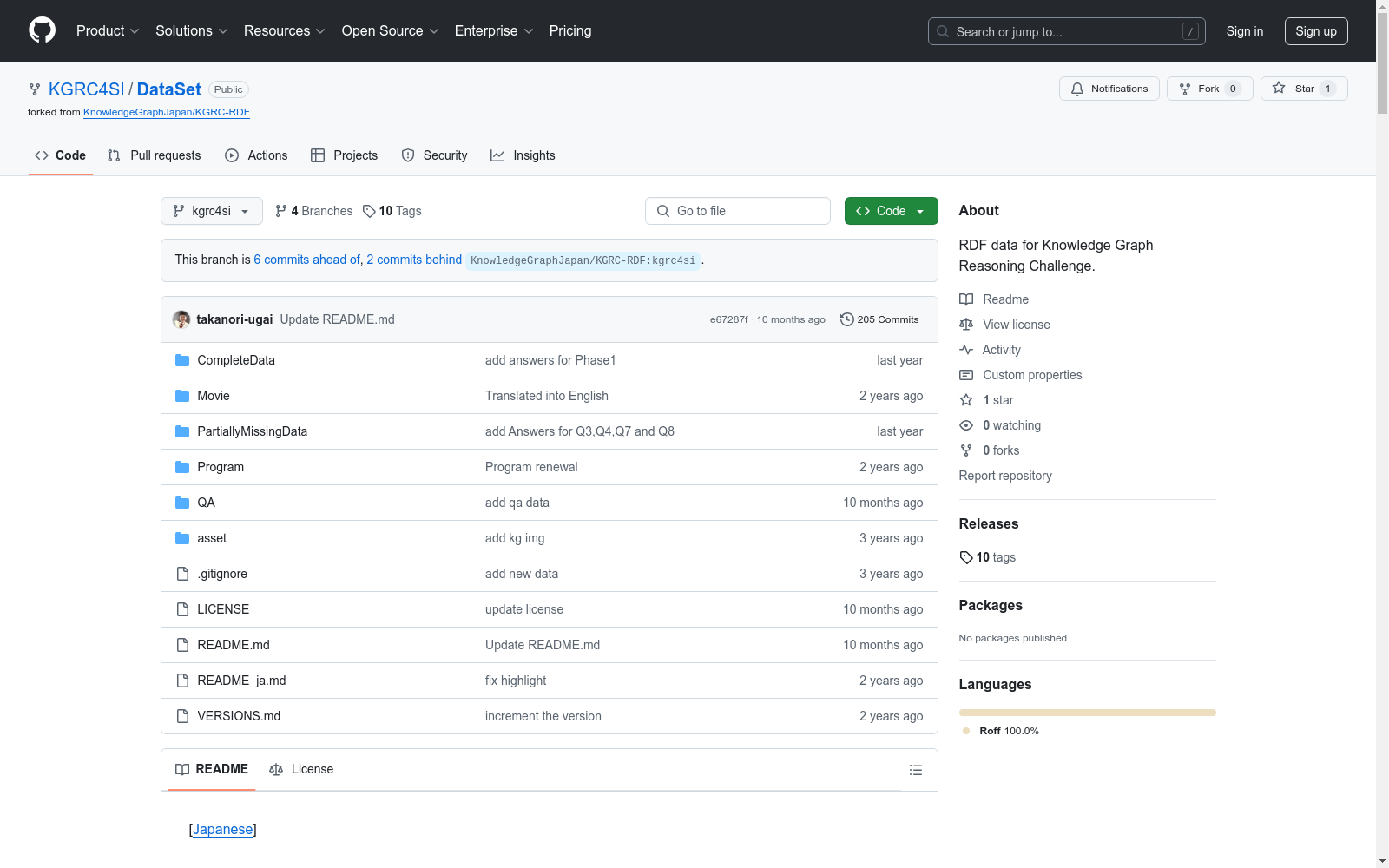

- 名称:Dataset for Knowledge Graph Reasoning Challenge for Social Issue

- 描述:该数据集包含在VirtualHome中模拟的各种日常行为视频数据,并将其转换为知识图谱,提供关于“谁”执行了“动作”,涉及了“什么”对象,以及对象的“状态”或“位置”的信息。

数据集组成

-

视频数据:

- 格式:mp4

- 数量:706个动作场景,共3560个视频

- 类型:角色后视图、室内摄像头切换视图、固定摄像头视图

- 特点:视频中缓慢移动的角色模拟老年人动作

-

场景图谱:

- 格式:Action Genome

-

知识图谱:

- 格式:RDF

- 数量:709个知识图谱,包含模式和位置补充信息

- 可用性:SPARQL端点和查询示例

-

脚本数据:

- 格式:txt

- 用途:用于生成视频和知识图谱

-

问答数据:

- 格式:JSON

- 基于20%部分缺失数据

知识图谱解释

-

本体规范:详细描述了所有类、实例和属性,参考文档:vh2kg_ontology.html

-

模式图:模式图

-

前缀:

::http://kgrc4si.home.kg/virtualhome2kg/ontology/ho::http://www.owl-ontologies.com/VirtualHome.owl#time::http://www.w3.org/2006/time#x3do:https://www.web3d.org/specifications/X3dOntology4.0#

-

代表性类:

ho:Activity: 家庭日常活动:Event: 构成活动的较小事件:Action: 在事件中执行的人类动作:Object: 家庭中的各种对象:Situation: 特定时刻的家庭状态:State: 特定对象在特定时刻的状态:StateType: 对象状态的类型:Attribute: 对象的属性:Shape: 对象的形状和位置time:Duration: 动作的持续时间

-

代表性属性:

:activity: 关联角色和活动:action: 关联事件和动作:eventNumber: 事件的顺序:situationBeforeEvent: 事件前的家庭状态:situationAfterEvent: 事件后的家庭状态:mainObject: 事件的主要对象:targetObject: 事件的目标对象time:hasDuration: 事件的持续时间:isStateOf: 关联对象和其状态:state: 关联状态和其值:affords: 关联对象和动作:attribute: 关联对象和属性:partOf: 关联状态和瞬间情况:bbox: 关联状态和形状:nextActivity: 关联两个活动:nextEvent: 关联两个事件:nextSituation: 关联两个情况:nextState: 关联对象的两个状态:between: 关联门和房间:close: 关联近距离对象:facing: 关联可见对象:holds_lh: 关联左手的对象:holds_rh: 关联右手的对象:inside: 关联内部对象:on: 关联上方对象

如何使用知识图谱

- 格式:RDF

- 存储:三元存储

- 查询语言:SPARQL

- 端点:SPARQL端点

- 镜像:Kozaki实验室镜像

示例查询

-

获取活动列表: sparql PREFIX ex: http://kgrc4si.home.kg/virtualhome2kg/instance/ PREFIX : http://kgrc4si.home.kg/virtualhome2kg/ontology/ select DISTINCT * where { ?activity :virtualHome ex:scene1 . }

-

获取“清洁厨房”活动中的事件和动作: sparql PREFIX ex: http://kgrc4si.home.kg/virtualhome2kg/instance/ PREFIX : http://kgrc4si.home.kg/virtualhome2kg/ontology/ select DISTINCT * where { ex:clean_kitchen1_scene1 :hasEvent ?event . ?event :action ?action . }

-

获取交互对象类型列表: sparql PREFIX : http://kgrc4si.home.kg/virtualhome2kg/ontology/ select distinct ?objectType where { ?event (:mainObject|:targetObject) ?object . ?object a ?objectType . }

-

获取频繁抓取的对象: sparql PREFIX ho: http://www.owl-ontologies.com/VirtualHome.owl# PREFIX rdfs: http://www.w3.org/2000/01/rdf-schema# PREFIX : http://kgrc4si.home.kg/virtualhome2kg/ontology/ PREFIX dcterms: http://purl.org/dc/terms/ PREFIX ac: http://kgrc4si.home.kg/virtualhome2kg/ontology/action/ select ?name (count(?object) AS ?count) where { ?objectClass rdfs:subClassOf/rdfs:subClassOf :Object . ?object a ?objectClass ; rdfs:label ?label ; dcterms:identifier ?id . ?event (:mainObject|:targetObject) ?object . ?event :action ac:grab . BIND(concat(?label, ?id) AS ?name) } group by ?object ?name order by desc(count(?object))

-

添加对象高度信息: sparql PREFIX x3do: https://www.web3d.org/specifications/X3dOntology4.0# PREFIX rdf: http://www.w3.org/1999/02/22-rdf-syntax-ns# PREFIX : http://kgrc4si.home.kg/virtualhome2kg/ontology/ PREFIX ex: http://kgrc4si.home.kg/virtualhome2kg/instance/ CONSTRUCT { ?object :height ?height_node . ?height_node rdf:value ?size_y1 ; :unit :meter . } WHERE { ?state1 :isStateOf ?object ; :bbox ?shape1 . ?shape1 x3do:bboxSize ?size1 . ?size1 rdf:rest ?size_y . ?size_y rdf:first ?size_y1 . BIND(REPLACE(STR(?object), STR(ex:) ,"") AS ?object_name) BIND(URI(CONCAT(STR(ex:),"height_", ?object_name)) AS ?height_node) }

-

获取对象的affordance信息: sparql

请开启推理引擎

PREFIX : http://kgrc4si.home.kg/virtualhome2kg/ontology/ select * where { ?object a :Object . ?object :affords ?ac

- 1Multimodal Datasets and Benchmarks for Reasoning about Dynamic Spatio-Temporality in Everyday Environments日本国立先进工业科学技术研究所 · 2024年

URPC系列数据集, S-URPC2019, UDD

URPC系列数据集包括URPC2017至URPC2020DL,主要用于水下目标的检测和分类。S-URPC2019专注于水下环境的特定检测任务。UDD数据集信息未在README中详细描述。

github 收录

AIS数据集

该研究使用了多个公开的AIS数据集,这些数据集经过过滤、清理和统计分析。数据集涵盖了多种类型的船舶,并提供了关于船舶位置、速度和航向的关键信息。数据集包括来自19,185艘船舶的AIS消息,总计约6.4亿条记录。

github 收录

DFT dataset for high entropy alloys

我们的DFT数据集涵盖了由八种元素组成的bcc和fcc结构,包括所有可能的2至7元合金系统。该数据集在Zenodo上公开可用,包含初始和最终结构、形成能量、原子磁矩和电荷等属性。

github 收录

HazyDet

HazyDet是由解放军工程大学等机构创建的一个大规模数据集,专门用于雾霾场景下的无人机视角物体检测。该数据集包含383,000个真实世界实例,收集自自然雾霾环境和正常场景中人工添加的雾霾效果,以模拟恶劣天气条件。数据集的创建过程结合了深度估计和大气散射模型,确保了数据的真实性和多样性。HazyDet主要应用于无人机在恶劣天气条件下的物体检测,旨在提高无人机在复杂环境中的感知能力。

arXiv 收录

ERIC (Education Resources Information Center)

ERIC (Education Resources Information Center) 是一个广泛的教育文献数据库,包含超过130万条记录,涵盖从1966年至今的教育研究、政策和实践。数据集内容包括教育相关的期刊文章、书籍、研究报告、会议论文、技术报告、政策文件等。

eric.ed.gov 收录