维基百科中文语料|自然语言处理数据集|文本挖掘数据集

收藏github2024-09-11 更新2024-09-12 收录

下载链接:

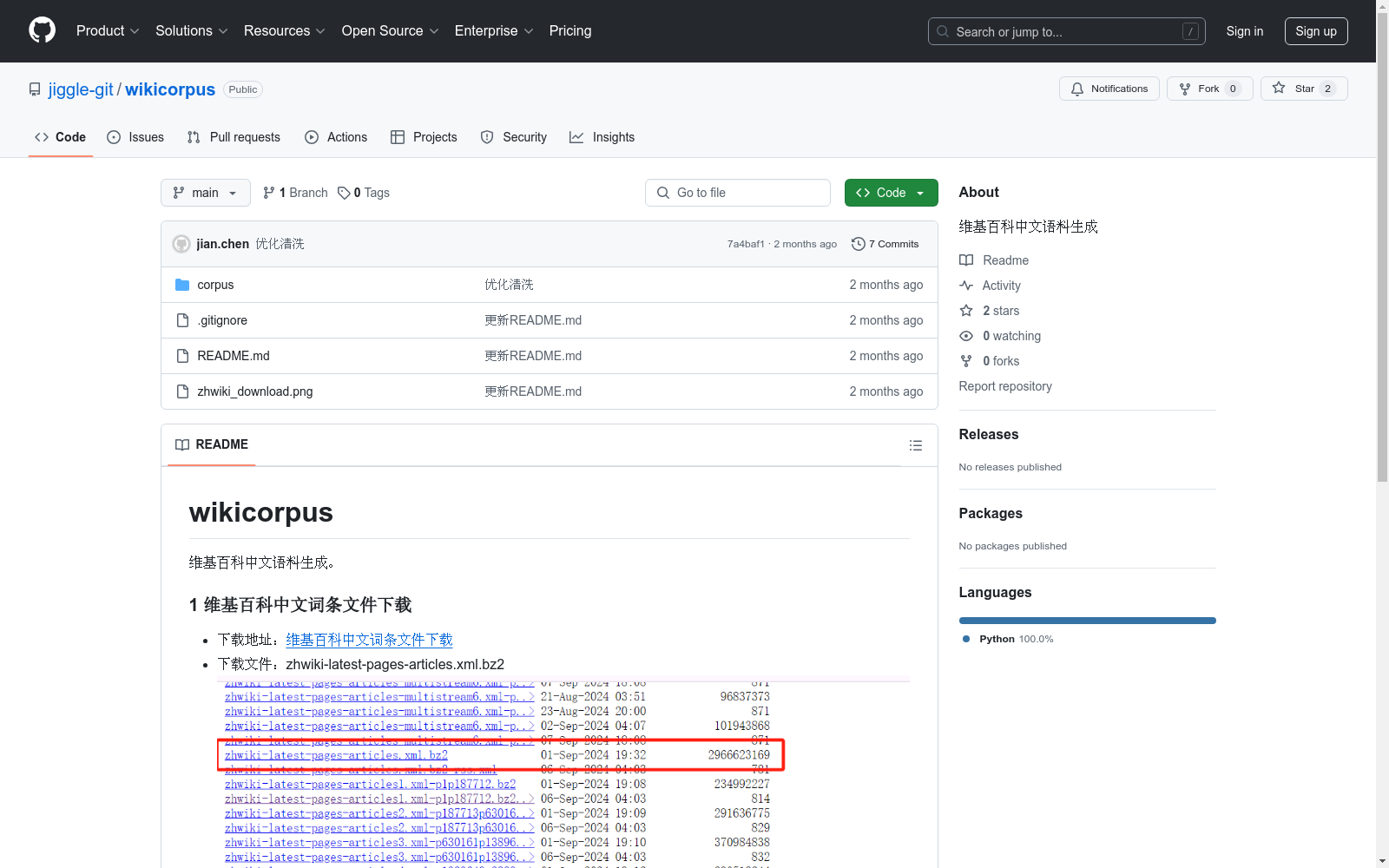

https://github.com/jiggle-git/wikicorpus

下载链接

链接失效反馈资源简介:

该数据集包含从维基百科下载的中文词条文件,经过解析、清洗和处理后生成的语料文件。每个语料数据包含词条ID、词条标题和词条内容。

创建时间:

2024-09-11

原始信息汇总

wikicorpus

数据集概述

wikicorpus 是一个用于生成维基百科中文语料的数据集。

数据集内容

1 维基百科中文词条文件下载

- 下载地址:维基百科中文词条文件下载

- 下载文件:zhwiki-latest-pages-articles.xml.bz2

2 维基百科中文语料生成

2.1 提取 wiki_extractor

- 词条文件解析:文件内容为 XML 格式,使用 xml.etree 解析

- 提取结果:词条标题, 词条内容, 词条id

2.2 清洗 wiki_cleaner

- 繁体转为简体:使用 opencc 转换为简体中文

- 词条内容解析:使用 mwparserfromhell 解析并进行处理

- 其他清洗规则:正则替换指定字符、去除空格、合并多个换行等

2.3 生成 wiki_generator

- 读取词条文件:文件为 bz2 格式,使用 bz2file 读取词条文件

- 提取词条数据:wiki_extractor

- 生成语料文件:生成的文件格式为 jsonl 格式,每一行为一条语料数据,格式为:{"id": "词条id", "title": "词条标题", "content": "词条内容"}

AI搜集汇总

数据集介绍

构建方式

维基百科中文语料数据集的构建过程严谨而系统。首先,从维基百科官方提供的下载地址获取最新的中文词条文件,该文件以XML格式压缩存储。随后,通过XML解析工具提取词条的标题、内容和ID。在数据清洗阶段,繁体中文被转换为简体,并使用专门的Wikitext解析工具处理词条内容,去除不必要的格式和字符。最终,经过一系列的提取和清洗操作,生成格式为JSONL的语料文件,每条记录包含词条ID、标题和内容,确保数据的高质量和一致性。

特点

维基百科中文语料数据集具有显著的特点。首先,数据来源权威,确保了信息的准确性和广泛性。其次,数据经过繁简转换和Wikitext解析,使得内容更加标准化和易于处理。此外,数据集以JSONL格式存储,便于逐行读取和处理,适应多种自然语言处理任务的需求。最后,该数据集涵盖了丰富的主题和领域,为研究者提供了广泛的应用场景。

使用方法

维基百科中文语料数据集的使用方法简便而灵活。用户可以通过下载预处理好的JSONL文件,利用Python或其他编程语言逐行读取和解析数据。数据集的结构清晰,每条记录包含词条ID、标题和内容,便于进行文本分析、信息检索和机器学习等任务。此外,数据集的开放性和标准化格式,使得它可以轻松集成到各种自然语言处理框架和工具中,为研究者和开发者提供了极大的便利。

背景与挑战

背景概述

维基百科中文语料数据集的创建,标志着自然语言处理领域在多语言资源开发方面的重要进展。该数据集由维基百科中文词条文件生成,主要研究人员或机构通过解析和清洗维基百科的XML格式文件,提取并转换繁体中文为简体中文,最终生成结构化的语料文件。这一过程不仅丰富了中文自然语言处理的资源库,也为相关研究提供了高质量的文本数据,极大地推动了中文信息处理技术的发展。

当前挑战

维基百科中文语料数据集的构建过程中面临多项挑战。首先,解析维基百科的XML格式文件需要高效的算法和工具,以确保数据的准确提取。其次,繁体中文到简体中文的转换不仅涉及语言学的复杂性,还需处理多种方言和地区差异。此外,Wikitext格式的解析和处理增加了数据清洗的难度,需应用多种清洗规则以保证语料的纯净度。最后,生成结构化的语料文件要求高度的技术集成和数据管理能力,以确保每条语料的完整性和一致性。

常用场景

经典使用场景

维基百科中文语料数据集在自然语言处理领域中具有广泛的应用。其经典使用场景包括但不限于:构建大规模中文语料库,用于训练语言模型、词向量生成、文本分类、信息检索等任务。通过解析和清洗维基百科的词条内容,研究人员能够获取高质量的中文文本数据,从而提升各类自然语言处理模型的性能。

衍生相关工作

基于维基百科中文语料,衍生了许多经典的研究工作。例如,研究人员利用该数据集训练了多种中文预训练语言模型,如BERT、GPT等,这些模型在中文自然语言处理任务中表现出色。此外,还有学者基于此数据集开发了中文词向量模型,用于词义相似度计算和文本分类。这些工作不仅丰富了中文自然语言处理的工具库,还为后续研究提供了坚实的基础。

数据集最近研究

最新研究方向

在自然语言处理领域,维基百科中文语料的最新研究方向主要集中在语料的深度挖掘与应用上。研究者们致力于通过先进的文本分析技术,如深度学习模型和语义解析算法,来提取和分析维基百科中的丰富信息。这些研究不仅提升了中文文本处理的能力,还为跨语言信息检索、知识图谱构建以及智能问答系统等前沿应用提供了坚实的基础。此外,随着数据隐私和伦理问题的日益重要,如何在保证数据安全的前提下,高效利用维基百科语料进行研究,也成为了一个新兴的研究热点。

以上内容由AI搜集并总结生成