MMCU|多学科选择题数据集|模型评估数据集

收藏MMCU 数据集概述

数据集简介

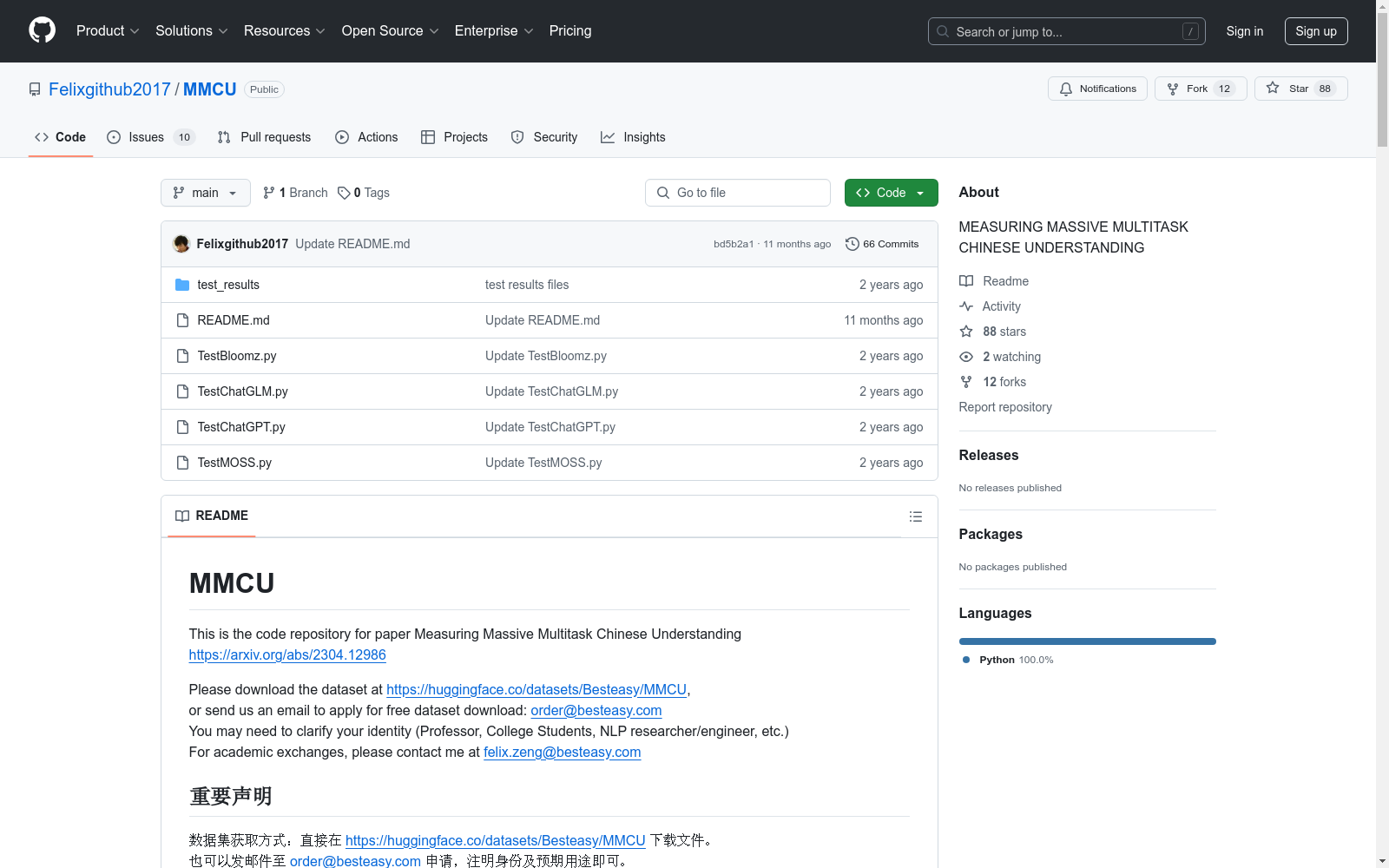

MMCU(Massive Multitask Chinese Understanding)数据集是一个用于评估大规模多任务中文理解能力的数据集。该数据集旨在测试模型在多个领域(如医疗、法律、心理学、教育等)中的语义理解能力。

数据集获取

- 下载地址:https://huggingface.co/datasets/Besteasy/MMCU

- 申请方式:发送邮件至 order@besteasy.com 申请,需注明身份及预期用途。

数据集用途

- 用于评测模型在中文多任务理解上的性能。

- 帮助研究者验证训练策略的有效性。

- 数据集公开评测方式、评测数据集和评测记录,确保可复现性。

数据集更新

- 2023.8.11:发布中文大模型生成能力自动化评测基准CG-Eval,详见论文 Evaluating the Generation Capabilities of Large Chinese Language Models。

- 2023.5.15:对所有模型进行了重新评测,结果上传至

test_results文件夹。 - 2023.5.13:修正了部分题目的缺失答案。

- 2023.5.12:修正了模型预测答案匹配方法,优化了评测结果文件格式。

评测结果

四大领域平均分数

| 领域 | zero-shot | bloomz_560m | bloomz_1b1 | bloomz_3b | bloomz_7b1_mt | ChatGLM 6B | MOSS 16B | GPT-3.5-turbo |

|---|---|---|---|---|---|---|---|---|

| 医疗 | 0.298 | 0.213 | 0.374 | 0.364 | 0.338 | 0.234 | 0.512 | |

| 法律 | 0.163 | 0.14 | 0.18 | 0.174 | 0.169 | 0.133 | 0.239 | |

| 心理学 | 0.201 | 0.187 | 0.319 | 0.346 | 0.288 | 0.211 | 0.447 | |

| 教育 | 0.247 | 0.275 | 0.315 | 0.316 | 0.333 | 0.253 | 0.455 | |

| 平均 | 0.227 | 0.204 | 0.297 | 0.300 | 0.282 | 0.208 | 0.413 |

医疗领域分数

| 子领域 | zero-shot | bloomz_560m | bloomz_1b1 | bloomz_3b | bloomz_7b1_mt | ChatGLM6B | MOSS 16B | GPT-3.5-turbo |

|---|---|---|---|---|---|---|---|---|

| 医学三基 | 0.311 | 0.274 | 0.375 | 0.415 | 0.371 | 0.231 | 0.552 | |

| 药理学 | 0.265 | 0.235 | 0.38 | 0.36 | 0.255 | 0.285 | 0.52 | |

| 护理学 | 0.33 | 0.278 | 0.372 | 0.368 | 0.339 | 0.238 | 0.516 | |

| 病理学 | 0.312 | 0.267 | 0.392 | 0.341 | 0.358 | 0.278 | 0.506 | |

| 临床医学 | 0.347 | 0.198 | 0.426 | 0.554 | 0.455 | 0.317 | 0.693 | |

| 传染病学 | 0.295 | 0.242 | 0.398 | 0.46 | 0.401 | 0.254 | 0.587 | |

| 外科学 | 0.365 | 0.251 | 0.397 | 0.374 | 0.361 | 0.279 | 0.525 | |

| 解剖学 | 0.182 | 0.136 | 0.227 | 0.227 | 0.273 | 0.136 | 0.5 | |

| 医学影像学 | 0.45 | 0.05 | 0.6 | 0.45 | 0.35 | 0.25 | 0.55 | |

| 寄生虫学 | 0.33 | 0.24 | 0.39 | 0.25 | 0.33 | 0.18 | 0.43 | |

| 免疫学 | 0.282 | 0.147 | 0.331 | 0.344 | 0.319 | 0.178 | 0.515 | |

| 儿科学 | 0.39 | 0.258 | 0.385 | 0.38 | 0.399 | 0.263 | 0.54 | |

| 皮肤性病学 | 0.255 | 0.255 | 0.392 | 0.51 | 0.471 | 0.275 | 0.627 | |

| 组织胚胎学 | 0.058 | 0.13 | 0.208 | 0.188 | 0.149 | 0.143 | 0.364 | |

| 药物分析学 | 0.292 | 0.236 | 0.333 | 0.236 | 0.236 | 0.208 | 0.25 | |

| 医疗平均分 | 0.298 | 0.213 | 0.374 | 0.364 | 0.338 | 0.234 | 0.512 |

教育领域分数

| 子领域 | zero-shot | bloomz_560m | bloomz_1b1 | bloomz_3b | bloomz_7b1_mt | ChatGLM6B | MOSS 16B | GPT-3.5-turbo |

|---|---|---|---|---|---|---|---|---|

| 语文 | 0.233 | 0.283 | 0.248 | 0.205 | 0.256 | 0.233 | 0.31 | |

| 数学 | 0.251 | 0.257 | 0.281 | 0.325 | 0.307 | 0.257 | 0.427 | |

| 物理 | 0.173 | 0.208 | 0.185 | 0.202 | 0.256 | 0.208 | 0.327 | |

| 化学 | 0.28 | 0.34 | 0.28 | 0.14 | 0.3 | 0.28 | 0.44 | |

| 政治 | 0.239 | 0.255 | 0.329 | 0.401 | 0.329 | 0.268 | 0.545 | |

| 历史 | 0.279 | 0.296 | 0.421 | 0.432 | 0.448 | 0.245 | 0.513 | |

| 地理 | 0.255 | 0.271 | 0.336 | 0.411 | 0.346 | 0.284 | 0.478 | |

| 生物 | 0.262 | 0.287 | 0.443 | 0.414 | 0.422 | 0.245 | 0.599 | |

| 平均 | 0.247 | 0.275 | 0.315 | 0.316 | 0.333 | 0.253 | 0.455 |

使用说明

- zero-shot测试:不提供示例。

- few-shot测试:提供五个示例。

示例代码

python

zero-shot test for chatgpt

python TestChatGPT.py

--ntrain 0

--data_dir MMCU_dataset_path

--save_dir path_for_test_results

few-shot test for chatgpt

python TestChatGPT.py

--ntrain 5

--data_dir MMCU_dataset_path

--save_dir path_for_test_results

引用

如果您在研究中使用了该数据集,请引用以下论文:

@misc{zeng2023measuring, title={Measuring Massive Multitask Chinese Understanding}, author={Hui Zeng}, year={2023}, eprint={2304.12986}, archivePrefix={arXiv}, primaryClass={cs.CL} }

许可证

MMCU数据集采用 Creative Commons Attribution-NonCommercial-ShareAlike 4.0 International License 许可。

Figshare

Figshare是一个在线数据共享平台,允许研究人员上传和共享各种类型的研究成果,包括数据集、论文、图像、视频等。它旨在促进科学研究的开放性和可重复性。

figshare.com 收录

12306车次数据库

本数据库包含12306车次相关的详细信息,如车次代码、车站代码、列车基本信息和时刻表信息等。数据已按车次等级整理,并提供多种格式的数据文件,方便用户根据实际需求调用。

github 收录

LinkedIn Salary Insights Dataset

LinkedIn Salary Insights Dataset 提供了全球范围内的薪资数据,包括不同职位、行业、地理位置和经验水平的薪资信息。该数据集旨在帮助用户了解薪资趋势和市场行情,支持职业规划和薪资谈判。

www.linkedin.com 收录

yahoo-finance-data

该数据集包含从Yahoo! Finance、Nasdaq和U.S. Department of the Treasury获取的财务数据,旨在用于研究和教育目的。数据集包括公司详细信息、高管信息、财务指标、历史盈利、股票价格、股息事件、股票拆分、汇率和每日国债收益率等。每个数据集都有其来源、简要描述以及列出的列及其数据类型和描述。数据定期更新,并以Parquet格式提供,可通过DuckDB进行查询。

huggingface 收录

NuminaMath-CoT

数据集包含约86万道数学题目,每道题目的解答都采用思维链(Chain of Thought, CoT)格式。数据来源包括中国高中数学练习题以及美国和国际数学奥林匹克竞赛题目。数据主要从在线考试试卷PDF和数学讨论论坛收集。处理步骤包括从原始PDF中进行OCR识别、分割成问题-解答对、翻译成英文、重新对齐以生成CoT推理格式,以及最终答案格式化。

huggingface 收录