Dendory/tarot|塔罗牌占卜数据集|机器学习数据集

收藏hugging_face2023-07-06 更新2024-03-04 收录

下载链接:

https://hf-mirror.com/datasets/Dendory/tarot

下载链接

链接失效反馈资源简介:

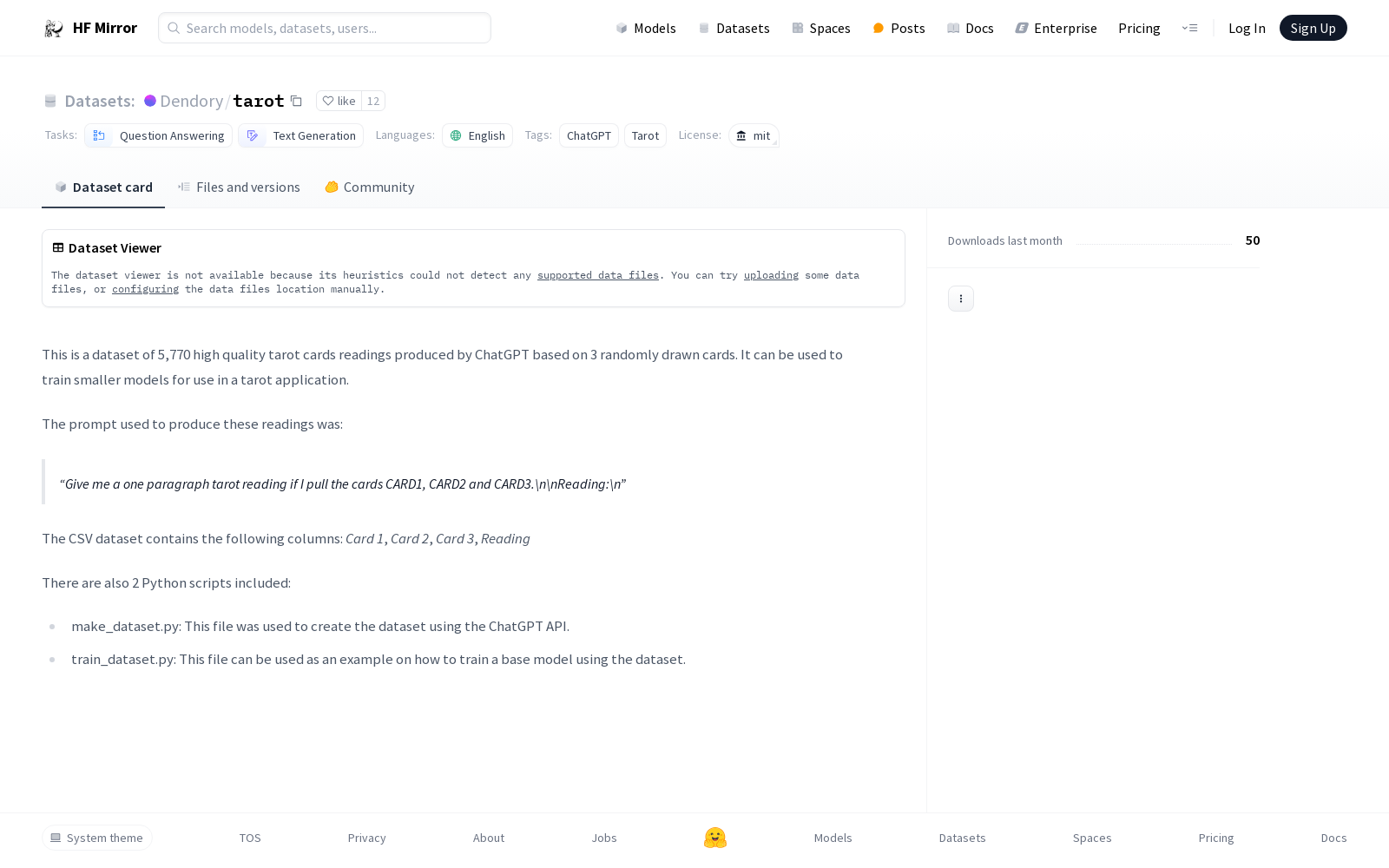

这是一个由ChatGPT生成的塔罗牌解读数据集,包含5,770条高质量的塔罗牌解读,基于随机抽取的三张牌。数据集可用于训练较小的模型,以应用于塔罗牌应用程序。数据集的生成提示是要求ChatGPT根据三张牌生成一段塔罗牌解读。CSV数据集中包含四列:Card 1、Card 2、Card 3和Reading。此外,还包含两个Python脚本:make_dataset.py用于使用ChatGPT API创建数据集,train_dataset.py用于展示如何使用该数据集训练基础模型。

提供机构:

Dendory

原始信息汇总

数据集概述

基本信息

- 语言: 英语

- 名称: Tarot cards readings

- 标签: ChatGPT, Tarot

- 许可证: MIT

- 任务类别: 问答, 文本生成

数据集详情

- 规模: 包含5,770个高质量的塔罗牌阅读数据

- 生成方式: 由ChatGPT根据随机抽取的3张牌生成

- 应用场景: 用于训练小型模型,适用于塔罗牌应用

数据结构

- 数据格式: CSV

- 列信息:

- Card 1

- Card 2

- Card 3

- Reading

附加资源

- 脚本:

- make_dataset.py: 用于通过ChatGPT API创建数据集

- train_dataset.py: 作为训练基础模型的示例脚本

AI搜集汇总

数据集介绍

构建方式

Dendory/tarot数据集的构建,是通过ChatGPT API生成5790条高质量塔罗牌阅读记录,每条记录基于随机抽取的三张塔罗牌。构建过程中,采用特定提示语以激发生成式对话,从而形成具有深度的阅读内容,进而用于训练塔罗牌应用中规模更小的模型。

特点

该数据集显著的特征在于,其内容均为基于塔罗牌的三张牌面所生成的独段式阅读,语言风格统一,质量高。数据集采用MIT许可证,开放性强,便于学术与商业研究。其结构包含四列,分别为三张牌的名称与对应的阅读内容,为塔罗牌阅读相关任务提供了丰富且专业的语料。

使用方法

使用Dendory/tarot数据集,首先需要导入数据集,并可根据具体任务需求,如问答或文本生成,对数据集进行预处理。数据集附带的两个Python脚本,make_dataset.py用于创建数据集,train_dataset.py则提供了基于该数据集训练基础模型的示例。用户可参照示例,利用该数据集进行模型训练或进一步的研究探索。

背景与挑战

背景概述

在人工智能领域,对话系统与文本生成技术逐渐成为研究热点。Dendory/tarot数据集,创建于近期,由ChatGPT生成,旨在为研究者和开发者提供高质量的塔罗牌阅读文本,以训练和优化相关应用模型。该数据集包含了5,770条基于三张随机抽取的塔罗牌的阅读内容,对于塔罗牌阅读这一神秘领域的人工智能研究,具有不容忽视的参考价值。核心研究问题聚焦于如何利用人工智能技术准确模拟塔罗牌阅读过程,从而提高对话系统的智能化水平。Dendory/tarot数据集的出现,为该领域的研究提供了新的视角和数据支持,对相关技术的发展产生了积极影响。

当前挑战

尽管Dendory/tarot数据集在塔罗牌阅读领域具有创新性,但其在构建和应用过程中也面临着若干挑战。首先,数据集的生成依赖于ChatGPT的API,如何保证生成的阅读内容的质量和准确性是一大难题。其次,塔罗牌阅读涉及大量主观解释和象征意义,如何让模型准确理解和生成这些内容,是对自然语言处理技术的重大考验。此外,构建过程中还需克服数据标注的主观性、多义性以及模型训练时的泛化能力等挑战。

常用场景

经典使用场景

在人工智能领域,特别是在自然语言处理任务中,Dendory/tarot数据集以其独特的构成,成为研究者和开发者探索塔罗牌阅读自动化的宝贵资源。该数据集最经典的使用场景在于,通过训练小型模型,实现对三张随机抽取塔罗牌的读牌内容自动生成,进而辅助用户理解牌面含义。

衍生相关工作

基于Dendory/tarot数据集,研究者们已衍生出多项相关工作,如塔罗牌阅读理解的深入研究、情感分析与塔罗牌解读相结合的应用,以及塔罗牌阅读辅助系统的开发等,这些研究进一步拓展了塔罗牌在人工智能领域的应用边界。

数据集最近研究

最新研究方向

在人工智能与心灵感应交互的领域内,Dendory/tarot数据集成为近期研究的新宠。此数据集以ChatGPT生成的5790条高质量塔罗牌阅读记录为基础,不仅丰富了自然语言处理任务中的问答和文本生成类别,更为构建能够模拟塔罗牌阅读的小型模型提供了可靠资源。当前研究正聚焦于如何利用此数据集提升机器学习模型对抽象符号解读的能力,进而推动心灵感应式对话系统的发展。这不仅关联到心理咨询、决策辅助等热点事件,其研究成果亦有望深化人类对意识与机器交互边界的理解。

以上内容由AI搜集并总结生成