chinese-fineweb-edu|教育数据集|自然语言处理数据集

收藏huggingface2024-08-29 更新2024-12-12 收录

下载链接:

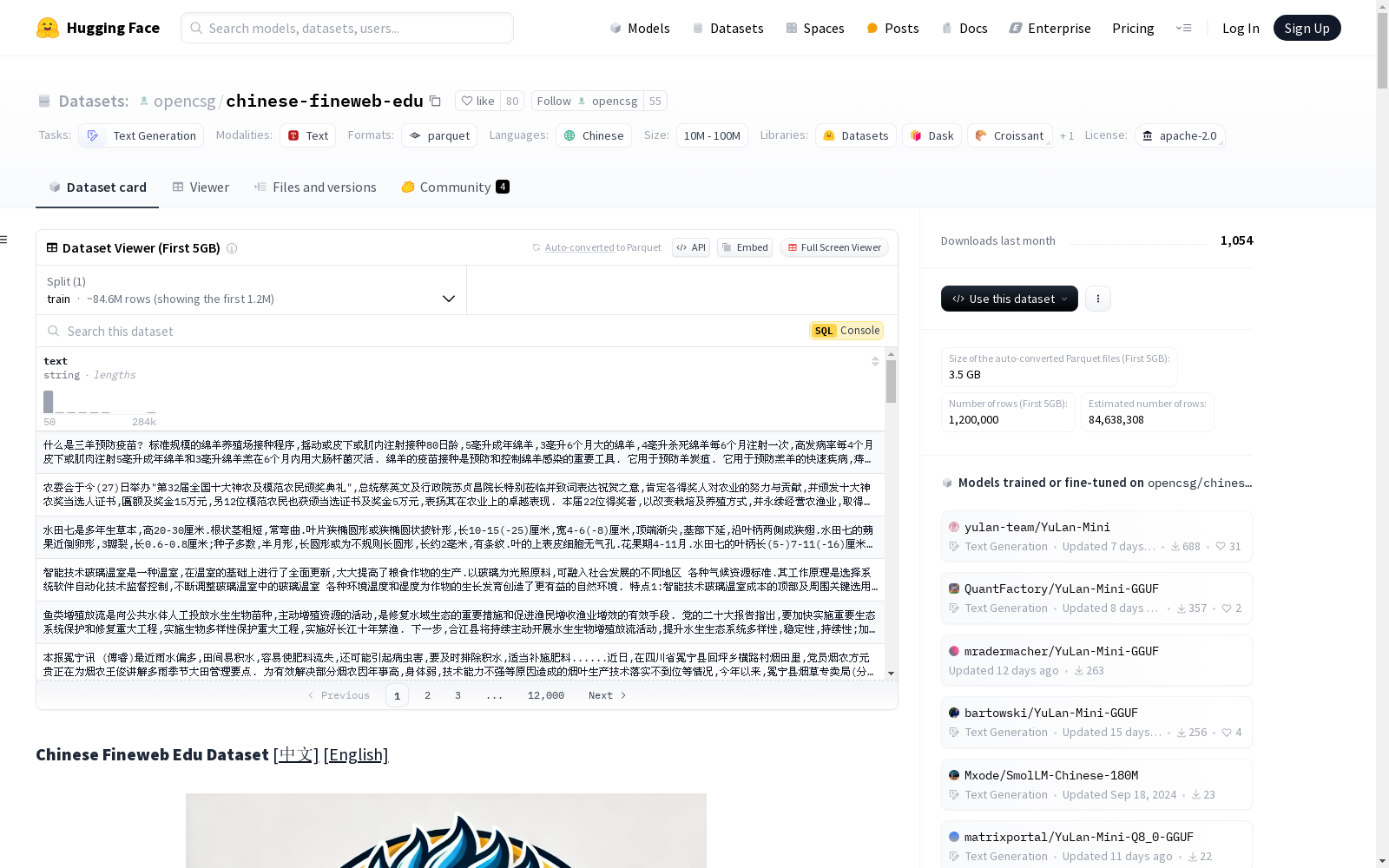

https://huggingface.co/datasets/opencsg/chinese-fineweb-edu

下载链接

链接失效反馈资源简介:

Chinese Fineweb Edu数据集是一个精心构建的高质量中文预训练语料数据集,专为教育领域的自然语言处理任务设计。该数据集通过严格的筛选和去重流程,利用少量数据训练打分模型进行评估,从海量的原始数据中提取出高价值的教育相关内容,确保数据的质量和多样性。最终,数据集包含约90M条高质量的中文文本数据,总大小约为300GB。

创建时间:

2024-08-26

原始信息汇总

Chinese Fineweb Edu 数据集介绍

概述

Chinese Fineweb Edu 数据集是一个精心构建的高质量中文预训练语料数据集,专为教育领域的自然语言处理任务设计。该数据集包含约90M条高质量的中文文本数据,总大小约为300GB。

筛选方法

数据集通过以下步骤进行筛选和处理:

- 教育价值评估:使用Opencsg的csg-wukong-enterprise企业版大模型对样本进行教育价值评估,给出0-5的评分。

- 打分模型训练:利用100k条高评分样本训练BERT模型,用于对更大规模的预训练数据集进行文本打分。

- 数据筛选:使用训练好的BERT模型对原始数据进行全面打分,仅保留得分大于4的数据。

- MinHash去重:采用MinHash算法对数据进行去重处理,确保数据的独特性。

原始数据来源

数据集的原始数据来源包括:

打分模型

使用OpenCSG的csg-wukong-enterprise企业版大模型作为打分模型,对每条预训练样本进行0-5分的评分。数据集包含100k条数据及其得分,形成fineweb_edu_classifier_chinese_data,并训练了一个中文Bert模型 fineweb_edu_classifier_chinese。

许可协议

使用 Chinese Fineweb Edu 数据集需要遵循 OpenCSG 社区许可证,支持商业用途。如用于商业用途,需发送邮件至 lorraineg@opencsg.com,并获得许可。

AI搜集汇总

数据集介绍

构建方式

Chinese Fineweb Edu 数据集的构建过程体现了对教育领域文本数据的高度重视。首先,通过OpenCSG的csg-wukong-enterprise模型对样本进行教育价值评估,筛选出约100k条高质量数据。随后,利用这些数据训练BERT模型,进一步对大规模预训练数据集进行打分,仅保留得分大于4的高质量文本。最后,采用MinHash算法进行去重处理,确保数据的独特性和多样性。整个构建过程严格遵循数据筛选和质量控制的标准,确保了数据集的可靠性和适用性。

特点

Chinese Fineweb Edu 数据集以其高质量和多样性著称,专为教育领域的自然语言处理任务设计。数据集包含约90M条高质量中文文本,总大小约为300GB。其特点在于通过严格的筛选和去重流程,确保了数据的高教育价值和内容质量。数据集涵盖了多个主流中文预训练数据源,如CCI2-Data、SkyPile-150B等,融合了不同领域和来源的数据,提升了数据集的广泛适用性和全面性。这种多样化的数据来源使得模型在面对复杂教育场景时,能够保持卓越的表现。

使用方法

Chinese Fineweb Edu 数据集的使用方法灵活多样,适用于多种自然语言处理任务。用户可以通过HuggingFace平台直接加载数据集,或通过GitHub获取相关代码和资源。数据集支持商业用途,但需遵循OpenCSG社区许可证和Apache 2.0许可证的条款。对于研究人员和开发者,数据集提供了高质量的训练数据,可用于教育领域的文本生成、分类等任务。此外,OpenCSG计划开源数据集和打分模型,进一步推动社区的发展和合作。

背景与挑战

背景概述

Chinese Fineweb Edu 数据集是由OpenCSG社区精心构建的高质量中文预训练语料库,专为教育领域的自然语言处理任务设计。该数据集创建于2023年,旨在通过严格的筛选和去重流程,从海量的原始数据中提取出高价值的教育相关内容,确保数据的质量和多样性。数据集包含约90M条高质量的中文文本数据,总大小约为300GB。其核心研究问题在于如何通过高质量的教育相关数据提升中文语言模型在教育领域的表现。该数据集的发布为中文教育领域的自然语言处理研究提供了重要的数据支持,推动了相关技术的进步。

当前挑战

Chinese Fineweb Edu 数据集在构建过程中面临多重挑战。首先,数据筛选的挑战在于如何从海量的原始数据中准确识别出具有高教育价值的内容。为此,研究人员采用了基于BERT模型的打分机制,并结合MinHash算法进行去重处理,以确保数据的独特性和多样性。其次,数据集的构建依赖于多个主流中文预训练数据集,如CCI2-Data、SkyPile-150B等,如何有效整合这些数据源并保持其一致性也是一个重要挑战。此外,数据集的规模和质量对模型训练的效果具有显著影响,如何在保证数据质量的同时提升数据集的规模,是未来需要进一步解决的问题。

常用场景

经典使用场景

在自然语言处理领域,Chinese Fineweb Edu 数据集广泛应用于教育相关的文本生成任务。其高质量的中文语料库为模型提供了丰富的教育内容,涵盖了从基础教育到高等教育的多样化文本。通过该数据集,研究人员能够训练出在教育场景下表现优异的语言模型,特别是在生成教育材料、解答学生问题以及自动化教学辅助系统等方面展现出卓越的效果。

实际应用

在实际应用中,Chinese Fineweb Edu 数据集被广泛用于开发智能教育系统、在线学习平台以及教育内容生成工具。例如,基于该数据集训练的模型可以自动生成符合教学标准的教材、练习题和解答,极大地减轻了教师的工作负担。此外,该数据集还支持个性化学习推荐系统的开发,帮助学生根据自身学习进度和需求获取定制化的学习资源。

衍生相关工作

Chinese Fineweb Edu 数据集的发布催生了一系列相关研究工作,特别是在教育领域的自然语言处理任务中。基于该数据集,研究人员开发了多个高效的教育文本生成模型和评估工具。例如,OpenCSG 团队利用该数据集训练了专门用于教育文本分类的 BERT 模型,并在多个中文教育评测基准上取得了显著的效果提升。这些工作不仅推动了教育技术的进步,还为其他领域的中文自然语言处理研究提供了宝贵的参考。

以上内容由AI搜集并总结生成