IEMOCAP|情感分析数据集|动态捕捉数据集

收藏

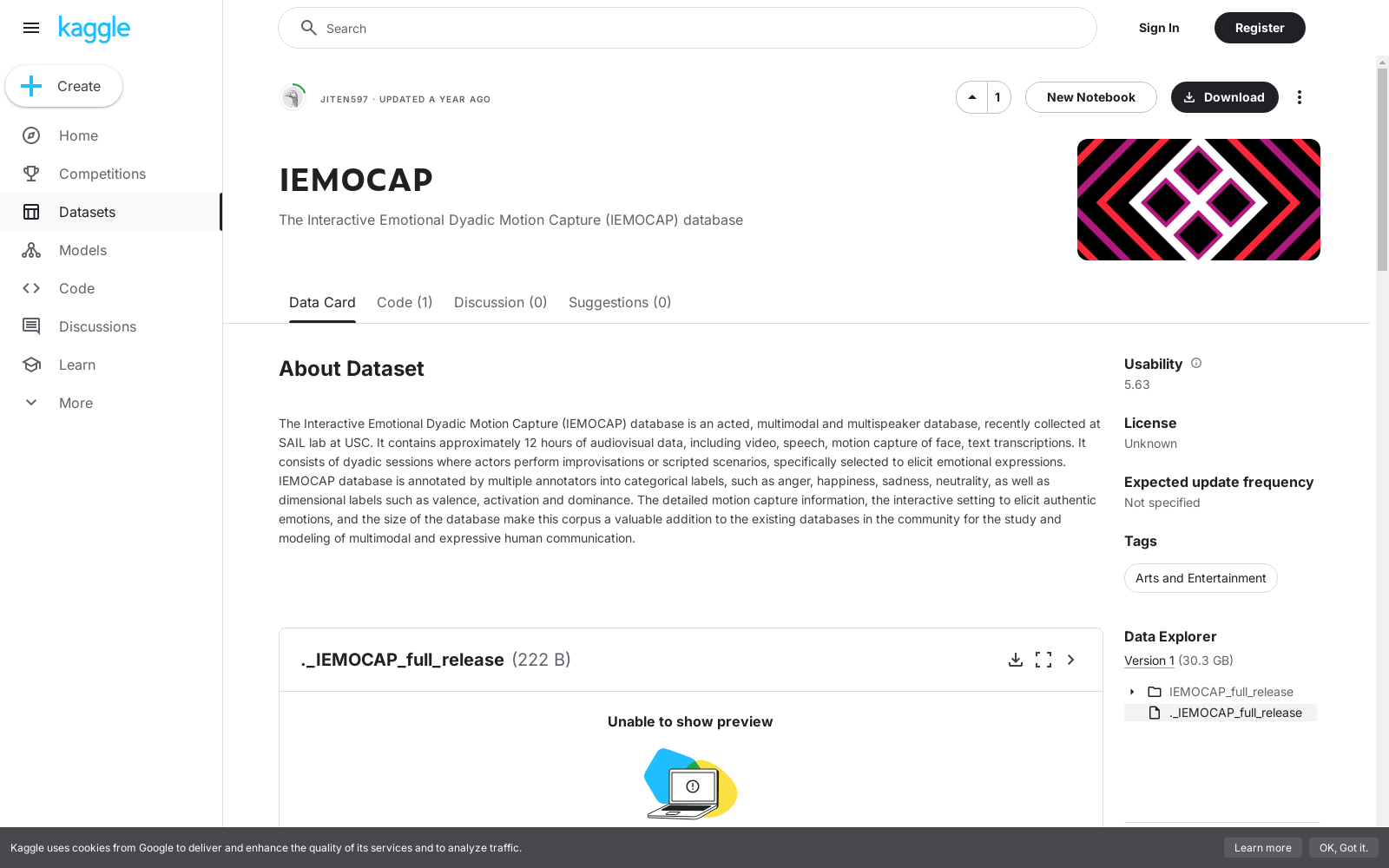

- IEMOCAP数据集首次发表,由美国南加州大学(USC)的交互式音频实验室创建,旨在研究多模态情感识别。

- IEMOCAP数据集首次应用于情感计算领域的研究,特别是在语音情感识别和多模态情感分析中。

- IEMOCAP数据集被广泛用于多模态情感识别竞赛和挑战,推动了情感计算技术的发展。

- IEMOCAP数据集的扩展版本发布,增加了更多的情感类别和多模态数据,进一步丰富了研究资源。

- IEMOCAP数据集成为情感计算领域的重要基准数据集,被众多研究论文引用和使用。

- IEMOCAP数据集的应用扩展到人工智能和机器学习的多个领域,包括情感对话系统和人机交互。

Sleep

该数据集包含关于睡眠效率和持续时间的信息,每个条目代表一个独特的睡眠体验,并包括ID、年龄、性别、睡眠持续时间、睡眠效率、REM睡眠百分比、深度睡眠百分比、轻度睡眠百分比、觉醒次数、咖啡因消费、酒精消费和吸烟状况等列。

github 收录

AISHELL/AISHELL-1

Aishell是一个开源的中文普通话语音语料库,由北京壳壳科技有限公司发布。数据集包含了来自中国不同口音地区的400人的录音,录音在安静的室内环境中使用高保真麦克风进行,并下采样至16kHz。通过专业的语音标注和严格的质量检查,手动转录的准确率超过95%。该数据集免费供学术使用,旨在为语音识别领域的新研究人员提供适量的数据。

hugging_face 收录

Fruits-360

一个高质量的水果图像数据集,包含多种水果的图像,如苹果、香蕉、樱桃等,总计42345张图片,分为训练集和验证集,共有64个水果类别。

github 收录

中国逐日降水数据集(1961-2022,0.1°/0.25°/0.5°)

CHM_PRE数据集基于中国境内及周边1961至今共2839个站点的日降水观测,在传统的“降水背景场 + 降水比值场”的数据集构建思路上,尝试应用月值降水约束和地形特征校正,并依据中国范围内约4万个高密度站点2015–2019年的日降水量插值后数据进行精度评价。经评估认为,CHM_PRE可以较好的表征降水的空间变异性,其日值时间序列与高密度站点日值降水观测结果之间的相关系数中位数为0.78,均方根误差中位数为8.8 mm/d,KGE值中位数为0.69,与目前常用的降水数据集(CGDPA、CN05.1、CMA V2.0)有很好的一致性。 数据集的时间范围为1961年至今,空间分辨率为0.1°、0.25°和0.5°,经纬度范围为18°N–54°N, 72°E–136°E。

国家青藏高原科学数据中心 收录

UniMed

UniMed是一个大规模、开源的多模态医学数据集,由穆罕默德·本·扎耶德人工智能大学等机构创建,包含超过530万张图像-文本对,涵盖六种不同的医学成像模态:X射线、CT、MRI、超声、病理和眼底。数据集通过利用大型语言模型(LLMs)将特定模态的分类数据集转换为图像-文本格式,并结合现有的医学图像-文本数据,实现了可扩展的视觉-语言模型(VLM)预训练。UniMed旨在解决医学领域中公开可用的大规模图像-文本数据稀缺的问题,适用于多种医学成像任务,如零样本分类和跨模态泛化。

arXiv 收录