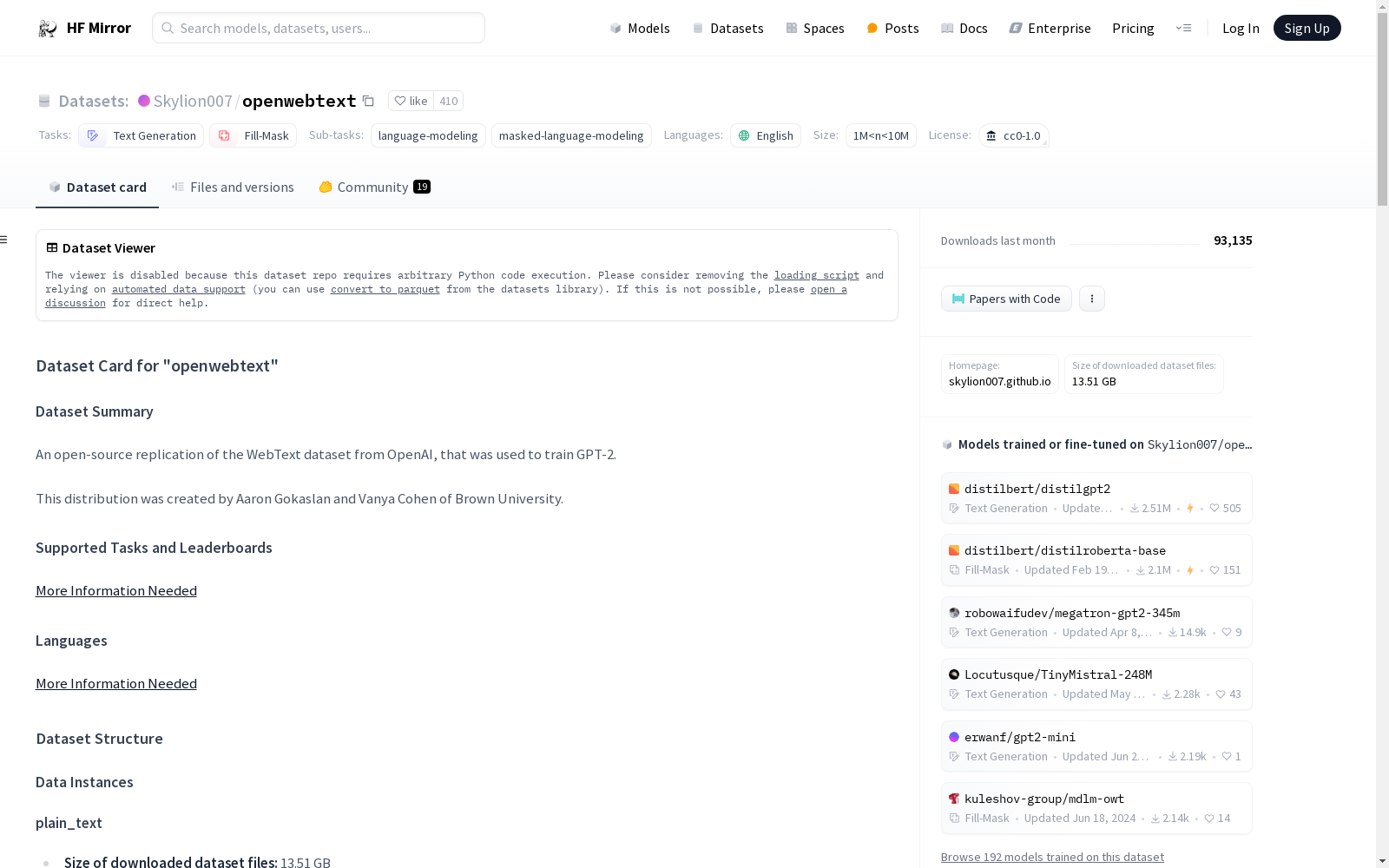

Skylion007/openwebtext|自然语言处理数据集|语言模型训练数据集

收藏数据集概述

名称: OpenWebText

语言: 英语 (en)

许可证: CC0-1.0

多语言性: 单语

大小类别: 1M<n<10M

源数据集: 原始

任务类别:

- 文本生成

- 填充掩码

任务ID:

- 语言建模

- 掩码语言建模

论文代码ID: openwebtext

数据集结构

特征:

- text: 字符串类型

配置名称: plain_text

分割:

- train:

- 字节数: 39769491688

- 示例数: 8013769

下载大小: 12880189440字节

数据集大小: 39769491688字节

数据集创建

来源数据:

- 初始数据收集和规范化:

- 从Reddit提交数据集中提取所有Reddit帖子URL。

- 去重,过滤非HTML内容,随机洗牌。

- 使用newspaper python包下载并提取网页。

- 使用Facebook FastText过滤非英语网页。

- 使用局部敏感哈希(LSH)识别近似重复文档。

- 文档被哈希成5-gram集合,相似度阈值大于0.5的文档被移除。

- 剩余文档被分词,少于128个词的文档被移除。

- 剩余38GB文本数据(使用SI单位为40GB)来自8,013,769个文档。

注释: 无注释

许可证信息:

引用信息:

@misc{Gokaslan2019OpenWeb, title={OpenWebText Corpus}, author={Gokaslan, Aaron and Cohen, Vanya and Pavlick, Ellie and Tellex, Stefanie}, howpublished={url{http://Skylion007.github.io/OpenWebTextCorpus}}, year={2019} }

HazyDet

HazyDet是由解放军工程大学等机构创建的一个大规模数据集,专门用于雾霾场景下的无人机视角物体检测。该数据集包含383,000个真实世界实例,收集自自然雾霾环境和正常场景中人工添加的雾霾效果,以模拟恶劣天气条件。数据集的创建过程结合了深度估计和大气散射模型,确保了数据的真实性和多样性。HazyDet主要应用于无人机在恶劣天气条件下的物体检测,旨在提高无人机在复杂环境中的感知能力。

arXiv 收录

中国农村金融统计数据

该数据集包含了中国农村金融的统计信息,涵盖了农村金融机构的数量、贷款余额、存款余额、金融服务覆盖率等关键指标。数据按年度和地区分类,提供了详细的农村金融发展状况。

www.pbc.gov.cn 收录

Crop Yield Prediction Dataset

Impact of Environmental Factors on Crop Yields Across Countries

kaggle 收录

DIOR

“DIOR” 是用于光学遥感图像中对象检测的大规模基准数据集,该数据集由23,463图像和带有水平边界框注释的192,518对象实例组成。

OpenDataLab 收录

ScanNet v2

ScanNet 是一个 RGB-D 视频数据集,包含 1500 多次扫描中的 250 万个视图,并使用 3D 相机姿势、表面重建和实例级语义分割进行注释。为了收集这些数据,我们设计了一个易于使用且可扩展的 RGB-D 捕获系统,其中包括自动表面重建和众包语义注释。我们表明,使用这些数据有助于在几个 3D 场景理解任务上实现最先进的性能,包括 3D 对象分类、语义体素标记和 CAD 模型检索。

OpenDataLab 收录