Chumor 1.0 - 来自“弱智吧”的中文幽默理解数据集|中文幽默理解数据集|语言模型挑战数据集

收藏Chumor-dataset 概述

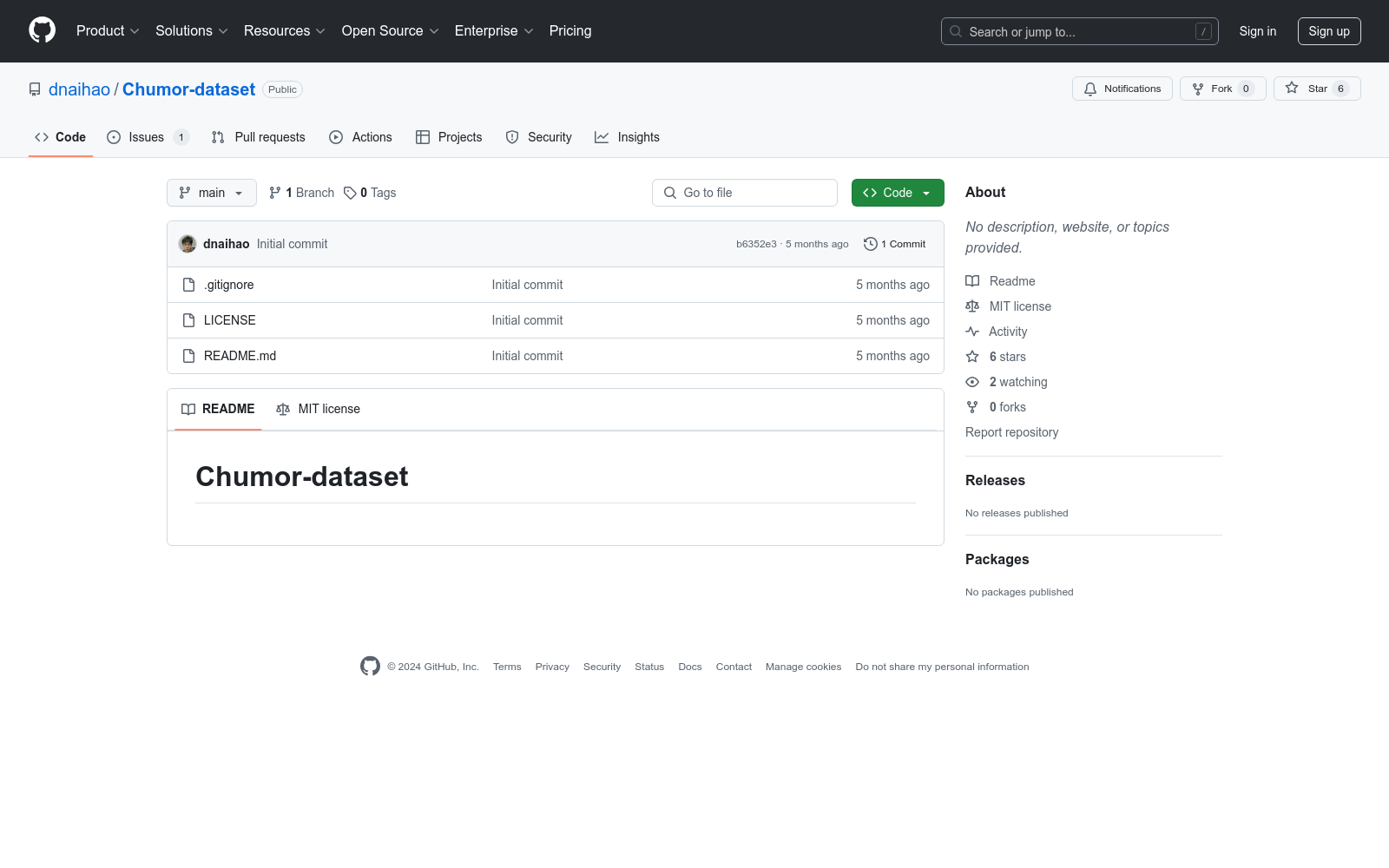

数据集名称

- Chumor-dataset

数据集内容

- 暂无详细描述。

数据集用途

- 暂无详细描述。

数据集结构

- 暂无详细描述。

数据集来源

- 暂无详细描述。

数据集版本

- 暂无详细描述。

数据集更新频率

- 暂无详细描述。

数据集许可证

- 暂无详细描述。

学生课堂行为数据集 (SCB-dataset3)

学生课堂行为数据集(SCB-dataset3)由成都东软学院创建,包含5686张图像和45578个标签,重点关注六种行为:举手、阅读、写作、使用手机、低头和趴桌。数据集覆盖从幼儿园到大学的不同场景,通过YOLOv5、YOLOv7和YOLOv8算法评估,平均精度达到80.3%。该数据集旨在为学生行为检测研究提供坚实基础,解决教育领域中学生行为数据集的缺乏问题。

arXiv 收录

MOOCs Dataset

该数据集包含了大规模开放在线课程(MOOCs)的相关数据,包括课程信息、用户行为、学习进度等。数据主要用于研究在线教育的行为模式和学习效果。

www.kaggle.com 收录

LibriSpeech

LibriSpeech 是一个大约 1000 小时的 16kHz 英语朗读语音语料库,由 Vassil Panayotov 在 Daniel Povey 的协助下编写。数据来自 LibriVox 项目的已读有声读物,并经过仔细分割和对齐。

OpenDataLab 收录

ChineseSafe

ChineseSafe是由南方科技大学统计与数据科学系创建的一个中文安全评估基准数据集,旨在评估大型语言模型在识别中文不安全内容方面的能力。该数据集包含205,034个样本,涵盖4个类别和10个子类别的安全问题,特别关注政治敏感性、色情内容和变体/同音词等新型安全问题。数据集通过从开源数据集和互联网资源中收集数据,经过数据清洗和去重处理,确保了数据集的高质量和多样性。ChineseSafe的应用领域主要集中在大型语言模型的安全评估,旨在帮助开发者和研究者提升模型在实际应用中的安全性。

arXiv 收录

网易云音乐数据集

该数据集包含了网易云音乐平台上的歌手信息、歌曲信息和歌单信息,数据通过爬虫技术获取并整理成CSV格式,用于音乐数据挖掘和推荐系统构建。

github 收录