Penn Action|动作识别数据集|人体姿态估计数据集

收藏

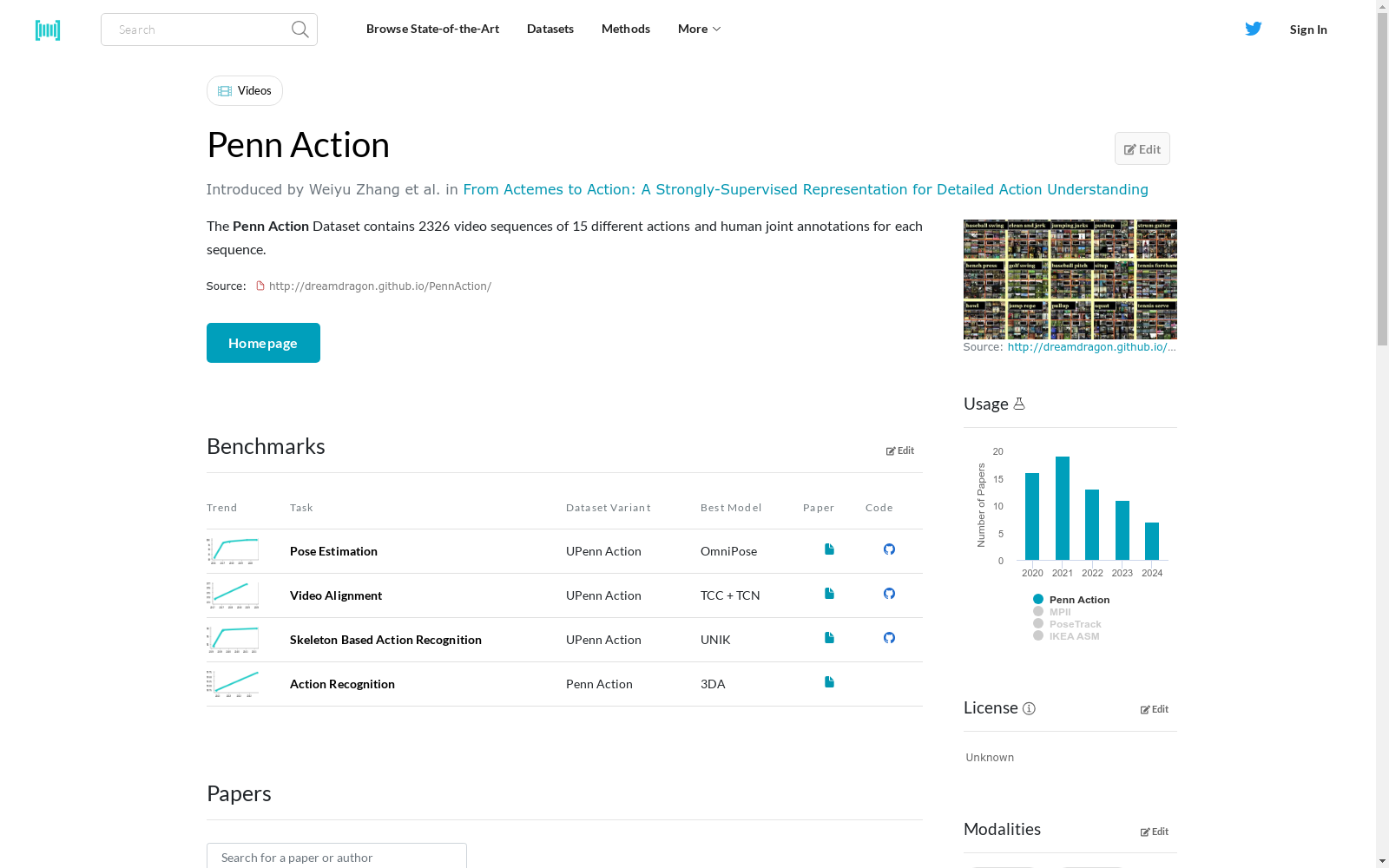

- Penn Action数据集首次发表,由宾夕法尼亚大学和加州大学伯克利分校的研究团队共同发布。该数据集包含2326个视频序列,涵盖15个不同的动作类别,旨在推动人体动作识别和姿态估计的研究。

- Penn Action数据集首次应用于计算机视觉领域的研究,特别是在人体动作识别和姿态估计方面。研究者们利用该数据集开发了多种算法,显著提升了相关任务的性能。

- Penn Action数据集被广泛应用于多个国际会议和期刊的论文中,成为评估人体动作识别和姿态估计算法的标准数据集之一。

- 随着深度学习技术的发展,Penn Action数据集被用于训练和验证多种深度学习模型,进一步推动了人体动作识别和姿态估计领域的研究进展。

- Penn Action数据集的扩展版本发布,增加了更多的视频序列和动作类别,以适应日益复杂的计算机视觉任务需求。

- 1Penn Action: A Large Scale Video Dataset for Human Action UnderstandingUniversity of Pennsylvania · 2015年

- 2Human Action Recognition Using Deep Learning: A SurveyUniversity of Surrey · 2020年

- 3A Survey on Human Action Recognition in VideosIndian Institute of Technology · 2021年

- 4Deep Learning for Human Action Recognition: A ReviewUniversity of Technology Sydney · 2019年

- 5Human Action Recognition Using Deep Learning: A Comparative StudyUniversity of California, Irvine · 2022年

中国气象数据

本数据集包含了中国2023年1月至11月的气象数据,包括日照时间、降雨量、温度、风速等关键数据。通过这些数据,可以深入了解气象现象对不同地区的影响,并通过可视化工具揭示中国的气温分布、降水情况、风速趋势等。

github 收录

中国行政区划数据

本项目为中国行政区划数据,包括省级、地级、县级、乡级和村级五级行政区划数据。数据来源于国家统计局,存储格式为sqlite3 db文件,支持直接使用数据库连接工具打开。

github 收录

YOLO Drone Detection Dataset

为了促进无人机检测模型的开发和评估,我们引入了一个新颖且全面的数据集,专门为训练和测试无人机检测算法而设计。该数据集来源于Kaggle上的公开数据集,包含在各种环境和摄像机视角下捕获的多样化的带注释图像。数据集包括无人机实例以及其他常见对象,以实现强大的检测和分类。

github 收录

Traditional-Chinese-Medicine-Dataset-SFT

该数据集是一个高质量的中医数据集,主要由非网络来源的内部数据构成,包含约1GB的中医各个领域临床案例、名家典籍、医学百科、名词解释等优质内容。数据集99%为简体中文内容,质量优异,信息密度可观。数据集适用于预训练或继续预训练用途,未来将继续发布针对SFT/IFT的多轮对话和问答数据集。数据集可以独立使用,但建议先使用配套的预训练数据集对模型进行继续预训练后,再使用该数据集进行进一步的指令微调。数据集还包含一定比例的中文常识、中文多轮对话数据以及古文/文言文<->现代文翻译数据,以避免灾难性遗忘并加强模型表现。

huggingface 收录

CMNEE(Chinese Military News Event Extraction dataset)

CMNEE(Chinese Military News Event Extraction dataset)是国防科技大学、东南大学和清华大学联合构建的一个大规模的、基于文档标注的开源中文军事新闻事件抽取数据集。该数据集包含17,000份文档和29,223个事件,所有事件均基于预定义的军事领域模式人工标注,包括8种事件类型和11种论元角色。数据集构建遵循两阶段多轮次标注策略,首先通过权威网站获取军事新闻文本并预处理,然后依据触发词字典进行预标注,经领域专家审核后形成事件模式。随后,通过人工分批、迭代标注并持续修正,直至满足既定质量标准。CMNEE作为首个专注于军事领域文档级事件抽取的数据集,对推动相关研究具有显著意义。

github 收录