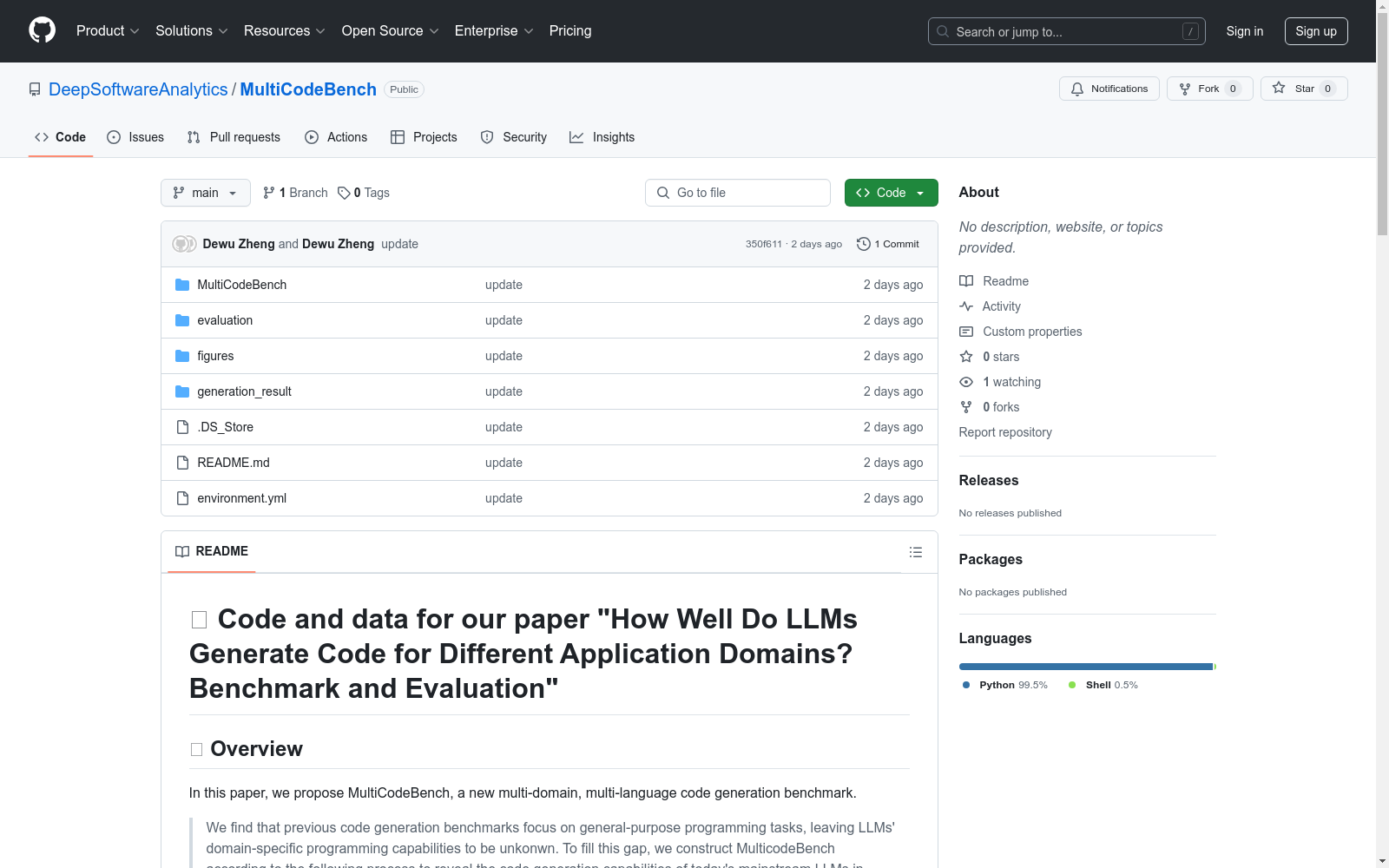

MultiCodeBench|代码生成数据集|软件开发数据集

收藏MultiCodeBench 数据集概述

数据集简介

MultiCodeBench 是一个多领域、多语言的代码生成基准测试数据集,旨在揭示当前主流大语言模型(LLMs)在流行软件应用领域中的代码生成能力。该数据集填补了以往代码生成基准测试主要集中在通用编程任务上的空白。

数据集结构

MultiCodeBench 数据集涵盖了12个不同的应用领域,每个领域对应一个JSON文件,具体包括:

Cloud_service.jsonBlock_chain.jsonDesktop_application.jsonDistributed_system.jsonGame.jsonMobile.jsonWeb.jsonRobot.jsonEnterprise_application.jsonData_analysis.jsonDeep_learning.jsonIoT.json

评估工具

MultiCodeBench 提供了CodeBleu评估工具,用于评估代码生成结果。CodeBleu工具包含以下组件:

- keywords: 通过代码语法和语义对齐提高相似性准确性。

- parser: 包含数据流图(DFG)提取工具,支持所有覆盖的语言。

- bleu.py: 计算BLEU分数。

- calc_code_bleu.py: 计算CodeBLEU分数。

- dataflow_match.py: 数据流匹配。

- syntax_match.py: 语法匹配。

- utils.py: 工具函数。

- weighted_ngram_match.py: 加权n-gram匹配。

- run_script.sh: 运行脚本。

快速开始

- 克隆该仓库。

- 运行

conda env create -f environment.yml创建名为 MultiCodeBench 的 conda 环境。

评估方法

将生成的代码结果放入 generation_result/docststring_only/{model_name} 文件夹中,然后在 MultiCodeBench/evaluation/CodeBleu 目录下运行以下命令:

bash

python calc_code_bleu.py --model {model_name} --predict_result_base_path generation_result/docstring_only

或者可以直接修改 MultiCodeBench/evaluation/CodeBleu/calc_code_bleu.py 中的源代码以自定义生成结果。

典型分布式光伏出力预测数据集

光伏电站出力数据每5分钟从电站机房监控系统获取;气象实测数据从气象站获取,气象站建于电站30号箱变附近,每5分钟将采集的数据通过光纤传输到机房;数值天气预报数据利用中国电科院新能源气象应用机房的WRF业务系统(包括30TF计算刀片机、250TB并行存储)进行中尺度模式计算后输出预报产品,每日8点前通过反向隔离装置推送到电站内网预测系统。

国家基础学科公共科学数据中心 收录

Desert Knowledge Australia Solar Centre PV Power Data

该数据集包含来自澳大利亚Alice Springs的Site 7的太阳能发电数据,包括有功功率(AP,kW)、历史温度(T,℃)、相对湿度(RH,%)、全球水平辐照度(GHI,Wh/m²)和漫射水平辐照度(DHI,Wh/m²)。

github 收录

PUZZLES

PUZZLES是由苏黎世联邦理工学院的研究团队基于Simon Tatham的便携式谜题集合开发的强化学习基准数据集,包含40种不同复杂度的逻辑谜题。这些谜题具有可调整的大小和难度,适用于评估强化学习代理的算法和逻辑推理能力。数据集的创建过程中,研究团队将原始C源代码扩展至Pygame库标准,并集成到Gymnasium框架API中,使得用户可以灵活调整谜题的难度和大小。PUZZLES主要应用于强化学习领域,旨在推动算法和逻辑推理在机器学习中的应用和发展。

arXiv 收录

RAVDESS

情感语音和歌曲 (RAVDESS) 的Ryerson视听数据库包含7,356个文件 (总大小: 24.8 GB)。该数据库包含24位专业演员 (12位女性,12位男性),以中性的北美口音发声两个词汇匹配的陈述。言语包括平静、快乐、悲伤、愤怒、恐惧、惊讶和厌恶的表情,歌曲则包含平静、快乐、悲伤、愤怒和恐惧的情绪。每个表达都是在两个情绪强度水平 (正常,强烈) 下产生的,另外还有一个中性表达。所有条件都有三种模态格式: 纯音频 (16位,48kHz .wav),音频-视频 (720p H.264,AAC 48kHz,.mp4) 和仅视频 (无声音)。注意,Actor_18没有歌曲文件。

OpenDataLab 收录

SKIPP’D

SKIPP’D数据集由斯坦福大学的环境评估与优化(EAO)组创建,旨在为基于图像的短期太阳能预测研究提供标准化基准。数据集包含2017至2019年三年的高质量控制下采样的天空图像和光伏发电数据,适合深度学习模型开发。此外,还提供了高分辨率、高频率的天空图像和光伏发电数据,以及相应的视频片段,以支持研究灵活性。数据集的应用领域包括天空图像分割、云类型分类和云运动预测,旨在解决太阳能预测中的短期波动问题。

arXiv 收录