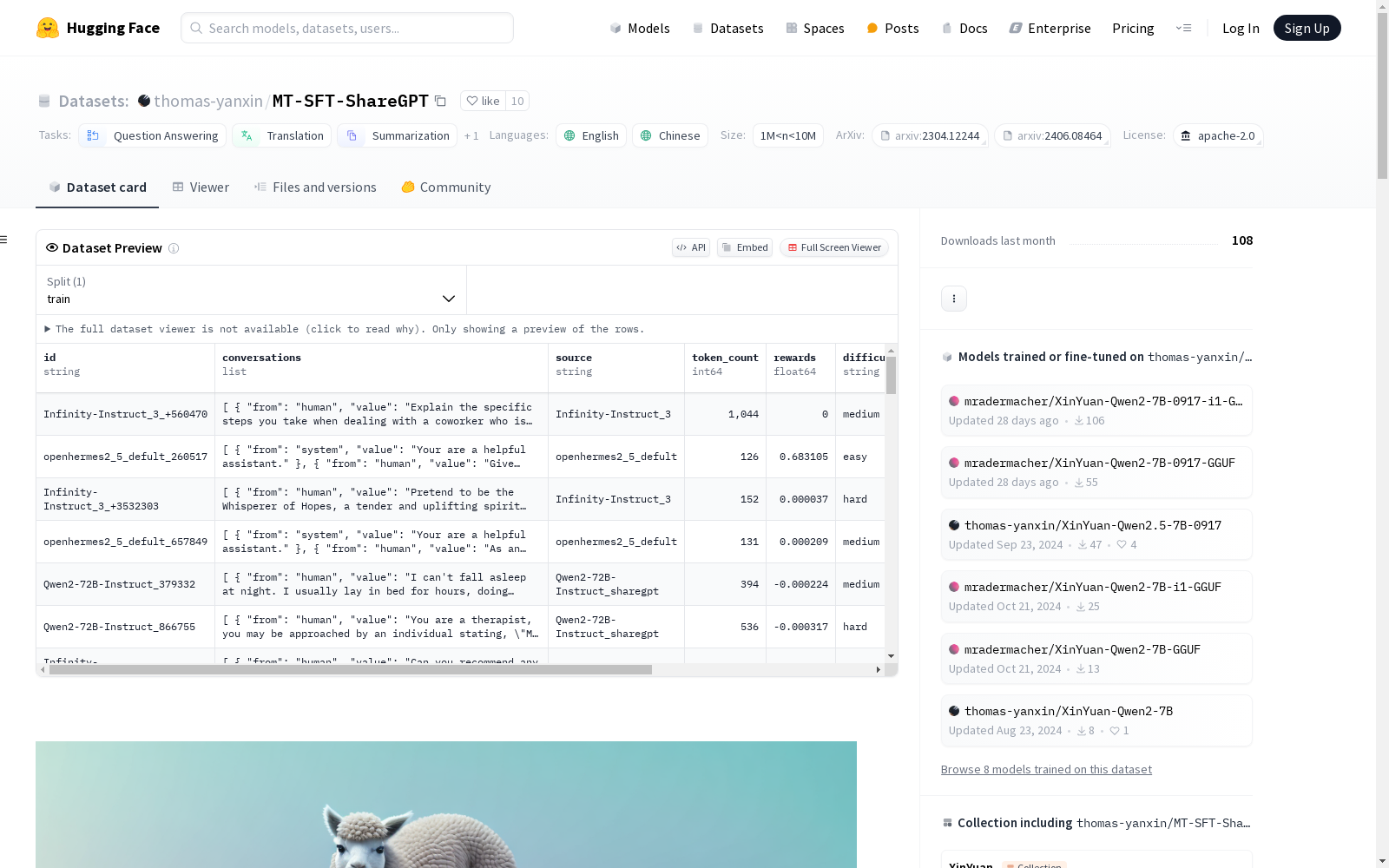

MT-SFT-ShareGPT|语言模型微调数据集|多语言处理数据集

收藏MT-SFT-ShareGPT 数据集概述

数据集信息

- 许可证:Apache-2.0

- 任务类别:

- 问答

- 翻译

- 摘要

- 文本分类

- 语言:

- 英语

- 中文

- 数据量:1M < n < 10M

数据集介绍

该数据集基于开源社区收集的数十个高质量开源数据集,经过清洗后,开放了一套用于微调大型语言模型指令的高质量数据集。数据集分为三大类:英语、中文和其他语言,并根据不同任务分为13个子类别。

- 总数据量:5,563,444

数据分类

英语 (EN)

| 分类 | 总数 | 信息寻求 | 推理 | 规划 | 编辑 | 编码 | 数学 | 角色扮演 | 数据分析 | 创意写作 | 寻求建议 | 头脑风暴 | 翻译 | 其他 |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 样本 | 3,895,845 | 571,468 | 326,777 | 76,477 | 44,163 | 926,521 | 1,339,602 | 10,636 | 19,597 | 62,150 | 17,197 | 1,821 | 3,357 | 496,079 |

| 词数 | 437.14 | 558 | 371 | 819 | 474 | 476 | 344 | 518 | 550 | 808 | 622 | 571 | 155 | 398 |

| 得分 | 0.29 | 0.28 | 0.24 | 0.32 | 0.22 | 0.28 | 0.30 | 0.23 | 0.19 | 0.39 | 0.46 | 0.36 | 0.51 | 0.27 |

| 轮次 | 1.21 | 1.78 | 1.16 | 1.84 | 1.43 | 1.01 | 1.02 | 1.81 | 1.25 | 1.84 | 1.79 | 1.63 | 1.10 | 1.17 |

中文 (CN)

| 分类 | 总数 | 信息寻求 | 推理 | 规划 | 编辑 | 编码 | 数学 | 角色扮演 | 数据分析 | 创意写作 | 寻求建议 | 头脑风暴 | 翻译 | 其他 |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 样本 | 1,635,223 | 558,187 | 237,906 | 45,327 | 94,058 | 87,689 | 109,694 | 37,695 | 16,578 | 175,587 | 30,656 | 4,620 | 0 | 237,226 |

| 词数 | 272.79 | 290.12 | 244.53 | 356.71 | 194.36 | 404 | 273.10 | 287 | 313 | 276 | 286 | 316 | 0 | 216.16 |

| 得分 | 0.35 | 0.34 | 0.36 | 0.25 | 0.42 | 0.77 | 0.24 | -0.01 | 0.12 | 0.36 | 0.380 | -0.03 | 0 | 0.33 |

| 轮次 | 1.20 | 1.09 | 1.05 | 1.14 | 1.08 | 1.17 | 1.11 | 1.10 | 1.14 | 1.91 | 1.09 | 2.87 | 0 | 1.17 |

其他语言 (Others)

| 分类 | 总数 | 信息寻求 | 推理 | 规划 | 编辑 | 编码 | 数学 | 角色扮演 | 数据分析 | 创意写作 | 寻求建议 | 头脑风暴 | 翻译 | 其他 |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 样本 | 32,376 | 10,504 | 2,310 | 663 | 895 | 3,081 | 2,050 | 147 | 118 | 1,041 | 483 | 38 | 0 | 11,046 |

| 词数 | 452.52 | 443.44 | 502.11 | 825.08 | 577.28 | 545.38 | 450.24 | 858.58 | 793.2 | 752.52 | 608.77 | 773.05 | 0 | 347.57 |

| 得分 | 0.12 | -0.08 | -0.1 | 0.2 | 0.16 | 0.17 | 0.04 | 0.11 | 0.11 | 0.24 | -0.1 | -0.26 | 0 | 0.36 |

| 轮次 | 1.30 | 1.31 | 1.35 | 1.62 | 1.48 | 1.25 | 1.08 | 1.47 | 1.47 | 1.66 | 1.57 | 1.92 | 0 | 1.23 |

数据处理

数据集使用以下模型进行处理:

- internlm/internlm2-reward

- sfairXC/FsfairX-LLaMA3-RM-v0.1

- Qwen/Qwen2-7B-Instruct

- meta-llama/Llama-Guard-3-8B

每个样本符合ShareGPT格式,这是社区中用于训练大型语言模型的流行规范。

Google Scholar

Google Scholar是一个学术搜索引擎,旨在检索学术文献、论文、书籍、摘要和文章等。它涵盖了广泛的学科领域,包括自然科学、社会科学、艺术和人文学科。用户可以通过关键词搜索、作者姓名、出版物名称等方式查找相关学术资源。

scholar.google.com 收录

UniProt

UniProt(Universal Protein Resource)是全球公认的蛋白质序列与功能信息权威数据库,由欧洲生物信息学研究所(EBI)、瑞士生物信息学研究所(SIB)和美国蛋白质信息资源中心(PIR)联合运营。该数据库以其广度和深度兼备的蛋白质信息资源闻名,整合了实验验证的高质量数据与大规模预测的自动注释内容,涵盖从分子序列、结构到功能的全面信息。UniProt核心包括注释详尽的UniProtKB知识库(分为人工校验的Swiss-Prot和自动生成的TrEMBL),以及支持高效序列聚类分析的UniRef和全局蛋白质序列归档的UniParc。其卓越的数据质量和多样化的检索工具,为基础研究和药物研发提供了无可替代的支持,成为生物学研究中不可或缺的资源。

www.uniprot.org 收录

CosyVoice 2

CosyVoice 2是由阿里巴巴集团开发的多语言语音合成数据集,旨在通过大规模多语言数据集训练,实现高质量的流式语音合成。数据集通过有限标量量化技术改进语音令牌的利用率,并结合预训练的大型语言模型作为骨干,支持流式和非流式合成。数据集的创建过程包括文本令牌化、监督语义语音令牌化、统一文本-语音语言模型和块感知流匹配模型等步骤。该数据集主要应用于语音合成领域,旨在解决高延迟和低自然度的问题,提供接近人类水平的语音合成质量。

arXiv 收录

TM-Senti

TM-Senti是由伦敦玛丽女王大学开发的一个大规模、远距离监督的Twitter情感数据集,包含超过1.84亿条推文,覆盖了超过七年的时间跨度。该数据集基于互联网档案馆的公开推文存档,可以完全重新构建,包括推文元数据且无缺失推文。数据集内容丰富,涵盖多种语言,主要用于情感分析和文本分类等任务。创建过程中,研究团队精心筛选了表情符号和表情,确保数据集的质量和多样性。该数据集的应用领域广泛,旨在解决社交媒体情感表达的长期变化问题,特别是在表情符号和表情使用上的趋势分析。

arXiv 收录

DALY

DALY数据集包含了全球疾病负担研究(Global Burden of Disease Study)中的伤残调整生命年(Disability-Adjusted Life Years, DALYs)数据。该数据集提供了不同国家和地区在不同年份的DALYs指标,用于衡量因疾病、伤害和早逝导致的健康损失。

ghdx.healthdata.org 收录