openbmb/UltraFeedback|自然语言处理数据集|偏好数据集数据集

收藏数据集概述

基本信息

- 许可证: MIT

- 任务类别: 文本生成

- 语言: 英语

- 数据集大小: 100K<n<1M

数据集描述

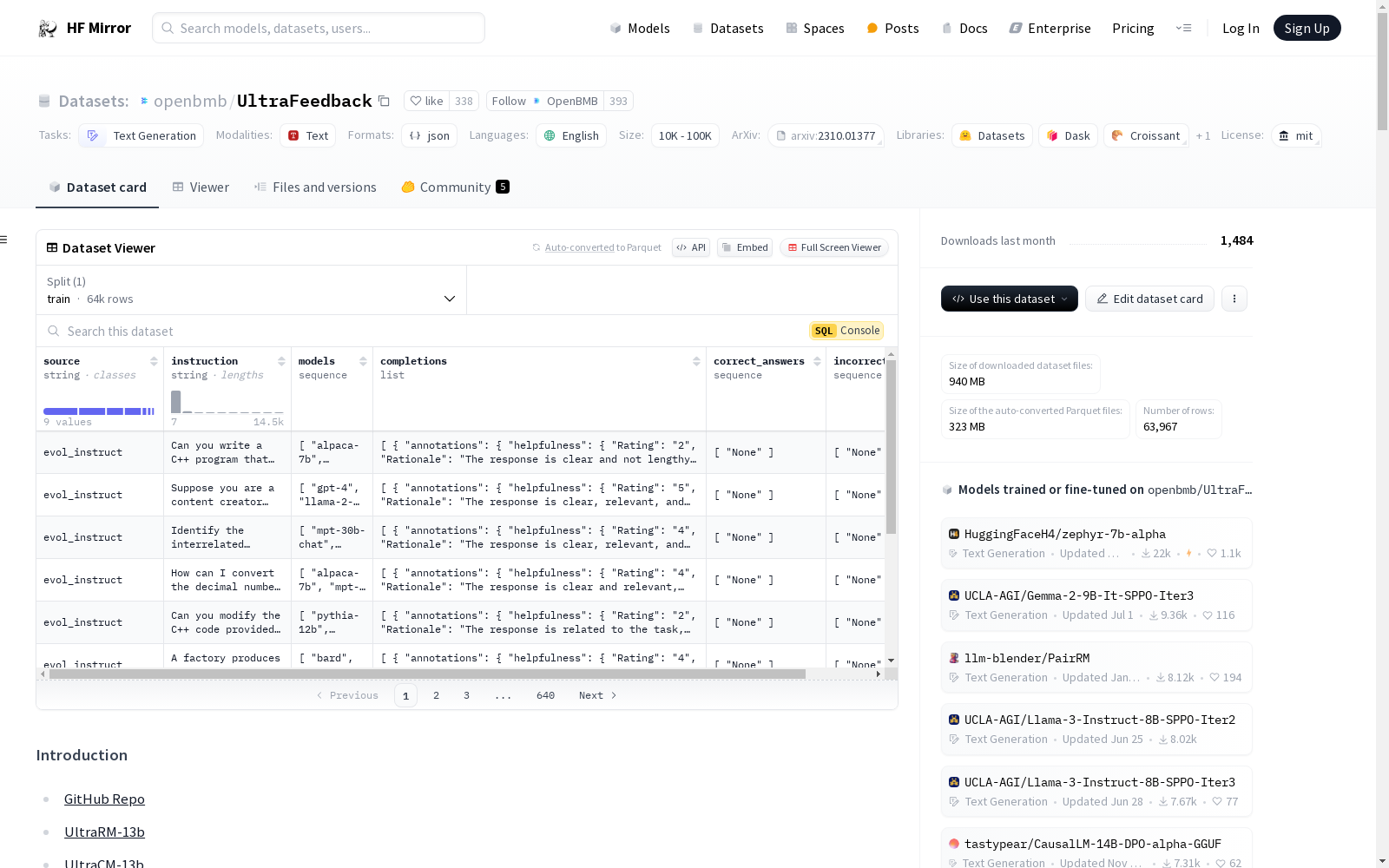

- 名称: UltraFeedback

- 用途: 用于训练强大的奖励模型和批评模型

- 数据来源: 收集了约64k来自多个资源的提示(包括UltraChat, ShareGPT, Evol-Instruct, TruthfulQA, FalseQA, FLAN),并使用这些提示查询多个大型语言模型(LLMs),生成4种不同响应,总计256k样本。

- 注释设计: 设计了包含4个不同方面的精细注释指令(遵循指令、真实性、诚实性和帮助性),并使用GPT-4进行样本注释。

数据集特征

- 规模: 包含64k提示,256k响应和380k高质量反馈。研究人员可以进一步构建约100万个比较对来训练他们的奖励模型。

- 多样性: 从多个来源收集提示,并查询多样化的开源和著名模型。为了增加多样性,选择了不同的基础模型(如LLaMA, Falcon, StarChat, MPT, GPT, Bard),并应用多种原则以不同方式完成指令。

- 高密度: 提供数值和文本反馈,并编写了精细的注释文档以帮助在所有维度上评价响应。

数据集构建

- 指令采样: 从6个公开可用的高质量数据集中采样63,967条指令。

- 模型采样: 选择不同级别、大小、架构和训练数据的基础模型,以防止奖励模型过度拟合特定文本风格或捕捉文本风格与奖励之间的虚假相关性。

- 原则采样: 定义了一组原则以明确对齐不同方面的模型行为。对于每个指令,随机选择4个模型完成指令,并为每个完成选择一个原则,添加到系统提示中以对齐模型行为。

数据集格式

- 数据集以JSON格式存储,包含以下字段:

- source: 指令来源的数据集

- id: 指令在源数据集中的ID

- instruction: 指令内容

- models: 完成指令的模型列表

- completions: 每个模型的响应及其相关信息(模型、原则、系统提示、响应、注释)

数据集示例

- 提供了一个用户查询及其由四个不同模型生成的响应示例,每个响应都附带了详细的注释,包括遵循指令、真实性、诚实性和帮助性的评分和理由。

数据集限制

- 尽管GPT-4可以提供大多数样本的良好对齐注释和文本反馈,但GPT-4也可能犯错并提供不准确的反馈。

引用信息

bib @misc{cui2023ultrafeedback, title={UltraFeedback: Boosting Language Models with High-quality Feedback}, author={Ganqu Cui and Lifan Yuan and Ning Ding and Guanming Yao and Wei Zhu and Yuan Ni and Guotong Xie and Zhiyuan Liu and Maosong Sun}, year={2023}, eprint={2310.01377}, archivePrefix={arXiv}, primaryClass={cs.CL} }

中国食物成分数据库

食物成分数据比较准确而详细地描述农作物、水产类、畜禽肉类等人类赖以生存的基本食物的品质和营养成分含量。它是一个重要的我国公共卫生数据和营养信息资源,是提供人类基本需求和基本社会保障的先决条件;也是一个国家制定相关法规标准、实施有关营养政策、开展食品贸易和进行营养健康教育的基础,兼具学术、经济、社会等多种价值。 本数据集收录了基于2002年食物成分表的1506条食物的31项营养成分(含胆固醇)数据,657条食物的18种氨基酸数据、441条食物的32种脂肪酸数据、130条食物的碘数据、114条食物的大豆异黄酮数据。

国家人口健康科学数据中心 收录

猫狗图像数据集

该数据集包含猫和狗的图像,每类各12500张。训练集和测试集分别包含10000张和2500张图像,用于模型的训练和评估。

github 收录

YOLO Drone Detection Dataset

为了促进无人机检测模型的开发和评估,我们引入了一个新颖且全面的数据集,专门为训练和测试无人机检测算法而设计。该数据集来源于Kaggle上的公开数据集,包含在各种环境和摄像机视角下捕获的多样化的带注释图像。数据集包括无人机实例以及其他常见对象,以实现强大的检测和分类。

github 收录

jpft/danbooru2023

Danbooru2023是一个大规模的动漫图像数据集,包含超过500万张由爱好者社区贡献并详细标注的图像。图像标签涵盖角色、场景、版权、艺术家等方面,平均每张图像有30个标签。该数据集可用于训练图像分类、多标签标注、角色检测、生成模型等多种计算机视觉任务。数据集基于danbooru2021构建,扩展至包含ID #6,857,737的图像,增加了超过180万张新图像,总大小约为8TB。图像以原始格式提供,分为1000个子目录,使用图像ID的模1000进行分桶,以避免文件系统性能问题。

hugging_face 收录

中国农村金融统计数据

该数据集包含了中国农村金融的统计信息,涵盖了农村金融机构的数量、贷款余额、存款余额、金融服务覆盖率等关键指标。数据按年度和地区分类,提供了详细的农村金融发展状况。

www.pbc.gov.cn 收录