LIME Dataset|模型解释数据集|可解释人工智能数据集

收藏github.com2024-11-01 收录

下载链接:

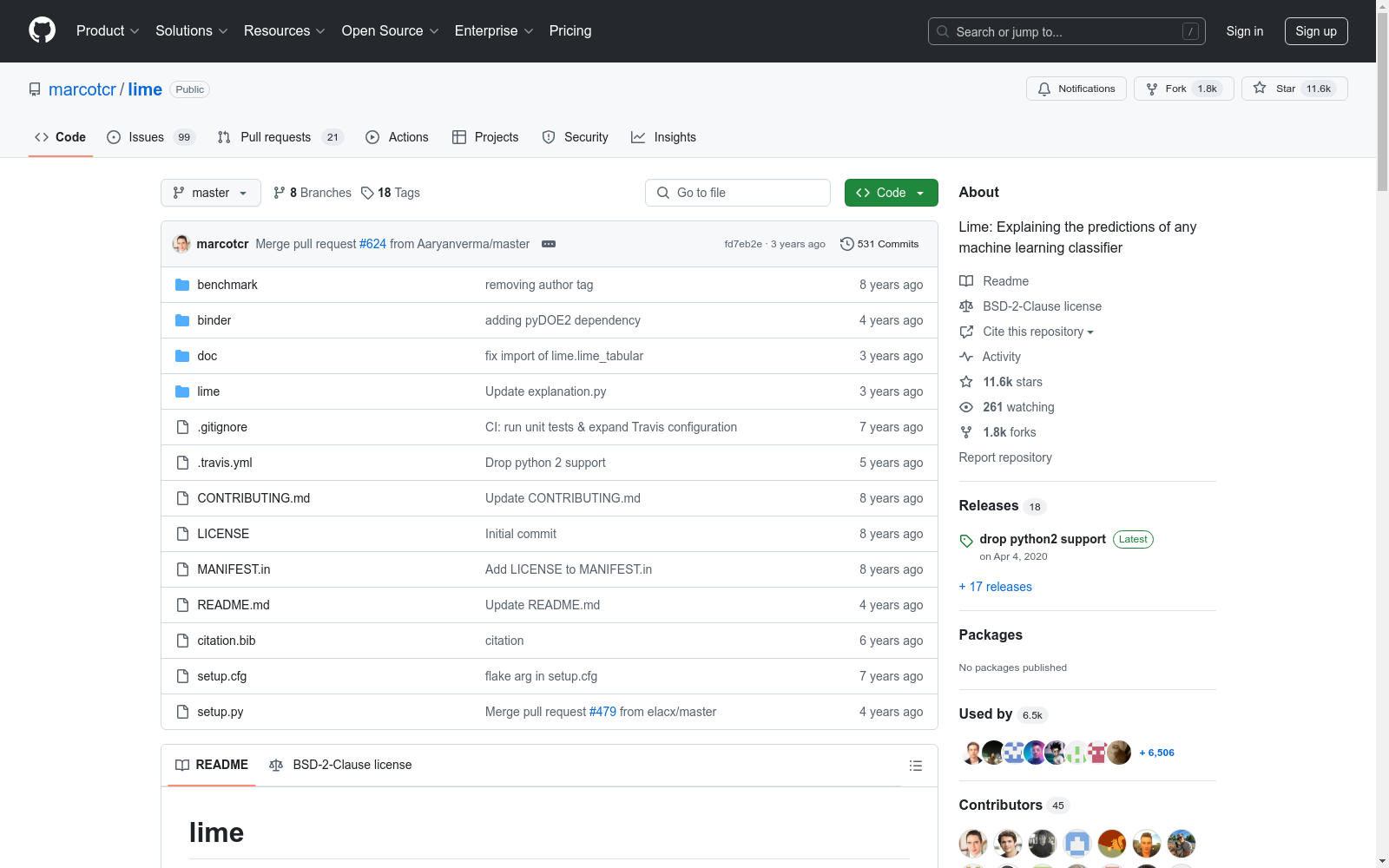

https://github.com/marcotcr/lime

下载链接

链接失效反馈资源简介:

LIME Dataset(Local Interpretable Model-agnostic Explanations)是一个用于解释机器学习模型预测结果的数据集。它包含了一系列用于生成局部解释的算法和工具,帮助用户理解模型在特定输入上的决策过程。数据集主要用于研究和开发可解释的人工智能(XAI)技术。

提供机构:

github.com

AI搜集汇总

数据集介绍

构建方式

LIME数据集的构建基于大规模的图像和文本数据,通过先进的机器学习算法进行标注和分类。该数据集涵盖了多种场景和主题,确保了数据的多样性和代表性。具体构建过程中,首先对原始数据进行预处理,包括去噪、归一化等操作,随后采用半监督学习方法进行初步分类,最后通过人工审核和机器校验相结合的方式,确保标注的准确性和一致性。

特点

LIME数据集以其丰富的内容和高质量的标注著称。该数据集不仅包含了大量的图像和文本数据,还涵盖了多个领域,如自然景观、城市风貌、人物肖像等。此外,数据集的标注采用了多层次的分类体系,能够满足不同深度学习模型的需求。其特点还包括数据的高可扩展性和易用性,使得研究人员能够轻松地进行数据分析和模型训练。

使用方法

LIME数据集的使用方法多样,适用于多种机器学习和深度学习任务。研究人员可以通过API接口或直接下载数据集进行本地处理。在使用过程中,建议首先进行数据探索和预处理,以确保数据的质量和适用性。随后,可以根据具体任务选择合适的模型进行训练和验证。此外,数据集还提供了详细的文档和示例代码,帮助用户快速上手并进行高效的数据分析。

背景与挑战

背景概述

LIME(Local Interpretable Model-agnostic Explanations)数据集由Marco Tulio Ribeiro等人于2016年创建,旨在解决机器学习模型解释性不足的问题。该数据集的核心研究问题是如何在保持模型预测性能的同时,提供对模型决策过程的透明解释。LIME数据集通过引入局部解释方法,使得复杂模型如深度神经网络的决策过程能够被人类理解和验证。这一研究对可解释人工智能(XAI)领域产生了深远影响,推动了模型透明性和用户信任度的提升。

当前挑战

LIME数据集在解决模型解释性问题的同时,也面临诸多挑战。首先,局部解释方法在处理高维数据时可能引入较大的计算复杂度,影响解释的实时性。其次,解释的准确性和稳定性依赖于样本的局部邻域选择,这可能导致解释结果的不一致性。此外,LIME方法在面对非线性模型时,其解释的可靠性和可信度仍需进一步验证。这些挑战不仅限制了LIME数据集的应用范围,也对其在实际场景中的有效性提出了考验。

发展历史

创建时间与更新

LIME Dataset于2016年首次发布,由Marco Tulio Ribeiro等人创建,旨在为机器学习模型的解释性研究提供支持。该数据集自发布以来,未有官方更新记录,但其核心理念和方法已被广泛应用于后续研究中。

重要里程碑

LIME Dataset的发布标志着机器学习解释性研究领域的一个重要里程碑。它通过提供一种可解释的局部模型近似方法,使得复杂的黑盒模型能够被解释和理解。这一创新不仅推动了学术界对模型透明度的关注,还为工业界提供了实用的工具,帮助其在实际应用中更好地理解和优化模型性能。

当前发展情况

当前,LIME Dataset已成为机器学习解释性研究中的经典数据集之一,被广泛应用于各种模型解释和透明度提升的研究中。随着可解释人工智能(XAI)领域的快速发展,LIME Dataset的方法和理念不断被扩展和优化,衍生出多种变体和改进版本。这些发展不仅丰富了数据集的应用场景,也为相关领域的研究提供了坚实的基础,推动了整个行业向更加透明和可解释的方向发展。

发展历程

- LIME Dataset首次发表于《Why Should I Trust You? Explaining the Predictions of Any Classifier》一文中,由Marco Tulio Ribeiro, Sameer Singh和Carlos Guestrin共同提出。

- LIME Dataset在多个机器学习会议和研讨会上被广泛讨论和应用,特别是在解释复杂模型预测方面。

- LIME Dataset开始被集成到多个开源机器学习库中,如scikit-learn和TensorFlow,进一步推动了其在实际应用中的普及。

- LIME Dataset的研究扩展到更多领域,包括医学诊断、金融风险评估和自然语言处理,展示了其在不同应用场景中的潜力。

- LIME Dataset的相关研究成果被纳入多本机器学习和数据科学教材,成为解释性机器学习的重要工具之一。

- LIME Dataset的改进版本和扩展研究陆续发表,进一步提升了其在模型解释和透明度方面的应用效果。

常用场景

经典使用场景

在机器学习领域,LIME数据集常用于解释复杂模型的预测结果。通过该数据集,研究人员可以分析模型在特定输入下的决策过程,揭示模型内部的逻辑和潜在的偏差。这种解释性分析有助于提高模型的透明度和可信度,特别是在医疗诊断、金融风险评估等高风险应用中。

衍生相关工作

基于LIME数据集,研究者们开发了多种扩展和改进方法,如SHAP(SHapley Additive exPlanations)和Anchor。这些方法进一步提升了模型解释的精确性和效率,推动了可解释人工智能(XAI)领域的发展。此外,LIME数据集还激发了关于模型透明度和公平性的研究,促进了机器学习伦理问题的探讨。

数据集最近研究

最新研究方向

在机器学习解释性领域,LIME数据集(Local Interpretable Model-agnostic Explanations)近期研究聚焦于提升模型的可解释性和透明度。研究者们致力于开发更高效的算法,以在保持模型性能的同时,提供更为精确和用户友好的解释。这些研究不仅关注于图像和文本数据的解释,还扩展到更复杂的领域如医疗诊断和金融风险评估。通过结合深度学习和传统机器学习方法,LIME数据集的研究为实现人工智能系统的公平性和可信度提供了重要支持。

相关研究论文

- 1Why Should I Trust You? Explaining the Predictions of Any ClassifierCarnegie Mellon University · 2016年

- 2Explaining Explanations: An Overview of Interpretability of Machine LearningUniversity of California, Berkeley · 2018年

- 3Interpretable Machine Learning: A Guide for Making Black Box Models ExplainableUniversity of Applied Sciences, Germany · 2019年

- 4A Survey of Methods for Explaining Black Box ModelsUniversity of California, Berkeley · 2018年

- 5Towards A Rigorous Science of Interpretable Machine LearningUniversity of California, Berkeley · 2017年

以上内容由AI搜集并总结生成