XLD|自动驾驶数据集|数据集数据集

收藏数据集概述

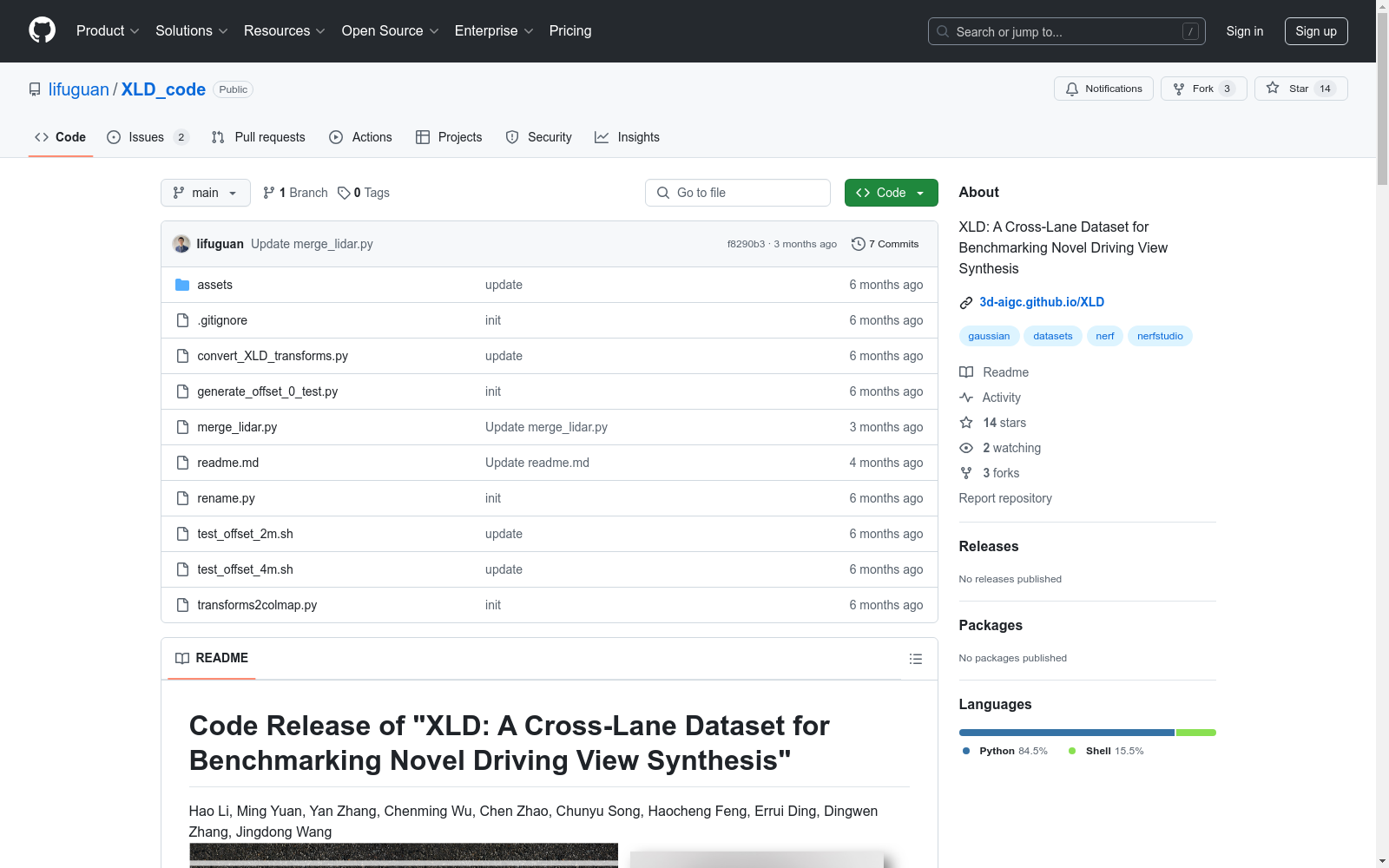

数据预处理

-

解压压缩文件(例如

carla_pic_0603_Town**.zip)。 -

从数据链接下载

intrinscis.zip和extrinsics.zip并解压。 -

将

intrinscis和extrinsics移动到相应的文件夹。 bash cp -r intrinsics data/carla_pic_0603_Town01 cp -r extrinsics data/carla_pic_0603_Town01 cp -r intrinsics data/carla_pic_0603_Town02 cp -r extrinsics data/carla_pic_0603_Town02 cp -r intrinsics data/carla_pic_0603_Town03 cp -r extrinsics data/carla_pic_0603_Town03 cp -r intrinsics data/carla_pic_0603_Town04 cp -r extrinsics data/carla_pic_0603_Town04 cp -r intrinsics data/carla_pic_0603_Town05 cp -r extrinsics data/carla_pic_0603_Town05 cp -r intrinsics data/carla_pic_0603_Town10 cp -r extrinsics data/carla_pic_0603_Town10 -

数据结构应如下所示:

generate_offset_0_test.py rename.py convert_XLD_transforms.py data ├── carlc_pic_0603_Town0N ├────────────|─────────── intrinsics ├────────────|─────────────── | ───────── 0.txt ├────────────|─────────────── | ───────── 1.txt ├────────────|─────────────── | ───────── 2.txt ├────────────|─────────── extrinsics ├────────────|─────────────── | ───────── 0.txt ├────────────|─────────────── | ───────── 1.txt ├────────────|─────────────── | ───────── 2.txt ├────────────|─────────── train_pic ├────────────|─────────────── | ───────── camera_extrinscs_00000N.json ├────────────|─────────────── | ───────── cameraX_0000N.png ├────────────|─────────────── | ───────── lidar_0000N.ply ├────────────|─────────── test_pic ├────────────|─────────────── | ───────── offset_left_0m (dont exist, run generate_offset_0_test.py) ├────────────|─────────────── | ─────────────── | ───────── camera_extrinscs_00000N.json ├────────────|─────────────── | ─────────────── | ───────── cameraX_0000N.png ├────────────|─────────────── | ─────────────── | ───────── lidar_0000N.ply ├────────────|─────────────── | ───────── offset_left_1m ├────────────|─────────────── | ─────────────── | ───────── camera_extrinscs_00000N.json ├────────────|─────────────── | ─────────────── | ───────── cameraX_0000N.png ├────────────|─────────────── | ─────────────── | ───────── lidar_0000N.ply ├────────────|─────────────── | ───────── offset_left_4m ├────────────|─────────────── | ─────────────── | ───────── camera_extrinscs_00000N.json ├────────────|─────────────── | ─────────────── | ───────── cameraX_0000N.png ├────────────|─────────────── | ─────────────── | ───────── lidar_0000N.ply

-

生成0m偏移的测试集: bash python generate_offset_0_test.py

-

将训练图像重命名为

train_**,测试图像重命名为eval_**,以符合NeRFStudio的格式: bash python rename.py -

生成

transforms.json用于NeRF和3D-GS: bash python convert_XLD_transforms.py -

注意,根据不同的相机设置和偏移设置,修改参数

num_cams、camera_list和offset_meters: python多相机,偏移=1m

generate_json_file(scene_path = data/carla_pic_0603_Town10, num_cams=3, camera_list=[1,0,2], offset_meters=1)

仅前向相机,偏移=1m

generate_json_file(scene_path = data/carla_pic_0603_Town10, num_cams=1, camera_list=[0], offset_meters=1)

模型训练

NeRFacto训练

bash cd carla_pic_0603_Town01_cam1

训练

CUDA_VISIBLE_DEVICES=1 ns-train nerfacto --pipeline.model.camera-optimizer.mode off --experiment-name nerfacto_offset_1m nerfstudio-data --eval-mode filename --data ./

评估

CUDA_VISIBLE_DEVICES=2 ns-eval --load-config outputs/nerfacto_offset_1m/nerfacto/2024-06-06_145158/config.yml --output-path ./nerfacto_offset_1/result.json --render-output-path ./nerfacto_offset_1

Instant-NGP训练

bash cd carla_pic_0603_Town01_cam1

训练

CUDA_VISIBLE_DEVICES=0 ns-train instant-ngp --experiment-name instant_ngp_offset_1 nerfstudio-data --eval-mode filename --data ./

评估

CUDA_VISIBLE_DEVICES=0 ns-eval --load-config outputs/instant_ngp_offset_1/instant-ngp/2024-06-06_165753/config.yml --output-path ./instant-ngp_offset_1m/result.json --render-output-path ./instant-ngp_offset_1m

高斯方法训练

Colmap格式数据预处理

运行Python脚本将 transforms.json 转换为3D-GS格式:

bash

python convert_XLD_transforms.py. # 生成 transforms.json

python merge_lidar.py # 合并3D LiDAR点云作为初始化

python transform2colmap.py # 将 transforms.json 转换为colmap格式

创建 images 文件夹并将训练和测试图像链接到其中:

bash

mkdir -p carla_pic_0603_Town01_cam3/images

cd carla_pic_0603_Town01_cam3/images

ln -s ../../data/carla_pic_0603_Town01/train_pic/train_camera0_00* ./ && ln -s ../../data/carla_pic_0603_Town01/train_pic/train_camera1_00* ./

ln -s ../../data/carla_pic_0603_Town01/train_pic/train_camera2_00* ./ && ln -s ../../data/carla_pic_0603_Town01/test_pic/offset_left_0m/eval_camera0_00* ./

cd ../../

GaussianPro & 3D-GS训练

bash cd carla_pic_0603_Town01_cam1 CUDA_VISIBLE_DEVICES=0 python train.py -s carla_pic_0603_Town01_cam1 -m ./carla_pic_0603_Town01_cam1/output --position_lr_init 0.000016 --scaling_lr 0.001 --percent_dense 0.0005 --port 1021 --eval

中国交通事故深度调查(CIDAS)数据集

交通事故深度调查数据通过采用科学系统方法现场调查中国道路上实际发生交通事故相关的道路环境、道路交通行为、车辆损坏、人员损伤信息,以探究碰撞事故中车损和人伤机理。目前已积累深度调查事故10000余例,单个案例信息包含人、车 、路和环境多维信息组成的3000多个字段。该数据集可作为深入分析中国道路交通事故工况特征,探索事故预防和损伤防护措施的关键数据源,为制定汽车安全法规和标准、完善汽车测评试验规程、

北方大数据交易中心 收录

PDT Dataset

PDT数据集是由山东计算机科学中心(国家超级计算济南中心)和齐鲁工业大学(山东省科学院)联合开发的无人机目标检测数据集,专门用于检测树木病虫害。该数据集包含高分辨率和低分辨率两种版本,共计5775张图像,涵盖了健康和受病虫害影响的松树图像。数据集的创建过程包括实地采集、数据预处理和人工标注,旨在为无人机在农业中的精准喷洒提供高精度的目标检测支持。PDT数据集的应用领域主要集中在农业无人机技术,旨在提高无人机在植物保护中的目标识别精度,解决传统检测模型在实际应用中的不足。

arXiv 收录

Global Water Quality Dataset

该数据集包含了全球多个地区的水质监测数据,涵盖了多种水质参数,如pH值、溶解氧、电导率、温度等。数据集旨在帮助研究人员和政策制定者了解全球水质的现状和变化趋势。

www.kaggle.com 收录

Awesome JSON Datasets

一个精选的无需认证的JSON数据集列表。

github 收录

THUCNews

THUCNews是根据新浪新闻RSS订阅频道2005~2011年间的历史数据筛选过滤生成,包含74万篇新闻文档(2.19 GB),均为UTF-8纯文本格式。本次比赛数据集在原始新浪新闻分类体系的基础上,重新整合划分出14个候选分类类别:财经、彩票、房产、股票、家居、教育、科技、社会、时尚、时政、体育、星座、游戏、娱乐。提供训练数据共832471条。

github 收录