CodeBERT|代码分析数据集|自然语言处理数据集

收藏

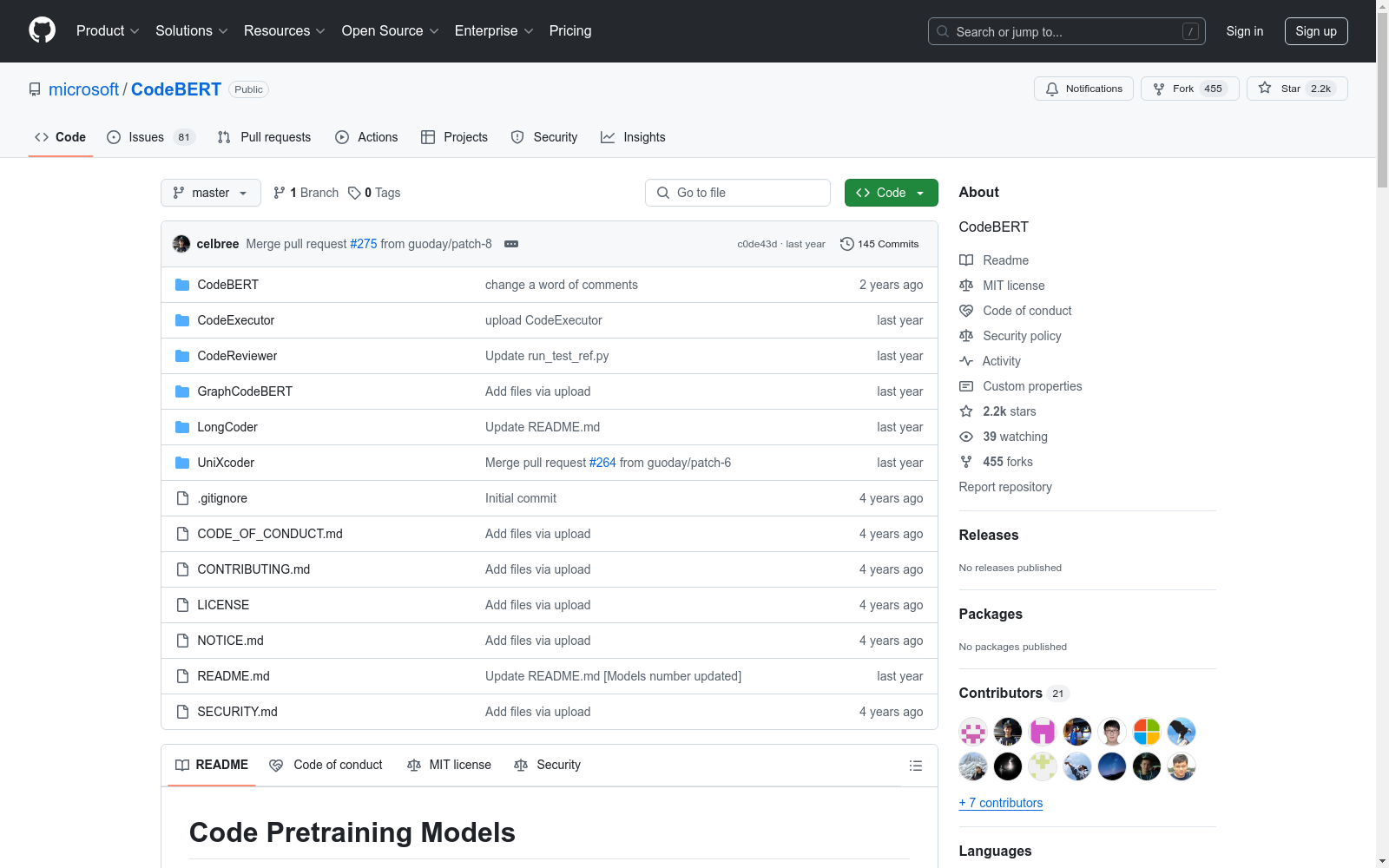

- CodeBERT首次发表,由微软研究院和北京大学联合开发,旨在为编程语言和自然语言提供统一的预训练模型。

- CodeBERT在多个编程语言理解任务中展示了其优越性能,包括代码搜索、代码摘要和代码翻译等。

- CodeBERT被应用于工业界,用于提升代码自动生成和代码补全的效率,进一步验证了其在实际应用中的有效性。

- 1CodeBERT: A Pre-Trained Model for Programming and Natural LanguagesMicrosoft Research · 2020年

- 2GraphCodeBERT: Pre-training Code Representations with Data FlowMicrosoft Research · 2021年

- 3Evaluating Large Language Models Trained on CodeOpenAI · 2021年

- 4CodeXGLUE: A Machine Learning Benchmark Dataset for Code Understanding and GenerationMicrosoft Research · 2021年

- 5CodeGen: An Open Large Language Model for Code with Multi-Turn Program SynthesisSalesforce Research · 2022年

RAVDESS

情感语音和歌曲 (RAVDESS) 的Ryerson视听数据库包含7,356个文件 (总大小: 24.8 GB)。该数据库包含24位专业演员 (12位女性,12位男性),以中性的北美口音发声两个词汇匹配的陈述。言语包括平静、快乐、悲伤、愤怒、恐惧、惊讶和厌恶的表情,歌曲则包含平静、快乐、悲伤、愤怒和恐惧的情绪。每个表达都是在两个情绪强度水平 (正常,强烈) 下产生的,另外还有一个中性表达。所有条件都有三种模态格式: 纯音频 (16位,48kHz .wav),音频-视频 (720p H.264,AAC 48kHz,.mp4) 和仅视频 (无声音)。注意,Actor_18没有歌曲文件。

OpenDataLab 收录

THUCNews

THUCNews是根据新浪新闻RSS订阅频道2005~2011年间的历史数据筛选过滤生成,包含74万篇新闻文档(2.19 GB),均为UTF-8纯文本格式。本次比赛数据集在原始新浪新闻分类体系的基础上,重新整合划分出14个候选分类类别:财经、彩票、房产、股票、家居、教育、科技、社会、时尚、时政、体育、星座、游戏、娱乐。提供训练数据共832471条。

github 收录

中国空气质量数据集(2014-2020年)

数据集中的空气质量数据类型包括PM2.5, PM10, SO2, NO2, O3, CO, AQI,包含了2014-2020年全国360个城市的逐日空气质量监测数据。监测数据来自中国环境监测总站的全国城市空气质量实时发布平台,每日更新。数据集的原始文件为CSV的文本记录,通过空间化处理生产出Shape格式的空间数据。数据集包括CSV格式和Shape格式两数数据格式。

国家地球系统科学数据中心 收录

Figshare

Figshare是一个在线数据共享平台,允许研究人员上传和共享各种类型的研究成果,包括数据集、论文、图像、视频等。它旨在促进科学研究的开放性和可重复性。

figshare.com 收录

FER2013

FER2013数据集是一个广泛用于面部表情识别领域的数据集,包含28,709个训练样本和7,178个测试样本。图像属性为48x48像素,标签包括愤怒、厌恶、恐惧、快乐、悲伤、惊讶和中性。

github 收录