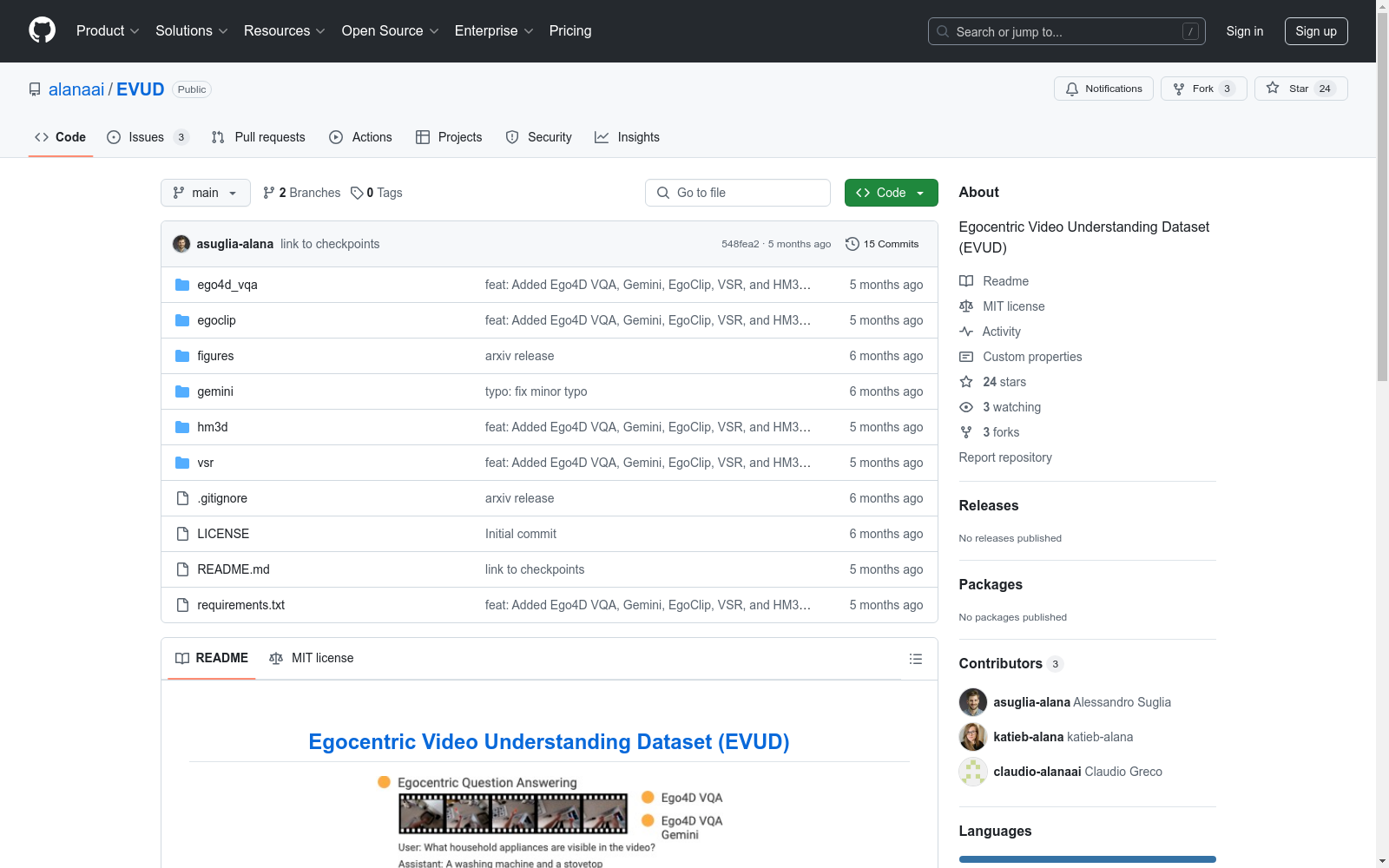

Egocentric Video Understanding Dataset (EVUD)|视频理解数据集|第一人称视角数据集

收藏Egocentric Video Understanding Dataset (EVUD)

概述

EVUD 是一个用于训练视觉语言模型(VLM)在以自我为中心的视频上进行视频字幕和问答任务的指令调优数据集。

最新动态

- AlanaVLM 论文已在 arXiv 上发布。

- 所有为此项目开发的检查点可在 Hugging Face 获取。

- EVUD 数据集可在 Hugging Face 获取。

数据生成

除了在 HuggingFace 上发布的生成数据外,我们还发布了所有用于重现我们数据生成管道的脚本:

生成的数据遵循 LLaVa JSON 格式。

GAOKAO-Bench

GAOKAO-Bench是由复旦大学计算机科学与技术学院创建的数据集,涵盖了2010至2022年间中国高考的所有科目题目,共计2811题。该数据集包含1781道客观题和1030道主观题,题型多样,包括单选、填空、改错、开放性问题等。数据集通过自动化脚本和人工标注将PDF格式的题目转换为JSON文件,数学公式则转换为LATEX格式。GAOKAO-Bench旨在为大型语言模型提供一个全面且贴近实际应用的评估基准,特别是在解决中国高考相关问题上的表现。

arXiv 收录

CatMeows

该数据集包含440个声音样本,由21只属于两个品种(缅因州库恩猫和欧洲短毛猫)的猫在三种不同情境下发出的喵声组成。这些情境包括刷毛、在陌生环境中隔离和等待食物。每个声音文件都遵循特定的命名约定,包含猫的唯一ID、品种、性别、猫主人的唯一ID、录音场次和发声计数。此外,还有一个额外的zip文件,包含被排除的录音(非喵声)和未剪辑的连续发声序列。

huggingface 收录

Cultural Dimensions Dataset

该数据集包含了霍夫斯泰德文化维度理论(Hofstede's Cultural Dimensions Theory)的相关数据,涵盖了多个国家和地区的文化维度评分,如权力距离、个人主义与集体主义、男性化与女性化、不确定性规避、长期取向与短期取向等。这些数据有助于研究不同文化背景下的行为模式和价值观。

geerthofstede.com 收录

中国空气质量数据集(2014-2020年)

数据集中的空气质量数据类型包括PM2.5, PM10, SO2, NO2, O3, CO, AQI,包含了2014-2020年全国360个城市的逐日空气质量监测数据。监测数据来自中国环境监测总站的全国城市空气质量实时发布平台,每日更新。数据集的原始文件为CSV的文本记录,通过空间化处理生产出Shape格式的空间数据。数据集包括CSV格式和Shape格式两数数据格式。

国家地球系统科学数据中心 收录

OECD - Education at a Glance

该数据集提供了关于教育系统在不同国家和地区的详细统计数据,包括教育支出、教育参与率、教育成果、教师资源等多个方面。数据涵盖了OECD成员国以及部分非成员国。

www.oecd.org 收录