有没有相关的论文或文献参考?

这个数据集是基于什么背景创建的?

数据集的作者是谁?

能帮我联系到这个数据集的作者吗?

这个数据集如何下载?

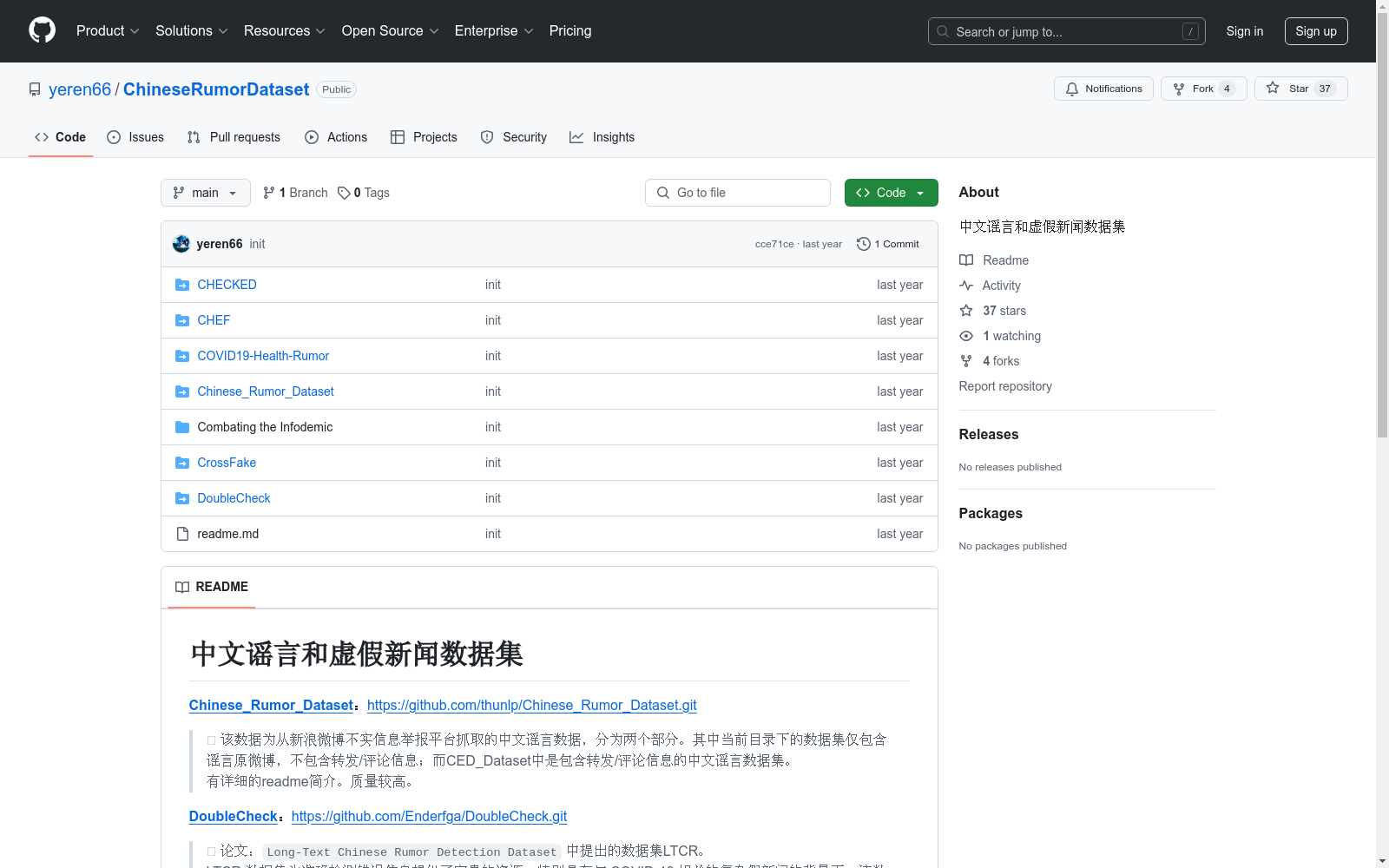

Long-Text Chinese Rumor Detection DatasetKnow it to Defeat it: Exploring Health Rumor Characteristics and Debunking Efforts on Chinese Social Media during COVID-19 CrisisCHECKED: Chinese COVID-19 Fake News DatasetCross-lingual COVID-19 Fake News DetectionCHEF: A Pilot Chinese Dataset for Evidence-Based Fact-CheckingCombating the Infodemic: A Chinese Infodemic Dataset for Misinformation Identification

中国空气质量数据集(2014-2020年)

数据集中的空气质量数据类型包括PM2.5, PM10, SO2, NO2, O3, CO, AQI,包含了2014-2020年全国360个城市的逐日空气质量监测数据。监测数据来自中国环境监测总站的全国城市空气质量实时发布平台,每日更新。数据集的原始文件为CSV的文本记录,通过空间化处理生产出Shape格式的空间数据。数据集包括CSV格式和Shape格式两数数据格式。

国家地球系统科学数据中心 收录

LUNA16

LUNA16(肺结节分析)数据集是用于肺分割的数据集。它由 1,186 个肺结节组成,在 888 次 CT 扫描中进行了注释。

OpenDataLab 收录

Fruits-360

一个高质量的水果图像数据集,包含多种水果的图像,如苹果、香蕉、樱桃等,总计42345张图片,分为训练集和验证集,共有64个水果类别。

github 收录

ChemBL

ChemBL是一个化学信息学数据库,包含大量生物活性数据,涵盖了药物发现和开发过程中的各种化学实体。数据集包括化合物的结构信息、生物活性数据、靶点信息等。

www.ebi.ac.uk 收录

HazyDet

HazyDet是由解放军工程大学等机构创建的一个大规模数据集,专门用于雾霾场景下的无人机视角物体检测。该数据集包含383,000个真实世界实例,收集自自然雾霾环境和正常场景中人工添加的雾霾效果,以模拟恶劣天气条件。数据集的创建过程结合了深度估计和大气散射模型,确保了数据的真实性和多样性。HazyDet主要应用于无人机在恶劣天气条件下的物体检测,旨在提高无人机在复杂环境中的感知能力。

arXiv 收录