COCO2014|计算机视觉数据集|图像标注数据集

收藏数据集概述

数据集名称

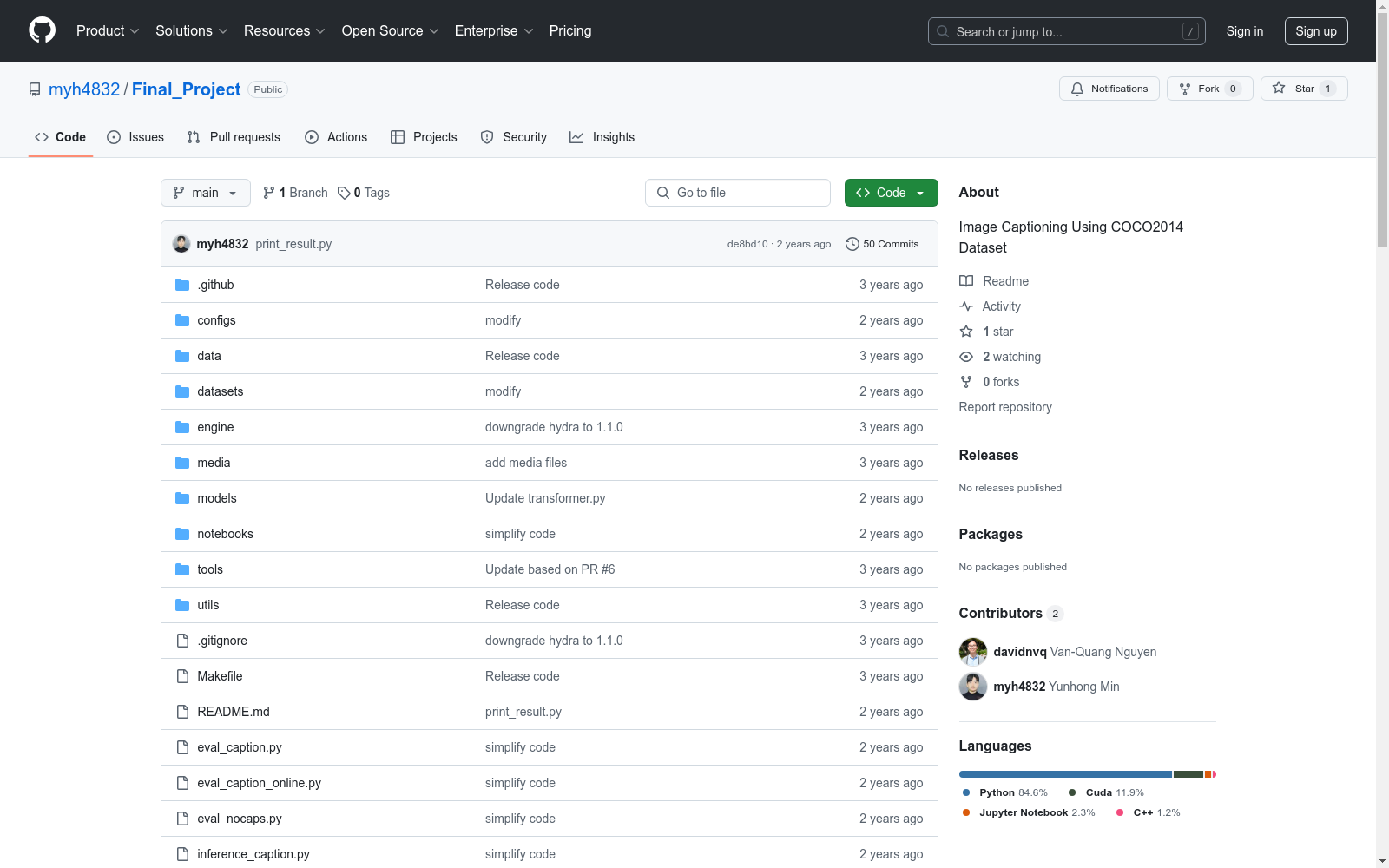

- GRIT: Faster and Better Image captioning Transformer (ECCV 2022)

预训练对象检测器

- 模型: Pretrained object detector (B) on 4 OD datasets

- 任务: Object Detection

- 检查点: GG Drive link

安装要求

- Python: >= 3.9

- CUDA: >= 11.3

- PyTorch: >= 1.12.0

- torchvision: >= 0.6.1

- 其他包: pycocotools, tensorboard, tqdm, h5py, nltk, einops, hydra, spacy, timm

数据准备

-

数据集: COCO 2014

-

目录结构:

path/to/coco_caption/ ├── annotations/ # annotation json files ├── train2014/ # train images ├── val2014/ # val images

训练

- 配置文件:

configs/caption/coco_config.yaml - 训练命令: shell export DATA_ROOT=path/to/coco_dataset python train_caption.py exp.name=caption_4ds model.detector.checkpoint=./detector_checkpoint_4ds.pth

最终打印结果

- 命令: shell python print_result.py

China Health and Retirement Longitudinal Study

中国健康与养老追踪调查(China Health and Retirement Longitudinal Study, CHARLS)是一个全国性的、具有代表性的老年人调查项目,旨在收集有关中国45岁及以上人群的健康、经济和社会状况的数据。该数据集包括个人和家庭层面的信息,涵盖健康状况、医疗使用、经济状况、社会支持等多个方面。

charls.pku.edu.cn 收录

学生课堂行为数据集 (SCB-dataset3)

学生课堂行为数据集(SCB-dataset3)由成都东软学院创建,包含5686张图像和45578个标签,重点关注六种行为:举手、阅读、写作、使用手机、低头和趴桌。数据集覆盖从幼儿园到大学的不同场景,通过YOLOv5、YOLOv7和YOLOv8算法评估,平均精度达到80.3%。该数据集旨在为学生行为检测研究提供坚实基础,解决教育领域中学生行为数据集的缺乏问题。

arXiv 收录

AIS数据集

该研究使用了多个公开的AIS数据集,这些数据集经过过滤、清理和统计分析。数据集涵盖了多种类型的船舶,并提供了关于船舶位置、速度和航向的关键信息。数据集包括来自19,185艘船舶的AIS消息,总计约6.4亿条记录。

github 收录

中国交通事故深度调查(CIDAS)数据集

交通事故深度调查数据通过采用科学系统方法现场调查中国道路上实际发生交通事故相关的道路环境、道路交通行为、车辆损坏、人员损伤信息,以探究碰撞事故中车损和人伤机理。目前已积累深度调查事故10000余例,单个案例信息包含人、车 、路和环境多维信息组成的3000多个字段。该数据集可作为深入分析中国道路交通事故工况特征,探索事故预防和损伤防护措施的关键数据源,为制定汽车安全法规和标准、完善汽车测评试验规程、

北方大数据交易中心 收录

Hang Seng Index

恒生指数(Hang Seng Index)是香港股市的主要股票市场指数,由恒生银行旗下的恒生指数有限公司编制。该指数涵盖了香港股票市场中最具代表性的50家上市公司,反映了香港股市的整体表现。

www.hsi.com.hk 收录