openwebtext2|自然语言处理数据集|文本数据集数据集

收藏huggingface2024-12-30 更新2024-12-31 收录

下载链接:

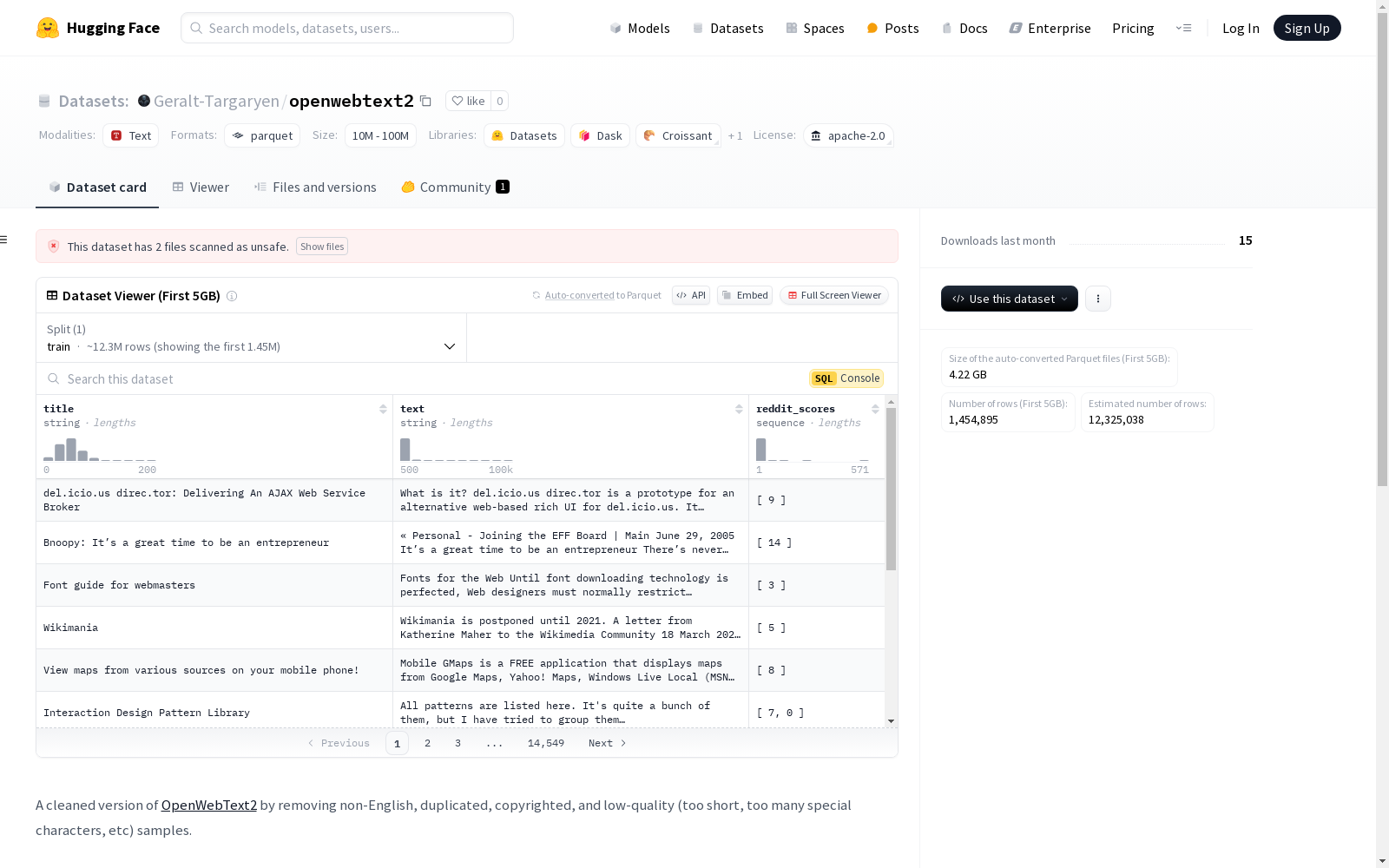

https://huggingface.co/datasets/Geralt-Targaryen/openwebtext2

下载链接

链接失效反馈资源简介:

这是一个OpenWebText2数据集的清理版本,移除了非英语、重复、受版权保护以及低质量(如过短、包含过多特殊字符等)的样本。数据集还针对多个基准测试进行了去污染处理,确保与这些测试集的n-gram重叠被移除。数据集包含13,187,538个样本,下载的parquet文件大小为34G。

创建时间:

2024-12-18

AI搜集汇总

数据集介绍

构建方式

openwebtext2数据集是基于OpenWebText2的清理版本,旨在提升数据质量。构建过程中,移除了非英语、重复、受版权保护以及低质量的样本,如过短或包含过多特殊字符的文本。此外,数据集还通过n-gram重叠方法进行了去污染处理,确保其与多个基准测试集(如GLUE、SIQA、PIQA等)的独立性。最终,数据集共移除了4,096个文档,保留了13,187,538个高质量样本。

特点

openwebtext2数据集以其高质量和广泛适用性著称。其样本经过严格筛选,确保了语言的纯净性和内容的多样性。数据集涵盖了多种基准测试集的去污染处理,使其在自然语言处理任务中具有更高的可靠性和实用性。此外,数据集的规模庞大,包含超过1300万个样本,为模型训练提供了丰富的资源。下载的parquet文件大小为34G,便于高效存储和处理。

使用方法

openwebtext2数据集适用于多种自然语言处理任务,如文本分类、语言模型训练等。用户可以通过HuggingFace平台轻松下载和使用该数据集。下载后,数据以parquet文件格式存储,便于高效读取和处理。在使用过程中,建议结合具体任务需求,对数据进行进一步预处理或特征提取,以充分发挥其潜力。数据集的去污染处理使其在基准测试中表现优异,适合用于模型评估和对比研究。

背景与挑战

背景概述

OpenWebText2数据集作为大规模文本数据集的代表,旨在为自然语言处理领域提供高质量的语料资源。该数据集由多个研究机构共同构建,主要基于OpenWebText的原始数据,经过严格的清洗和去重处理,剔除非英语、重复、受版权保护以及低质量的样本。其核心研究问题在于如何通过大规模、多样化的文本数据,提升语言模型的泛化能力和理解能力。自发布以来,OpenWebText2在预训练语言模型、文本生成、问答系统等多个领域展现了重要的影响力,成为相关研究的重要基准之一。

当前挑战

OpenWebText2数据集在构建过程中面临多重挑战。首先,数据清洗的复杂性极高,需要精确识别并移除非英语、重复、受版权保护以及低质量的样本,以确保数据集的纯净性和可用性。其次,数据去污染过程涉及与多个基准数据集(如GLUE、MMLU、MATH等)的n-gram重叠检测,以避免数据泄露对模型评估的干扰。此外,数据规模庞大(超过1300万样本),对存储、处理和分析提出了极高的技术要求。这些挑战不仅考验了数据集的构建方法,也为后续研究提供了重要的技术参考。

常用场景

经典使用场景

OpenWebText2数据集在自然语言处理领域中被广泛用于训练和评估大规模语言模型。其经过清洗的高质量文本数据为研究者提供了丰富的语料库,特别适用于预训练模型如GPT系列,以提升模型在多种下游任务中的表现。

实际应用

在实际应用中,OpenWebText2数据集被用于开发智能对话系统、文本生成工具以及信息检索系统。其多样化的文本内容为这些应用提供了丰富的语言模式,使其能够更好地理解和生成自然语言,满足用户需求。

衍生相关工作

基于OpenWebText2数据集,研究者们开发了多种先进的自然语言处理模型,如GPT-3和BERT的变体。这些模型在文本分类、机器翻译、问答系统等任务中取得了显著成果,推动了自然语言处理技术的快速发展。

以上内容由AI搜集并总结生成