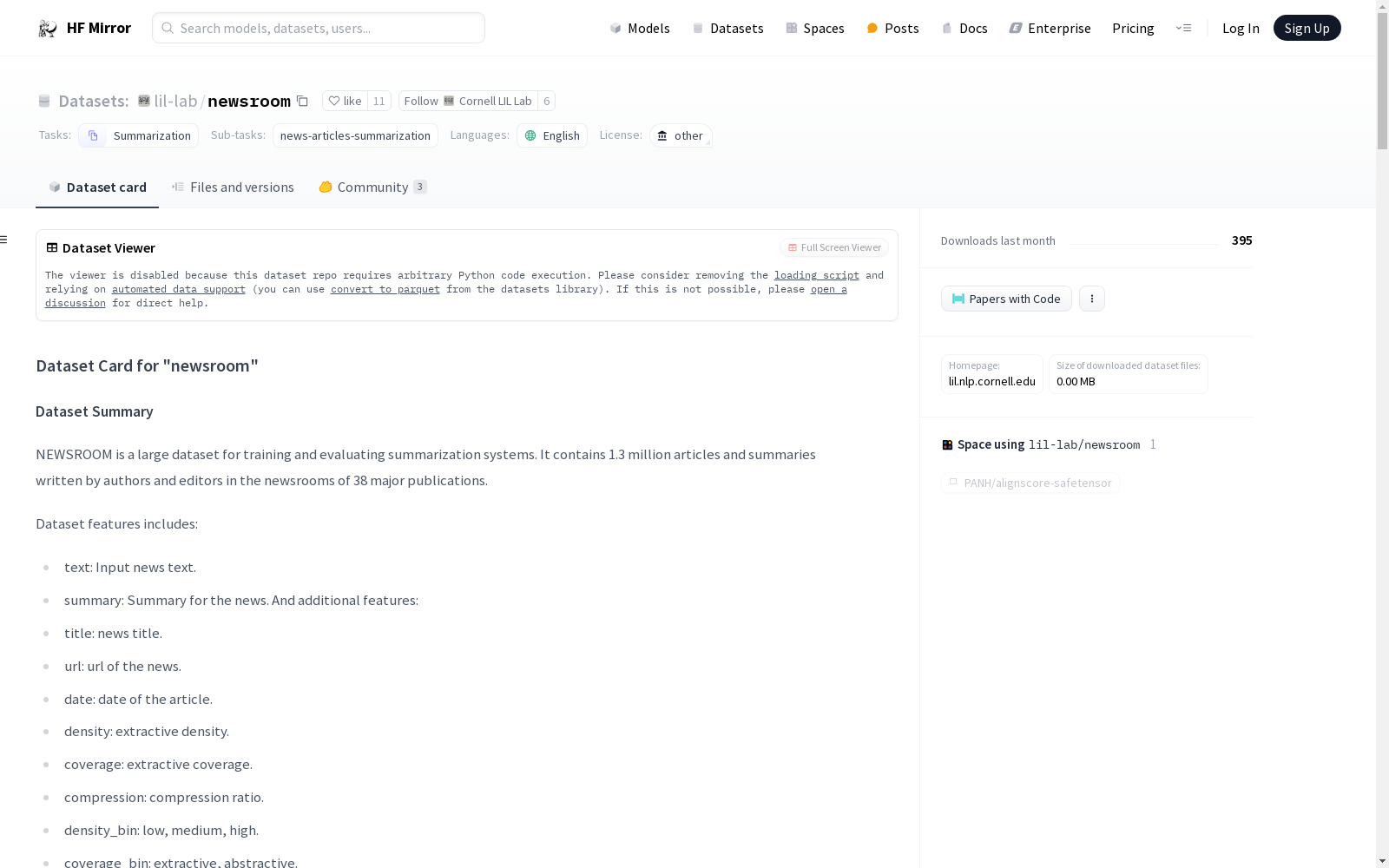

lil-lab/newsroom|新闻摘要数据集|文本生成数据集

收藏数据集概述

名称: CORNELL NEWSROOM

语言: 英语 (en)

许可证: 其他

多语言性: 单语

任务类别: 摘要生成

任务ID: news-articles-summarization

数据集大小: 未知

源数据: 原始

数据集信息:

-

特征:

text: 新闻文本,类型为stringsummary: 新闻摘要,类型为stringtitle: 新闻标题,类型为stringurl: 新闻URL,类型为stringdate: 新闻日期,类型为stringdensity_bin: 密度分类,类型为stringcoverage_bin: 覆盖分类,类型为stringcompression_bin: 压缩分类,类型为stringdensity: 提取密度,类型为float32coverage: 提取覆盖,类型为float32compression: 压缩比率,类型为float32

-

数据分割:

train: 995041个样本,4357506078字节validation: 108837个样本,473206951字节test: 108862个样本,472446866字节

-

数据集大小: 5.30 GB

数据集创建

注释创建者: 专家生成

语言创建者: 专家生成

许可证信息: 该数据集的使用协议是与Cornell Newsroom Summaries Team的合法协议,仅用于非商业研究和教育目的。通过下载或使用数据集,研究者同意遵守此协议的条款和条件。

引用信息:

@inproceedings{N18-1065, author = {Grusky, Max and Naaman, Mor and Artzi, Yoav}, title = {NEWSROOM: A Dataset of 1.3 Million Summaries with Diverse Extractive Strategies}, booktitle = {Proceedings of the 2018 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies}, year = {2018}, }

贡献者: 感谢@lewtun, @patrickvonplaten, @yoavartzi, @thomwolf添加此数据集。

中国农村金融统计数据

该数据集包含了中国农村金融的统计信息,涵盖了农村金融机构的数量、贷款余额、存款余额、金融服务覆盖率等关键指标。数据按年度和地区分类,提供了详细的农村金融发展状况。

www.pbc.gov.cn 收录

学生课堂行为数据集 (SCB-dataset3)

学生课堂行为数据集(SCB-dataset3)由成都东软学院创建,包含5686张图像和45578个标签,重点关注六种行为:举手、阅读、写作、使用手机、低头和趴桌。数据集覆盖从幼儿园到大学的不同场景,通过YOLOv5、YOLOv7和YOLOv8算法评估,平均精度达到80.3%。该数据集旨在为学生行为检测研究提供坚实基础,解决教育领域中学生行为数据集的缺乏问题。

arXiv 收录

Solar Radiation Data

该数据集包含全球多个地点的太阳辐射数据,涵盖了不同时间段和气象条件下的辐射强度。数据包括直接辐射、散射辐射和总辐射等指标,适用于太阳能资源评估和气候研究。

www.nrel.gov 收录

UAVDT

UAVDT是一个用于目标检测任务的数据集。

github 收录

LibriSpeech

LibriSpeech 是一个大约 1000 小时的 16kHz 英语朗读语音语料库,由 Vassil Panayotov 在 Daniel Povey 的协助下编写。数据来自 LibriVox 项目的已读有声读物,并经过仔细分割和对齐。

OpenDataLab 收录