百度百科 500 万数据集|自然语言处理数据集|机器学习数据集

收藏数据集概述

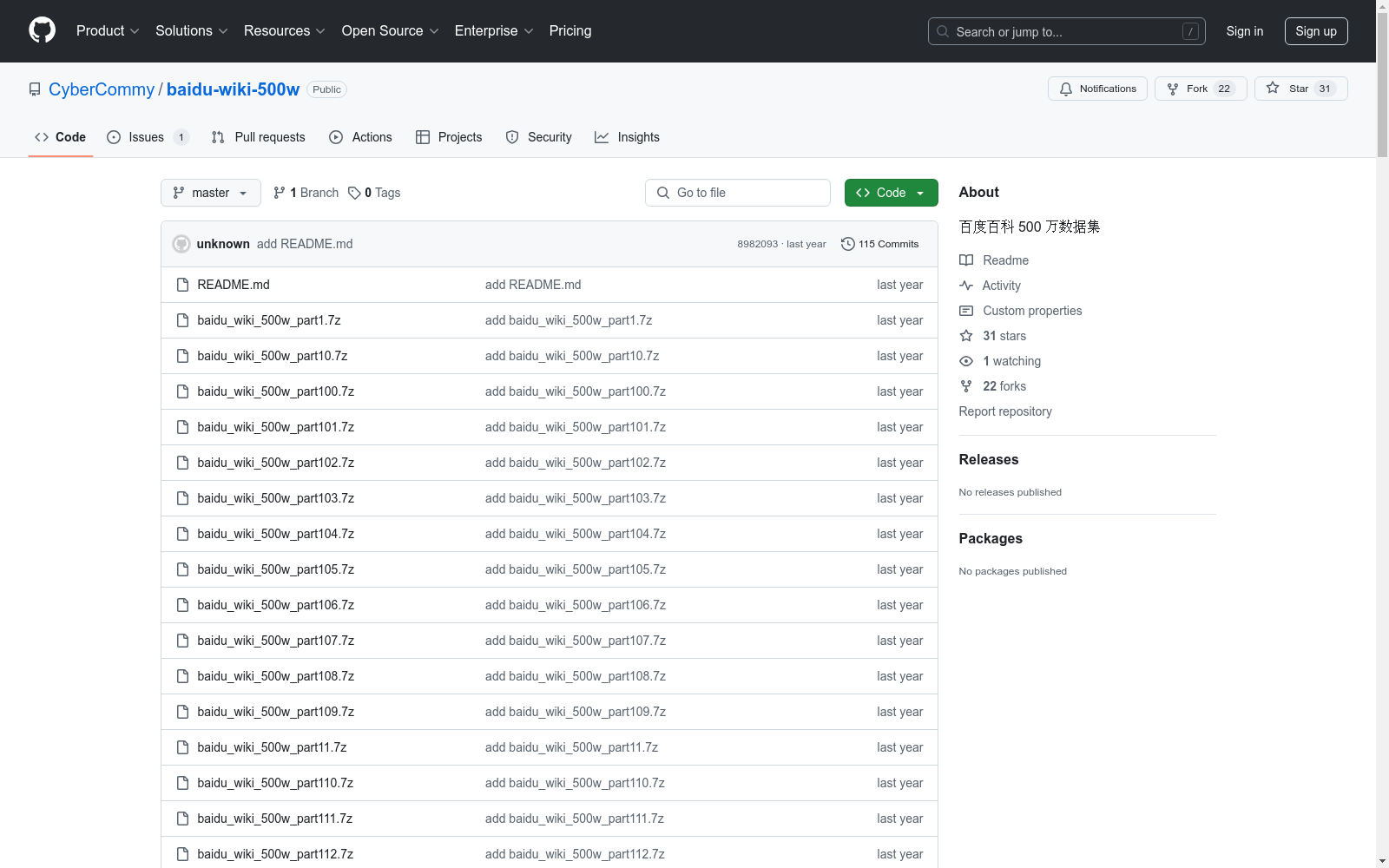

数据集名称

百度百科 500 万数据集

数据集内容

数据集包含大量中文文本数据,主要来源于百度百科,涵盖多个主题和领域。每个数据条目包含以下信息:

- 标题:数据条目的主题名称。

- 摘要:对主题的简要描述。

- 内容:详细介绍主题的各个方面,包括多个小节,每个小节有标题和内容。

- 标签:描述数据条目所属的类别或领域。

- URL:指向百度百科原文的链接。

数据集示例

以下是数据集中的一个示例条目内容:

- 标题:红色食品

- 摘要:红色食品是指食品为红色、橙红色或棕红色的食品。科学家认为,多吃些红色食品可预防感冒。

- 内容:详细介绍了红色食品的定义、作用、与感冒的关系、与红肉的关系以及好处。

- 标签:饮食, 食品, 食疗, 科学, 健康, 食品类型

- URL:http://baike.baidu.com/view/0010.htm

数据集文件信息

- 文件名:baidu_wiki_500w_part1.7z

- 压缩格式:7z

- 压缩后大小:48579917字节(约47MiB)

- 解压后大小:175163873字节

- 解压方法:使用7-Zip软件解压

数据集文件内容格式

- 文件类型:JSONL(JSON Lines)格式

- 编码:UTF-8

Global Solar Dataset

在快速扩展的太阳能领域,找到全面的国家规模光伏(PV)数据集可能具有挑战性。资源通常分散在多个网站和API中,质量和可访问性差异显著。该仓库旨在通过将这些数据集的位置集中到一个位置来简化对这些数据集的访问,从而支持研究并促进新旧市场中太阳能预测模型的开发。

github 收录

中国光伏电站空间分布ChinaPV数据集(2015,2020年)

该数据集是中国光伏电站空间分布ChinaPV数据,数据时间为2015和2020年。该数据集以Landsat-8卫星影像为数据源,处理方法是基于GEE遥感云计算平台,运用随机森林分类模型对2020年中国光伏电站进行遥感提取,后经过形态学运算,灯光数据滤除,轮廓细化及目视解译等后处理操作生成。该数据详细描述了中国区域内每个光伏电站的面积和地理位置信息,反映了中国地区光伏电站发展现状及其地域分布规律,以ESRI Shapefile格式存储。

国家地球系统科学数据中心 收录

中国空气质量数据集(2014-2020年)

数据集中的空气质量数据类型包括PM2.5, PM10, SO2, NO2, O3, CO, AQI,包含了2014-2020年全国360个城市的逐日空气质量监测数据。监测数据来自中国环境监测总站的全国城市空气质量实时发布平台,每日更新。数据集的原始文件为CSV的文本记录,通过空间化处理生产出Shape格式的空间数据。数据集包括CSV格式和Shape格式两数数据格式。

国家地球系统科学数据中心 收录

Thyroid Disease Data

该数据集包含13个临床病理特征,旨在预测分化良好的甲状腺癌的复发。数据集收集了15年间的数据,每位患者至少被跟踪了10年。

github 收录

LinkedIn Salary Insights Dataset

LinkedIn Salary Insights Dataset 提供了全球范围内的薪资数据,包括不同职位、行业、地理位置和经验水平的薪资信息。该数据集旨在帮助用户了解薪资趋势和市场行情,支持职业规划和薪资谈判。

www.linkedin.com 收录