SummEval, Newsroom|文本摘要数据集|自动评估数据集

收藏数据集概述

数据集内容

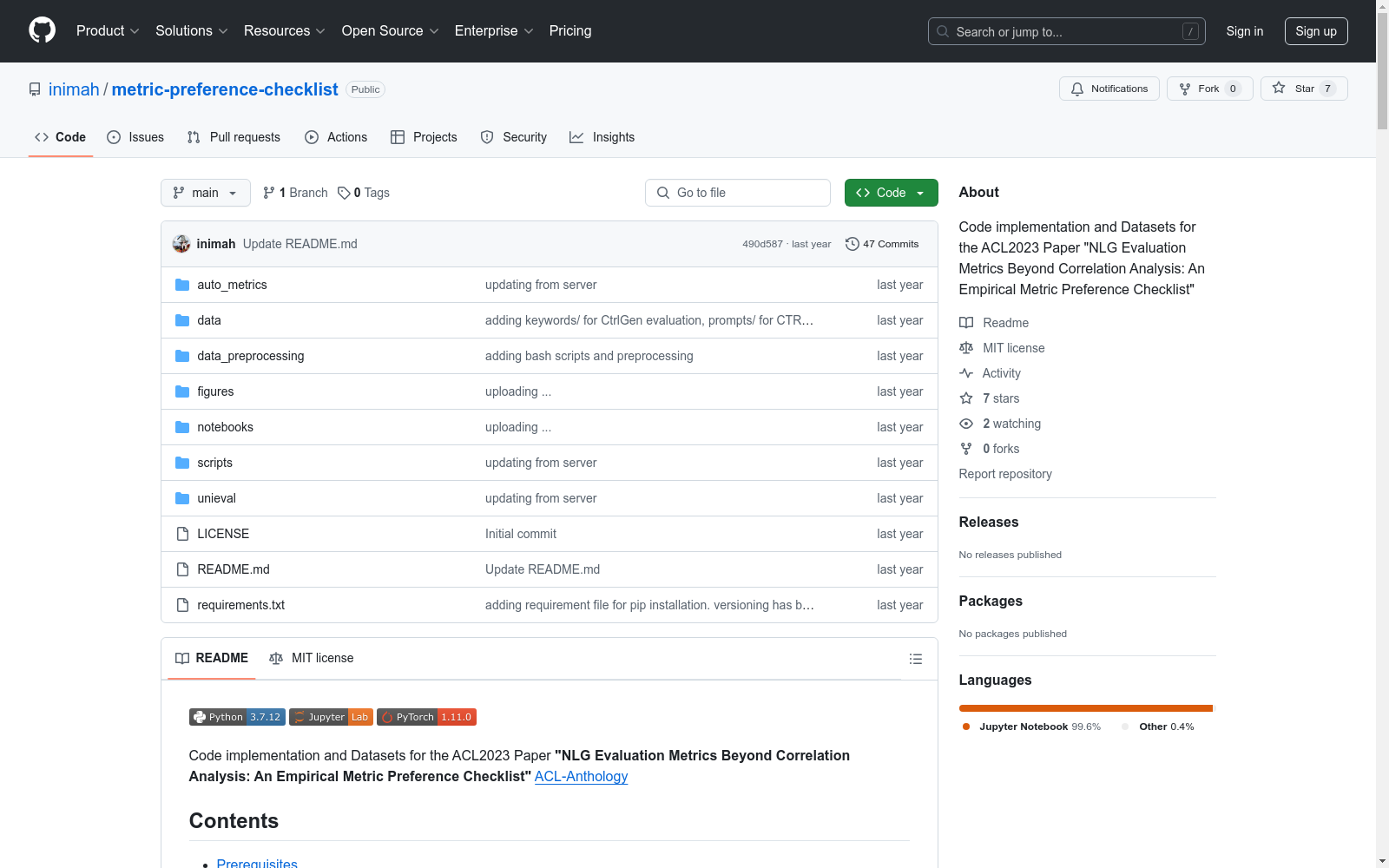

本数据集包含多个子数据集,主要用于自然语言生成(NLG)的评估,包括文本摘要、对话响应生成和受控生成等任务。每个子数据集都提供了详细的数据结构和评估指标。

文本摘要

-

SummEval (Fabbri et al., 2021)

- 包含人类和自动评估的分数,如Coherence、Consistency、Fluency、Relevance等。

- 提供11个参考文献。

-

Newsroom (Grusky et al., 2018)

- 无参考文献,使用源文本作为参考。

- 包含CoherenceRating、InformativenessRating、FluencyRating、RelevanceRating等评分。

对话响应生成

-

USR-Topical Chat (Mehri and Eskenazi, 2020)

- 包含Understandable、Natural、MaintainsContext、Engaging等评分。

-

USR Persona Chat (Mehri and Eskenazi, 2020)

- 包含Understandable、Natural、MaintainsContext、Engaging等评分。

受控生成

-

UBER-PPLM (Dathathri et al., 2020)

- 无参考文献。

- 包含Fluency、Relevance等评分。

-

CTRL (Keskar et al., 2019)

- 无参考文献。

- 包含Fluency、Relevance等评分。

-

CTRL-Eval (Ke et al., 2022)

- 无参考文献。

- 包含Coherence、Consistency、Relevance等评分。

评估指标

本数据集支持多种评估指标,包括但不限于:

- CTC (Deng et al., 2021)

- CTRLEval (Ke et al., 2022)

- UniEval (Zhong et al., 2022)

这些指标用于评估系统输出与人类偏好的对齐程度,以及系统在不同NLG任务中的表现。

使用方法

数据集提供了快速启动指南,包括数据结构化、人类对齐的评估指标、转移实验、方面级评估、系统级评估和成对比较等步骤。此外,还提供了运行自动评估指标的脚本示例。

计算基础设施

数据集的计算基础设施包括GPU和CPU,运行在Ubuntu 16.04.7 LTS操作系统上。

引用信息

本数据集的引用信息如下:

BibTeX @inproceedings{nimah-etal-2023-nlg, title = "{NLG} Evaluation Metrics Beyond Correlation Analysis: An Empirical Metric Preference Checklist", author = "Nimah, Iftitahu and Fang, Meng and Menkovski, Vlado and Pechenizkiy, Mykola", booktitle = "Proceedings of the 61st Annual Meeting of the Association for Computational Linguistics (Volume 1: Long Papers)", publisher = "Association for Computational Linguistics", url = "https://aclanthology.org/2023.acl-long.69", doi = "10.18653/v1/2023.acl-long.69", pages = "1240--1266" }