Zyda - 包含1.3万亿Token的开源预训练数据集|语言模型数据集|预训练数据集数据集

收藏数据集概述

基本信息

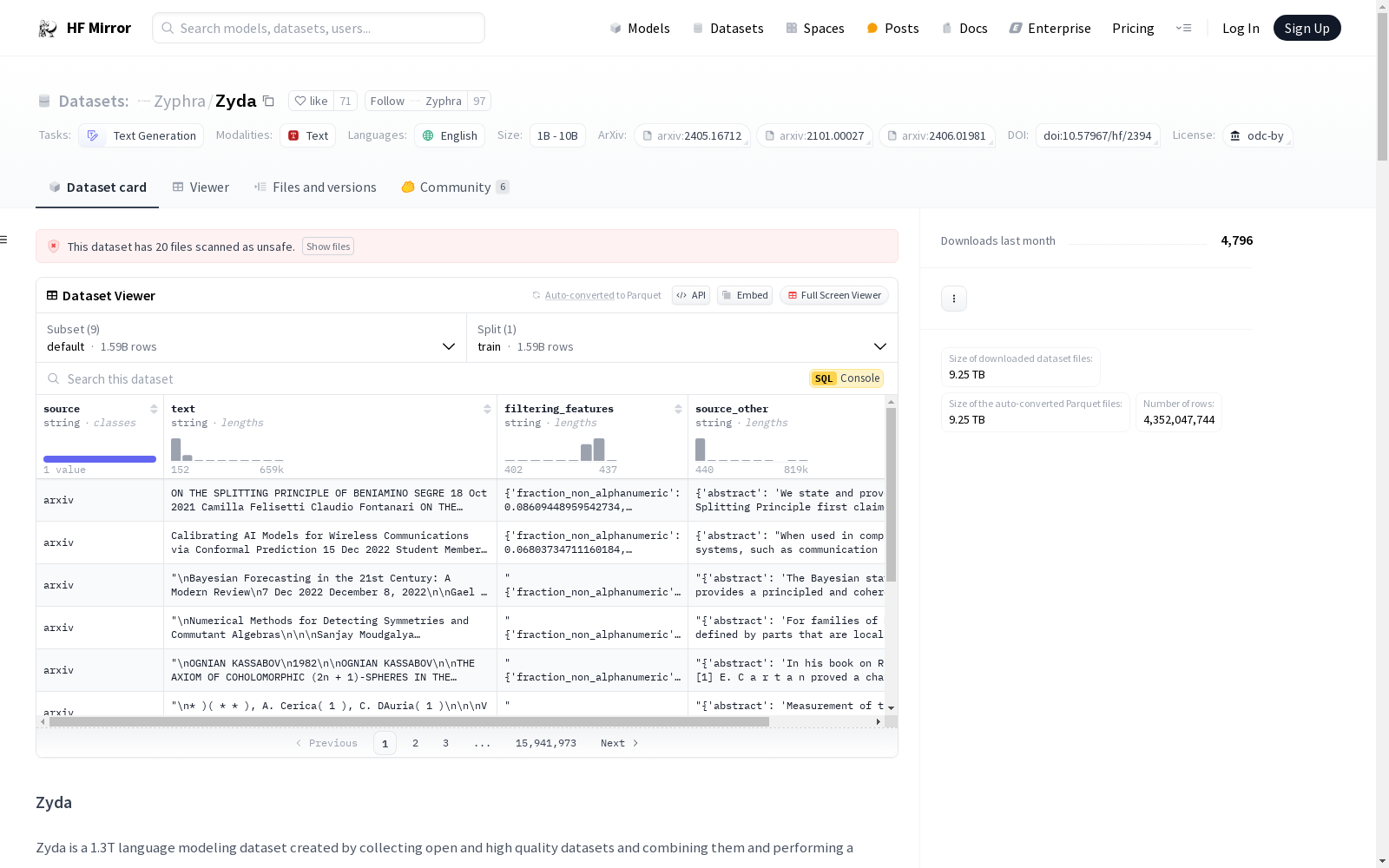

- 数据集名称: Zyda

- 许可证: Open Data Commons License (ODC-BY)

- 任务类别: 文本生成

- 语言: 英语

- 大小类别: 大于1TB

数据集结构

- 配置名称: default

- 分割:

- 名称: train

- 样本数量: 1,594,197,267

配置详情

- 默认配置:

- 数据文件路径: data///*

- 其他配置:

- zyda_no_starcoder: data/zyda_no_starcoder//

- zyda_arxiv_only: data/zyda_no_starcoder/zyda_arxiv/*

- zyda_c4-en_only: data/zyda_no_starcoder/c4_en/*

- zyda_peS2o_only: data/zyda_no_starcoder/zyda_peS2o/*

- zyda_pile-uncopyrighted_only: data/zyda_no_starcoder/zyda_pile-uncopyrighted/*

- zyda_refinedweb_only: data/zyda_no_starcoder/zyda_refinedweb/*

- zyda_slimpajama_only: data/zyda_no_starcoder/zyda_slimpajama/*

- zyda_starcoder_only: data/zyda_starcoder//

数据集描述

- 数据集来源: 由七个高质量的开源数据集组成

- 数据字段:

text: 训练文本source: 文本来源filtering_features: 用于过滤的预计算特征值(转换为JSON字符串)source_other: 来源数据集的元数据(转换为JSON字符串)

数据收集和处理

- 处理步骤: 过滤和去重

- 过滤方法: 使用手工调整的过滤器,来源包括C4、RedPajama和Gopher等

- 去重方法: 使用minhash近似去重,基于13-gram和Jaccard相似度阈值0.4

数据集组件

| 组件 | 下载大小 (GB) | 文档数量 (百万) | 令牌数量 (十亿) |

|---|---|---|---|

| zyda_refinedweb_only | 1,712.4 | 920.5 | 564.8 |

| zyda_c4-en_only | 366.7 | 254.5 | 117.5 |

| zyda_slimpajama_only | 594.7 | 142.3 | 242.3 |

| zyda_pile-uncopyrighted_only | 189.4 | 64.9 | 82.9 |

| zyda_peS2o_only | 133.7 | 35.7 | 53.4 |

| zyda_arxiv_only | 8.3 | 0.3 | 4.7 |

| zyda_starcoder_only | 299.5 | 176.1 | 231.3 |

| 总计 | 3,304.7 | 1,594.2 | 1,296.7 |

许可证信息

- 许可证: Open Data Commons License (ODC-BY)

- 使用条款: 使用此数据集还需遵守原始数据源的许可证协议和使用条款

引用信息

@misc{tokpanov2024zyda, title={Zyda: A 1.3T Dataset for Open Language Modeling}, author={Yury Tokpanov and Beren Millidge and Paolo Glorioso and Jonathan Pilault and Adam Ibrahim and James Whittington and Quentin Anthony}, year={2024}, eprint={2406.01981}, archivePrefix={arXiv}, primaryClass={cs.CL} }

中国1km分辨率逐月降水量数据集(1901-2024)

该数据集为中国逐月降水量数据,空间分辨率为0.0083333°(约1km),时间为1901.1-2024.12。数据格式为NETCDF,即.nc格式。该数据集是根据CRU发布的全球0.5°气候数据集以及WorldClim发布的全球高分辨率气候数据集,通过Delta空间降尺度方案在中国降尺度生成的。并且,使用496个独立气象观测点数据进行验证,验证结果可信。本数据集包含的地理空间范围是全国主要陆地(包含港澳台地区),不含南海岛礁等区域。为了便于存储,数据均为int16型存于nc文件中,降水单位为0.1mm。 nc数据可使用ArcMAP软件打开制图; 并可用Matlab软件进行提取处理,Matlab发布了读入与存储nc文件的函数,读取函数为ncread,切换到nc文件存储文件夹,语句表达为:ncread (‘XXX.nc’,‘var’, [i j t],[leni lenj lent]),其中XXX.nc为文件名,为字符串需要’’;var是从XXX.nc中读取的变量名,为字符串需要’’;i、j、t分别为读取数据的起始行、列、时间,leni、lenj、lent i分别为在行、列、时间维度上读取的长度。这样,研究区内任何地区、任何时间段均可用此函数读取。Matlab的help里面有很多关于nc数据的命令,可查看。数据坐标系统建议使用WGS84。

国家青藏高原科学数据中心 收录

Pima Indians Diabetes Database

该项目使用的数据集是Pima Indians Diabetes Database,来源于UCI机器学习库。该数据集包含多个医学预测变量和一个目标变量,即Outcome,用于指示患者是否患有糖尿病(1)或未患(0)。

github 收录

WorldClim

WorldClim是一个全球气候数据集,提供了全球范围内的气候数据,包括温度、降水、生物气候变量等。数据集的分辨率从30秒到10分钟不等,适用于各种尺度的气候分析和建模。

www.worldclim.org 收录

ISIC 2018

ISIC 2018数据集包含2594张皮肤病变图像,用于皮肤癌检测任务。数据集分为训练集、验证集和测试集,每张图像都附有详细的元数据,包括病变类型、患者年龄、性别和解剖部位等信息。

challenge2018.isic-archive.com 收录

TCIA

TCIA(The Cancer Imaging Archive)是一个公开的癌症影像数据集,包含多种癌症类型的医学影像数据,如CT、MRI、PET等。这些数据通常与临床和病理信息相结合,用于癌症研究和临床试验。

www.cancerimagingarchive.net 收录