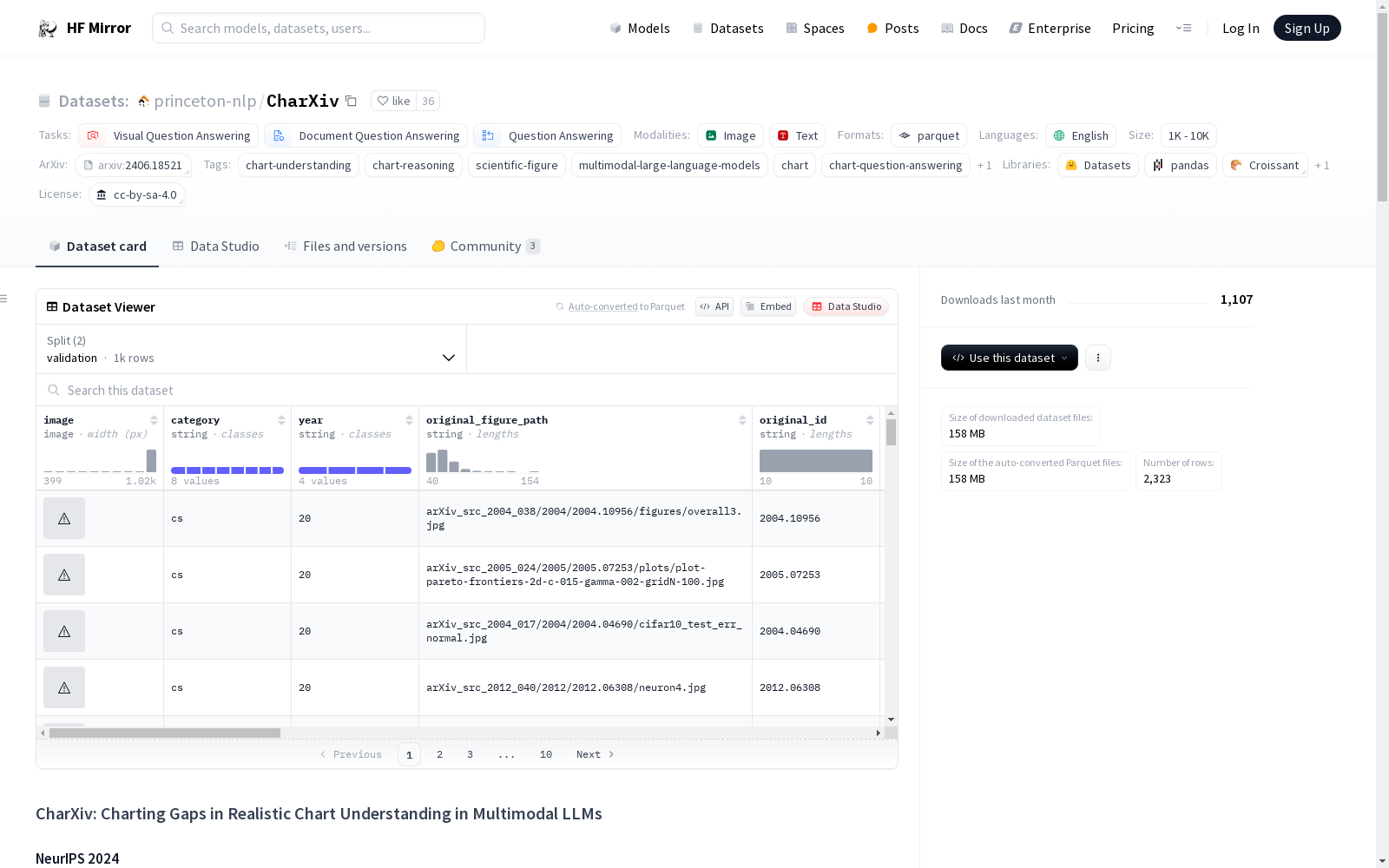

princeton-nlp/CharXiv|图表理解数据集|多模态处理数据集

收藏CharXiv 数据集概述

基本信息

- 许可证: CC BY-SA 4.0

- 任务类别:

- 视觉问答

- 文档问答

- 问答

- 语言: 英语

- 标签:

- 图表理解

- 图表推理

- 科学图表

- 多模态大型语言模型

- 图表

- 图表问答

- 视觉语言

- 数据规模: 1K<n<10K

数据集描述

- 名称: CharXiv: Charting Gaps in Realistic Chart Understanding in Multimodal LLMs

- 来源: 由人类专家完全策划,包含2,323张从arXiv预印本中手动收集的高分辨率图表。

- 内容: 每张图表配对4个描述性问题(3个可回答和1个不可回答)和1个推理问题,所有问题都需要开放词汇的简短答案,易于验证。

使用限制

- 用途: 仅用于评估模型,不允许用于训练模型。

许可证

- 问题许可证: CC BY-SA 4.0

- 图表版权: 归原始作者所有,每个图表的来源在

original_id列中提供,即包含这些图表的arXiv预印本编号。

联系方式

- 问题提交: GitHub 问题

- 电子邮件: zw1300@cs.princeton.edu

中国气象数据

本数据集包含了中国2023年1月至11月的气象数据,包括日照时间、降雨量、温度、风速等关键数据。通过这些数据,可以深入了解气象现象对不同地区的影响,并通过可视化工具揭示中国的气温分布、降水情况、风速趋势等。

github 收录

中国交通事故深度调查(CIDAS)数据集

交通事故深度调查数据通过采用科学系统方法现场调查中国道路上实际发生交通事故相关的道路环境、道路交通行为、车辆损坏、人员损伤信息,以探究碰撞事故中车损和人伤机理。目前已积累深度调查事故10000余例,单个案例信息包含人、车 、路和环境多维信息组成的3000多个字段。该数据集可作为深入分析中国道路交通事故工况特征,探索事故预防和损伤防护措施的关键数据源,为制定汽车安全法规和标准、完善汽车测评试验规程、

北方大数据交易中心 收录

music-genres-dataset

包含1494个音乐流派的数据集,每个流派有200首歌曲。每首歌曲提供以下属性:艺术家、歌曲名称、在列表中的位置、主流派、子流派(含流行度计数)、标签(非现有流派的标签,如情感等,也含流行度计数)。

github 收录

猫狗图像数据集

该数据集包含猫和狗的图像,每类各12500张。训练集和测试集分别包含10000张和2500张图像,用于模型的训练和评估。

github 收录

BDD100K

数据集推动了视觉的进步,但现有的驾驶数据集在视觉内容和支持任务方面缺乏研究,以研究自动驾驶的多任务学习。研究人员通常只能在一个数据集上研究一小组问题,而现实世界的计算机视觉应用程序需要执行各种复杂的任务。我们构建了最大的驾驶视频数据集 BDD100K,包含 10 万个视频和 10 个任务,以评估图像识别算法在自动驾驶方面的令人兴奋的进展。该数据集具有地理、环境和天气的多样性,这对于训练不太可能对新条件感到惊讶的模型很有用。基于这个多样化的数据集,我们为异构多任务学习建立了一个基准,并研究了如何一起解决这些任务。我们的实验表明,现有模型需要特殊的训练策略来执行此类异构任务。 BDD100K 为未来在这个重要场所的学习打开了大门。更多详细信息请参见数据集主页。

OpenDataLab 收录