MultiNLI Dataset|自然语言推理数据集|NLP数据集

收藏github2024-08-18 更新2024-08-21 收录

下载链接:

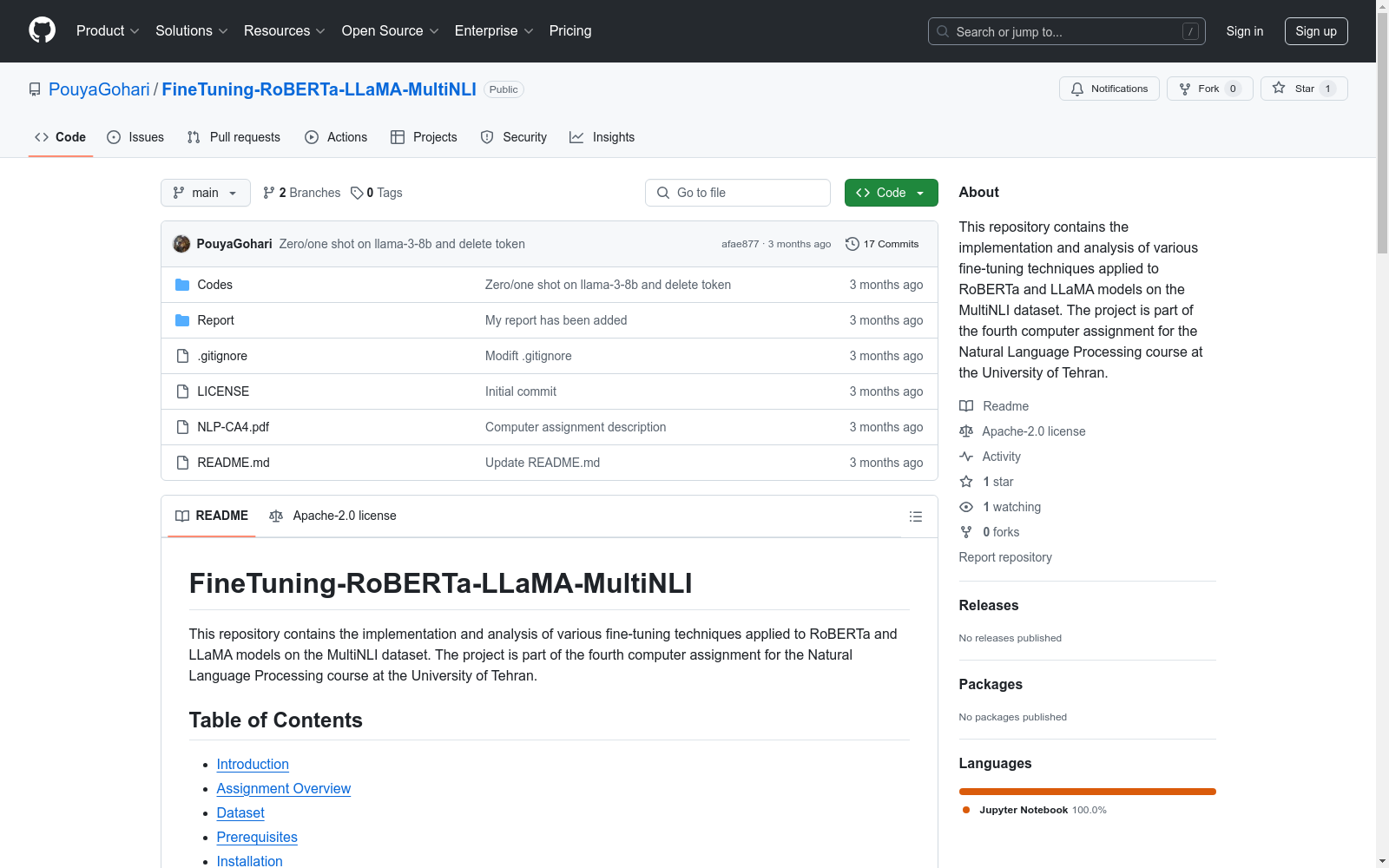

https://github.com/PouyaGohari/FineTuning-RoBERTa-LLaMA-MultiNLI

下载链接

链接失效反馈资源简介:

我们使用了来自Hugging Face的MultiNLI数据集。该数据集可以从以下链接下载:[MultiNLI on Hugging Face](https://huggingface.co/datasets/nyu-mll/multi_nli)

创建时间:

2024-08-18

原始信息汇总

数据集概述

数据集信息

- 名称: MultiNLI

- 来源: Hugging Face

- 链接: MultiNLI on Hugging Face

数据集用途

该数据集用于对RoBERTa和LLaMA模型进行多种微调技术的实现和分析,包括传统的微调方法、LoRA、P-tuning和基于提示的技术。

相关模型和方法

-

模型:

roberta-largellama-3-8b-instruct

-

微调方法:

- 传统微调

- LoRA微调

- P-tuning

- 零样本和单样本提示技术

- QLoRA微调

- 使用QLoRA添加分类器层

数据集下载

数据集可以从以下链接下载:

- MultiNLI Dataset: MultiNLI on Hugging Face

AI搜集汇总

数据集介绍

构建方式

MultiNLI数据集的构建基于自然语言推理(NLI)任务,旨在评估模型对文本对之间关系的理解能力。该数据集从多个来源收集了大量的文本对,并由专家标注了这些文本对之间的逻辑关系,如蕴含、矛盾和中性。通过这种方式,MultiNLI数据集为研究者提供了一个丰富的资源,用于训练和评估自然语言处理模型在不同语境下的推理能力。

特点

MultiNLI数据集的一个显著特点是其多样性和广泛性。它包含了来自不同领域和风格的文本对,确保了数据集的覆盖面和代表性。此外,该数据集还提供了匹配和不匹配的子集,分别用于训练和测试,这有助于模型在不同数据分布下的泛化能力。通过这些设计,MultiNLI数据集成为了自然语言推理任务中的一个重要基准。

使用方法

使用MultiNLI数据集时,研究者可以通过下载数据集并加载到相应的自然语言处理框架中,如Hugging Face的Transformers库。数据集的使用通常涉及预处理步骤,如文本清洗和格式化,随后进行模型训练和评估。具体的实现细节可以在提供的Jupyter笔记本中找到,每个笔记本都详细介绍了不同的微调技术和提示方法,确保用户能够系统地应用和评估这些技术。

背景与挑战

背景概述

MultiNLI数据集是由纽约大学(NYU)的机器学习实验室(MLL)创建的,旨在推动自然语言处理(NLP)领域中的文本蕴含研究。该数据集的创建时间可追溯至NLP研究的早期阶段,其核心研究问题集中在文本之间的逻辑关系分析上。MultiNLI数据集通过提供大规模的文本对及其蕴含关系标签,极大地促进了文本蕴含任务的模型训练和评估,对NLP领域的研究产生了深远影响。

当前挑战

MultiNLI数据集在构建过程中面临了多重挑战。首先,文本蕴含任务的复杂性要求数据集必须包含多样化的文本对,以确保模型能够泛化到不同类型的文本关系。其次,数据集的标注过程需要高度专业化的知识和一致性,以确保标签的准确性和可靠性。此外,随着NLP技术的快速发展,如何持续更新和扩展数据集以适应新的模型和方法,也是一个重要的挑战。

常用场景

经典使用场景

在自然语言处理领域,MultiNLI数据集的经典使用场景主要集中在文本蕴含关系的识别与分类任务上。该数据集通过提供大量标注的句子对,使得研究人员能够训练和评估模型在不同语境下的文本蕴含能力。例如,通过使用RoBERTa和LLaMA等大型语言模型,研究人员可以进行微调实验,以比较不同微调技术(如LoRA、P-tuning和基于提示的技术)在MultiNLI数据集上的效果。

解决学术问题

MultiNLI数据集在学术研究中解决了文本蕴含关系识别的关键问题。通过提供丰富的标注数据,该数据集帮助研究人员开发和验证新的自然语言处理模型,特别是在文本蕴含关系的分类任务上。这不仅推动了模型性能的提升,还为理解人类语言的复杂性提供了宝贵的数据支持,对自然语言处理领域的发展具有重要意义。

衍生相关工作

MultiNLI数据集的发布激发了大量相关研究工作。例如,许多研究者基于该数据集开发了新的微调技术和模型架构,如LoRA、P-tuning和基于提示的技术。这些研究不仅提升了模型的性能,还为自然语言处理领域提供了新的方法论。此外,MultiNLI数据集还被用于验证和比较不同语言模型的效果,推动了大型语言模型如RoBERTa和LLaMA的发展和应用。

以上内容由AI搜集并总结生成