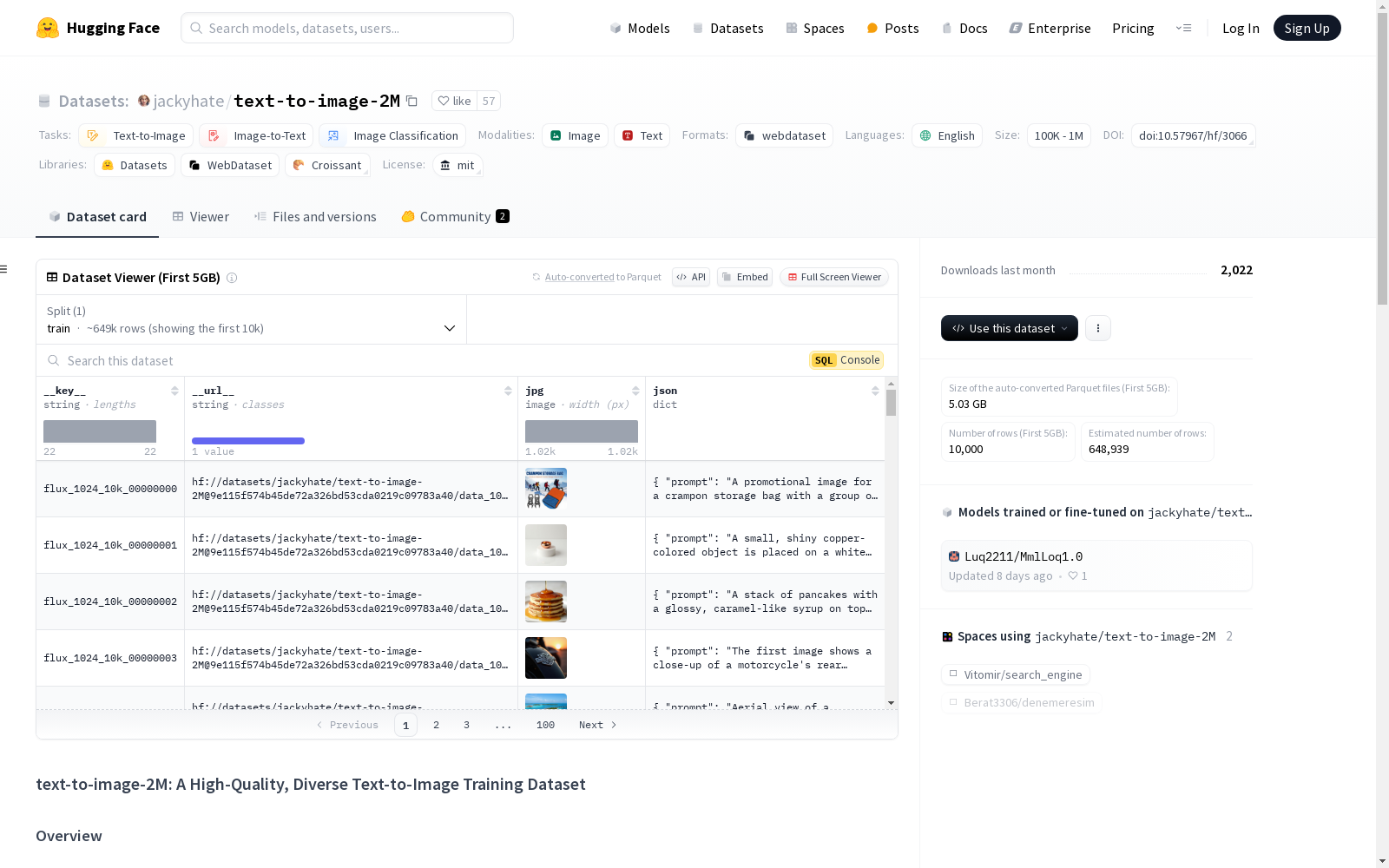

text-to-image-2M|文本到图像生成数据集|模型微调数据集

收藏text-to-image-2M: A High-Quality, Diverse Text-to-Image Training Dataset

Overview

text-to-image-2M 是一个用于微调文本到图像模型的精选文本图像对数据集。该数据集包含约200万个样本,经过精心选择和增强,以满足文本到图像模型训练的高要求。创建此数据集的动机是观察到超过100万个样本的数据集往往能产生更好的微调结果。然而,现有的公开数据集通常存在以下限制:

- 图像理解数据集:无法保证图像质量。

- 非正式收集或任务特定数据集:类别不平衡或缺乏多样性。

- 大小限制:可用数据集要么太小,要么太大(从大数据集中抽取的子集通常缺乏多样性)。

为了解决这些问题,我们结合并增强了现有的高质量数据集,使用最先进的文本到图像和字幕生成模型创建了text-to-image-2M。这包括data_512_2M,一个200万512x512微调数据集和data_1024_10K,一个10K高质量、高分辨率数据集(用于高分辨率适应)。

Dataset Composition

data_512_2M

该数据集由几个高质量子集组成,详细如下:

| Source | Samples | Prompts | Images |

|---|---|---|---|

| LLaVA-next fine-tuning dataset | ~700K | 使用Qwen2-VL重新标注 | 原始图像 |

| LLaVA-pretrain dataset(TODO) | ~500K | 原始提示 | Flux-dev生成的图像 |

| ProGamerGov synthetic dataset (DALL·E 3) | ~900K | 过滤有效性 | 中心裁剪和有效性过滤的图像 |

| GPT-4o generated dataset | 100K | GPT-4o生成 | Flux-dev生成的图像 |

data_1024_10K

由Flux-dev生成的10K图像,提示由GPT-4o生成。

Usage

该数据集使用WebDataset格式,可以通过HuggingFace的datasets库轻松访问和使用,如下所示:

python from datasets import load_dataset base_url = "https://huggingface.co/datasets/jackyhate/text-to-image-2M/resolve/main/data_512_2M/data_{i:06d}.tar" num_shards = 35 # Number of webdataset tar files urls = [base_url.format(i=i) for i in range(num_shards)] dataset = load_dataset("webdataset", data_files={"train": urls}, split="train", streaming=True)

Example of iterating through the dataset

for image in dataset: print(image) # single image in row with associated columns break

- 注意,只要在上述示例中

streaming=True,数据集就不必完全下载。

Acknowledgments

该数据集建立在多个开源项目的基础上,包括:

- LLaVA-next fine-tuning dataset

- LLaVA-pretrain dataset

- ProGamerGov synthetic dataset (DALL·E 3)

- GPT-4o

- Flux-1.0-dev

我们感谢这些数据集和模型的贡献者,使这个项目成为可能。