OVT-B|多目标跟踪数据集|开放词汇数据集

收藏arXiv2024-10-23 更新2024-10-25 收录

下载链接:

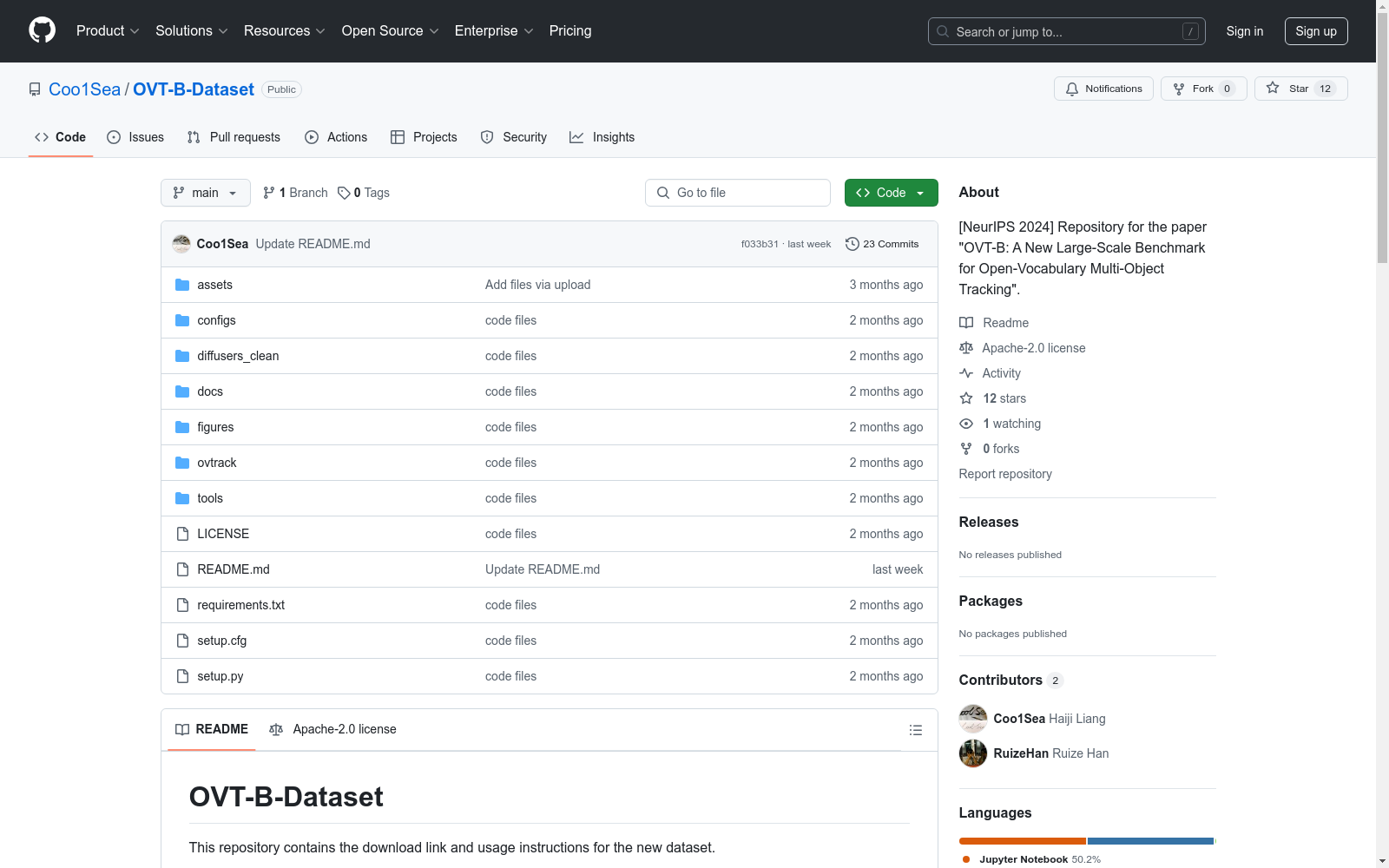

https://github.com/Coo1Sea/OVT-B-Dataset

下载链接

链接失效反馈资源简介:

OVT-B数据集是由浙江大学和中国科学院深圳先进技术研究院联合创建的一个大规模开放词汇多目标跟踪基准。该数据集包含1,048个类别和1,973个视频,总计637,608个边界框注释,显著超过了现有的开放词汇跟踪数据集。数据集的创建过程包括从多个现有数据集中选择视频数据,并进行统一注释,确保了数据的高质量和多样性。OVT-B数据集主要用于推动开放词汇多目标跟踪研究,旨在解决传统多目标跟踪方法在处理广泛目标类别时的局限性。

提供机构:

浙江大学软件技术学院、中国科学院深圳先进技术研究院、香港城市大学计算机科学系

创建时间:

2024-10-23

原始信息汇总

OVT-B-Dataset

数据集描述

OVT-B数据集可作为OVMOT研究的新基准。

下载链接

- BaiDuYun (提取码: 8yy3)

- GoogleDrive

使用说明

- 下载数据集和标注文件。

- 解压文件。

- 从

ovtb_classname.py文件中复制CLASS、base_id和novel_id,并将其添加到ov检测器roi_head文件夹下的classname.py文件中。 - 修改配置文件中的

data_root为OVT-B文件夹所在的路径,将ann_file修改为ovtb_ann.json的路径,img_prefix修改为data_root+OVT-B,prompt_path修改为ovtb_class.pth的路径。 - 使用TAO-type或COCO-type数据集评估工具/代码进行测试/评估。

数据集结构

├── OVT-B │ ├── AnimalTrack │ │ ├── subdir │ │ │ ├── img.jpg │ │ │ └── ... │ ├── GMOT-40 │ ├── ImageNet-VID │ ├── LVVIS │ ├── OVIS │ ├── UVO │ ├── YouTube-VIS-2021 ├── ovtb_ann.json ├── ovtb_class.pth ├── ovtb_classname.py ├── ovtb_prompt.pth └── OVTB-format.txt

数据样本展示

- 包含四张数据样本图片,分别命名为Sample 1、Sample 2、Sample 3和Sample 4。

基线方法

- 详细信息请参考OVTrack。

引用

@article{2024ovtb, title={OVT-B: A New Large-Scale Benchmark for Open-Vocabulary Multi-Object Tracking}, author={Liang, haiji and Han, Ruize}, journal={arXiv preprint arXiv:2410.17534}, year={2024} }

AI搜集汇总

数据集介绍

构建方式

OVT-B数据集的构建基于现有的大规模数据集,通过严格的筛选标准,包括视频中包含多个对象、代表多种类别、大多数对象处于运动状态以及数据必须是原始且未从其他数据集派生。研究团队从七个不同的数据集中选择了符合这些标准的视频,这些数据集涵盖了多目标跟踪(MOT)、视频实例分割(VIS)和视频对象检测(VOD)等任务。通过排除仅包含背景类别、非特定类别和未知类别的序列,保留至少包含两个对象的序列,最终构建了OVT-B数据集。该数据集不仅保留了原始视频的分辨率、时长和标注帧率,还确保了OVMOT任务所需的强大评估基准。

使用方法

OVT-B数据集主要用于评估开放词汇多目标跟踪(OVMOT)任务的性能。研究者可以使用该数据集来训练和测试他们的跟踪算法,评估其在处理未见类别对象时的表现。数据集的多样性和大规模特性使其成为开发和验证新算法的宝贵资源。此外,OVT-B数据集还提供了一个简单的基线方法OVTrack+,该方法结合了外观和运动信息,为研究者提供了一个有效的起点。通过在OVT-B上的实验,研究者可以更好地理解和改进他们的算法,推动OVMOT领域的发展。

背景与挑战

背景概述

开放词汇对象感知已成为人工智能领域的一个重要课题,旨在识别训练过程中未见过的对象类别。在此背景下,开放词汇对象检测(OVD)在单张图像中的研究已得到广泛关注。然而,开放词汇对象跟踪(OVT)在视频中的研究相对较少,其中一个原因是缺乏相应的基准数据集。为此,浙江大学和深圳先进技术研究院的研究团队创建了OVT-B数据集,该数据集包含1,048个对象类别和1,973个视频,总计637,608个边界框标注,显著超越了现有的开放词汇跟踪数据集。OVT-B的提出为OVT研究提供了一个新的基准,推动了该领域的发展。

当前挑战

OVT-B数据集的构建面临多重挑战。首先,开放词汇对象跟踪任务需要处理大量未见过的对象类别,这对模型的泛化能力提出了高要求。其次,数据集的构建过程中,研究人员需要整合来自不同数据源的视频数据,并进行统一标注,这涉及到标注格式、类别定义和遮挡标注方式的差异处理。此外,为了确保数据集的质量和多样性,研究人员还需进行严格的数据清洗和标注校验。这些挑战不仅影响了数据集的构建效率,也对后续的模型训练和评估提出了更高的要求。

常用场景

经典使用场景

OVT-B数据集的经典使用场景主要集中在开放词汇多目标跟踪(OVMOT)任务中。该数据集通过提供包含1,048个类别和1,973个视频的大规模标注数据,为研究人员提供了一个强大的基准,以评估和开发能够识别和跟踪训练过程中未见类别的算法。OVT-B的广泛类别和密集标注特性使其成为评估模型在复杂和多样化环境中性能的理想选择。

解决学术问题

OVT-B数据集解决了开放词汇多目标跟踪领域中缺乏全面基准的问题。传统的多目标跟踪任务主要集中在人类和车辆等特定类别上,而OVT-B通过引入大量未见类别,推动了模型在更广泛目标类别上的泛化能力。这不仅提升了学术研究的前沿性,还为实际应用中的复杂场景提供了更强的技术支持。

实际应用

在实际应用中,OVT-B数据集可以广泛应用于需要高度自适应和泛化能力的监控系统、自动驾驶和智能交通管理等领域。例如,在自动驾驶中,车辆需要能够识别和跟踪各种未知的道路使用者,如动物、行人或其他车辆。OVT-B的多样化类别和密集标注特性使得训练出的模型能够更好地应对这些复杂和多变的实际场景。

数据集最近研究

最新研究方向

在人工智能领域,开放词汇对象感知已成为一个重要课题,旨在识别训练过程中未见过的对象类别。尽管开放词汇对象检测(OVD)在单张图像中已得到广泛研究,但开放词汇对象跟踪(OVT)在视频中的研究相对较少,主要原因在于缺乏相应的基准数据集。为此,OVT-B数据集的构建填补了这一空白,该数据集包含1,048个对象类别和1,973个视频,拥有637,608个边界框标注,显著超越了现有的开放词汇跟踪数据集。OVT-B不仅为OVT研究提供了新的基准,还开发了一种简单而有效的基线方法,结合了运动特征,这在以往的OVT方法中被忽视。实验结果验证了该基准数据集的实用性和所提出方法的有效性,推动了开放词汇多对象跟踪(OVMOT)领域的发展。

相关研究论文

- 1OVT-B: A New Large-Scale Benchmark for Open-Vocabulary Multi-Object Tracking浙江大学软件技术学院、中国科学院深圳先进技术研究院、香港城市大学计算机科学系 · 2024年

以上内容由AI搜集并总结生成