DTGB|动态文本属性图数据集|数据分析数据集

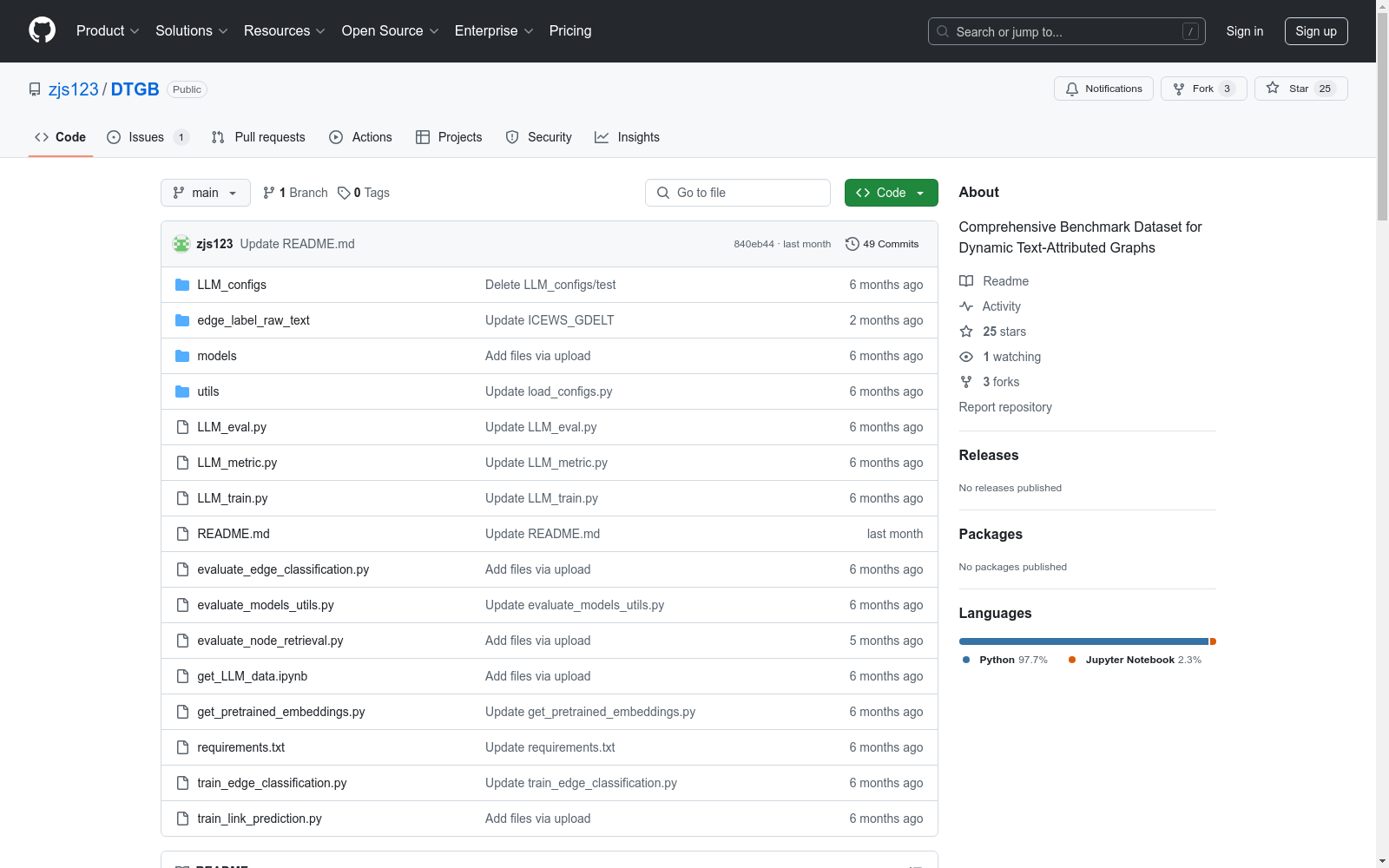

收藏DTGB: A Comprehensive Benchmark for Dynamic Text-Attributed Graphs

数据集

DTGB提供了八个动态文本属性图数据集,可以从这里下载。

数据格式

每个图数据集包含三个文件:

- edge_list.csv: 存储每条边的信息,格式为

(u, v, r, t, l),其中u是源实体的ID,v是目标实体的ID,r是关系的ID,t是边的发生时间戳,l是边的标签。 - entity_text.csv: 存储实体ID与实体文本描述的映射。

- relation_text.csv: 存储关系ID与关系文本描述的映射。

使用方法

- 下载数据集后,应将其解压缩到

DyLink_Datasets文件夹中。 - 运行

get_pretrained_embeddings.py获取基于Bert的节点和边文本嵌入,分别保存为e_feat.npy和r_feat.npy。 - 运行

get_LLM_data.ipynb获取文本关系生成任务的训练和测试集,分别保存为LLM_train.pkl和LLM_test.pkl。

结果复现

未来链接预测任务

-

在 GDELT 数据集上训练 DyGFormer 模型,不使用文本属性的示例: bash python train_link_prediction.py --dataset_name GDELT --model_name DyGFormer --patch_size 2 --max_input_sequence_length 64 --num_runs 5 --gpu 0 --use_feature no

-

在 GDELT 数据集上训练 DyGFormer 模型,使用文本属性的示例: bash python train_link_prediction.py --dataset_name GDELT --model_name DyGFormer --patch_size 2 --max_input_sequence_length 64 --num_runs 5 --gpu 0 --use_feature Bert

-

测试集的 AP 和 AUC-ROC 指标将自动保存到

saved_resuts/DyGFormer/GDELT/DyGFormer_seed0no.json。 -

最佳检查点将保存到

saved_resuts/DyGFormer/GDELT/文件夹中。

目标节点检索任务

在获得未来链接预测任务的最佳检查点后,可以通过运行以下命令复现目标节点检索任务的 Hits@k 指标: bash python evaluate_node_retrieval.py --dataset_name GDELT --model_name DyGFormer --patch_size 2 --max_input_sequence_length 64 --negative_sample_strategy random --num_runs 5 --gpu 0 --use_feature no

negative_sample_strategy参数控制候选采样策略,可以是random或historical。use_feature参数控制是否使用基于Bert的嵌入,可以是no或Bert。

边分类任务

-

在 GDELT 数据集上训练 DyGFormer 模型,不使用文本属性的示例: bash python train_edge_classification.py --dataset_name GDELT --model_name DyGFormer --patch_size 2 --max_input_sequence_length 64 --num_runs 5 --gpu 0 --use_feature no

-

测试集的 Precision、Recall 和 F1-score 指标将自动保存到

saved_resuts/DyGFormer/GDELT/edge_classification_DyGFormer_seed0no.json。

文本关系生成任务

在获得 LLM_train.pkl 和 LLM_test.pkl 文件后,可以通过运行以下命令复现原始LLMs的性能:

bash

python LLM_eval.py -config_path=LLM_configs/vicuna_7b_qlora_uncensored.yaml -model=raw

- 可以通过

config_path参数更改LLMs。 - 生成的文本将保存到

s_his_o_des_his_result_vicuna7b.pkl。

然后,可以通过更改 LLM_metric.py 中的文件路径并运行以下命令获取 Bert_score 指标:

bash

python LLM_metric.py

如果需要微调LLMs,可以运行: bash python LLM_train.py LLM_configs/vicuna_7b_qlora_uncensored.yaml

然后通过运行以下命令复现微调后LLMs的性能: bash python LLM_eval.py -config_path=LLM_configs/vicuna_7b_qlora_uncensored.yaml -model=lora

中国农村金融统计数据

该数据集包含了中国农村金融的统计信息,涵盖了农村金融机构的数量、贷款余额、存款余额、金融服务覆盖率等关键指标。数据按年度和地区分类,提供了详细的农村金融发展状况。

www.pbc.gov.cn 收录

Subway Dataset

该数据集包含了全球多个城市的地铁系统数据,包括车站信息、线路图、列车时刻表、乘客流量等。数据集旨在帮助研究人员和开发者分析和模拟城市交通系统,优化地铁运营和乘客体验。

www.kaggle.com 收录

中国高分辨率高质量PM2.5数据集(2000-2023)

ChinaHighPM2.5数据集是中国高分辨率高质量近地表空气污染物数据集(ChinaHighAirPollutants, CHAP)中PM2.5数据集。该数据集利用人工智能技术,使用模式资料填补了卫星MODIS MAIAC AOD产品的空间缺失值,结合地基观测、大气再分析和排放清单等大数据生产得到2000年至今全国无缝隙地面PM2.5数据。数据十折交叉验证决定系数R2为0.92,均方根误差RMSE为10.76 µg/m3。主要范围为整个中国地区,空间分辨率为1 km,时间分辨率为日、月、年,单位为µg/m3。注意:该数据集持续更新,如需要更多数据,请发邮件联系作者(weijing_rs@163.com; weijing@umd.edu)。 数据文件中包含NC转GeoTiff的四种代码(Python、Matlab、IDL和R语言)nc2geotiff codes。

国家青藏高原科学数据中心 收录

Materials Project 在线材料数据库

Materials Project 是一个由伯克利加州大学和劳伦斯伯克利国家实验室于 2011 年共同发起的大型开放式在线材料数据库。这个项目的目标是利用高通量第一性原理计算,为超过百万种无机材料提供全面的性能数据、结构信息和计算模拟结果,以此加速新材料的发现和创新过程。数据库中的数据不仅包括晶体结构和能量特性,还涵盖了电子结构和热力学性质等详尽信息,为研究人员提供了丰富的材料数据资源。相关论文成果为「Commentary: The Materials Project: A materials genome approach to accelerating materials innovation」。

超神经 收录

中国区域地面气象要素驱动数据集 v2.0(1951-2020)

中国区域地面气象要素驱动数据集(China Meteorological Forcing Data,以下简称 CMFD)是为支撑中国区域陆面、水文、生态等领域研究而研发的一套高精度、高分辨率、长时间序列数据产品。本页面发布的 CMFD 2.0 包含了近地面气温、气压、比湿、全风速、向下短波辐射通量、向下长波辐射通量、降水率等气象要素,时间分辨率为 3 小时,水平空间分辨率为 0.1°,时间长度为 70 年(1951~2020 年),覆盖了 70°E~140°E,15°N~55°N 空间范围内的陆地区域。CMFD 2.0 融合了欧洲中期天气预报中心 ERA5 再分析数据与气象台站观测数据,并在辐射、降水数据产品中集成了采用人工智能技术制作的 ISCCP-ITP-CNN 和 TPHiPr 数据产品,其数据精度较 CMFD 的上一代产品有显著提升。 CMFD 历经十余年的发展,其间发布了多个重要版本。2019 年发布的 CMFD 1.6 是完全采用传统数据融合技术制作的最后一个 CMFD 版本,而本次发布的 CMFD 2.0 则是 CMFD 转向人工智能技术制作的首个版本。此版本与 1.6 版具有相同的时空分辨率和基础变量集,但在其它诸多方面存在大幅改进。除集成了采用人工智能技术制作的辐射和降水数据外,在制作 CMFD 2.0 的过程中,研发团队尽可能采用单一来源的再分析数据作为输入并引入气象台站迁址信息,显著缓解了 CMFD 1.6 中因多源数据拼接和气象台站迁址而产生的虚假气候突变。同时,CMFD 2.0 数据的时间长度从 CMFD 1.6 的 40 年大幅扩展到了 70 年,并将继续向后延伸。CMFD 2.0 的网格空间范围虽然与 CMFD 1.6 相同,但其有效数据扩展到了中国之外,能够更好地支持跨境区域研究。为方便用户使用,CMFD 2.0 还在基础变量集之外提供了若干衍生变量,包括近地面相对湿度、雨雪分离降水产品等。此外,CMFD 2.0 摒弃了 CMFD 1.6 中通过 scale_factor 和 add_offset 参数将实型数据化为整型数据的压缩技术,转而直接将实型数据压缩存储于 NetCDF4 格式文件中,从而消除了用户使用数据时进行解压换算的困扰。 本数据集原定版本号为 1.7,但鉴于本数据集从输入数据到研制技术都较上一代数据产品有了大幅的改变,故将其版本号重新定义为 2.0。CMFD 2.0 的数据内容与此前宣传的 CMFD 1.7 基本一致,仅对 1983 年 7 月以后的向下短/长波辐射通量数据进行了更新,以修正其长期趋势存在的问题。2021 年至 2024 年的 CMFD 数据正在制作中,计划于 2025 年上半年发布,从而使 CMFD 2.0 延伸至 2024 年底。

国家青藏高原科学数据中心 收录