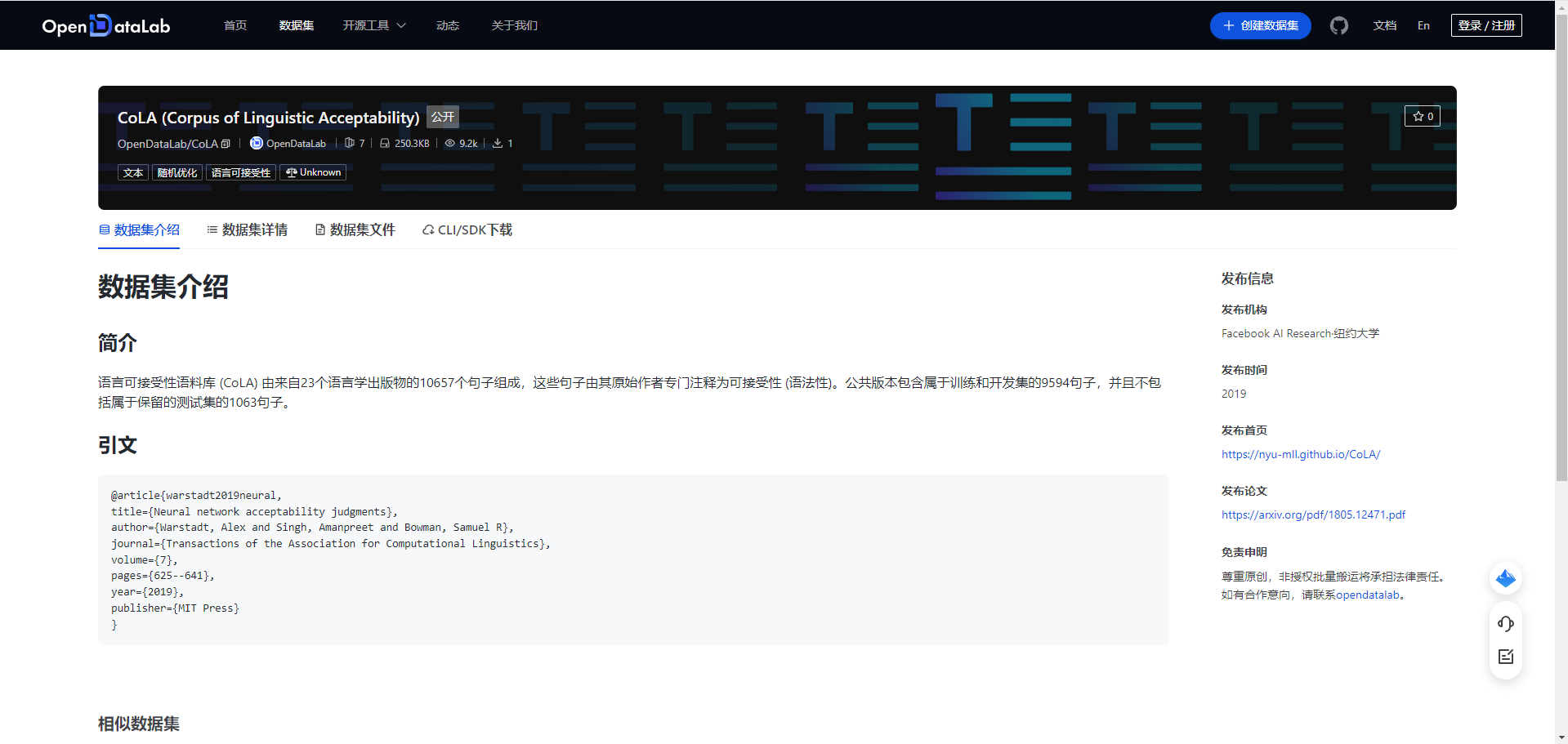

CoLA (Corpus of Linguistic Acceptability)|语言学数据集|自然语言处理数据集

收藏

- CoLA数据集首次发表在《The Corpus of Linguistic Acceptability in Context》论文中,由Alex Warstadt、Amanpreet Singh和Samuel R. Bowman共同提出,旨在评估自然语言处理模型对语法正确性的理解能力。

- CoLA数据集在GLUE(General Language Understanding Evaluation)基准测试中被广泛应用,成为评估模型在语言可接受性任务上性能的重要工具。

- 随着预训练语言模型(如BERT、GPT-3)的发展,CoLA数据集被用于微调这些模型,以提升其在语法判断任务上的表现。

- 1The Corpus of Linguistic Acceptability (CoLA) in Context: Curation and ApplicationNew York University · 2018年

- 2BERT: Pre-training of Deep Bidirectional Transformers for Language UnderstandingGoogle AI Language · 2019年

- 3RoBERTa: A Robustly Optimized BERT Pretraining ApproachFacebook AI Research · 2019年

- 4ALBERT: A Lite BERT for Self-supervised Learning of Language RepresentationsGoogle Research · 2020年

- 5ELECTRA: Pre-training Text Encoders as Discriminators Rather Than GeneratorsStanford University · 2020年

Yahoo Finance

Dataset About finance related to stock market

kaggle 收录

koen430/relevant_selected_stock_news

该数据集包含通过GPT-3.5-turbo筛选出的新闻文章,旨在用于微调大型语言模型,以预测新闻发布后的股票价格变动。数据集包括多个特征,如股票代码、提示、文本、URL、结果、相关性、令牌计数等,并分为训练集、验证集和测试集。

hugging_face 收录

典型分布式光伏出力预测数据集

光伏电站出力数据每5分钟从电站机房监控系统获取;气象实测数据从气象站获取,气象站建于电站30号箱变附近,每5分钟将采集的数据通过光纤传输到机房;数值天气预报数据利用中国电科院新能源气象应用机房的WRF业务系统(包括30TF计算刀片机、250TB并行存储)进行中尺度模式计算后输出预报产品,每日8点前通过反向隔离装置推送到电站内网预测系统。

国家基础学科公共科学数据中心 收录

Traditional-Chinese-Medicine-Dataset-SFT

该数据集是一个高质量的中医数据集,主要由非网络来源的内部数据构成,包含约1GB的中医各个领域临床案例、名家典籍、医学百科、名词解释等优质内容。数据集99%为简体中文内容,质量优异,信息密度可观。数据集适用于预训练或继续预训练用途,未来将继续发布针对SFT/IFT的多轮对话和问答数据集。数据集可以独立使用,但建议先使用配套的预训练数据集对模型进行继续预训练后,再使用该数据集进行进一步的指令微调。数据集还包含一定比例的中文常识、中文多轮对话数据以及古文/文言文<->现代文翻译数据,以避免灾难性遗忘并加强模型表现。

huggingface 收录

Cifar-100

Cifar-100数据集包含100个类别的60000张32x32彩色图像,每个类别有600张图像。这些类别被分为20个超类,每个超类包含5个子类。数据集分为50000张训练图像和10000张测试图像。

www.cs.toronto.edu 收录