SUIM|水下图像语义分割数据集|机器人视觉数据集

收藏

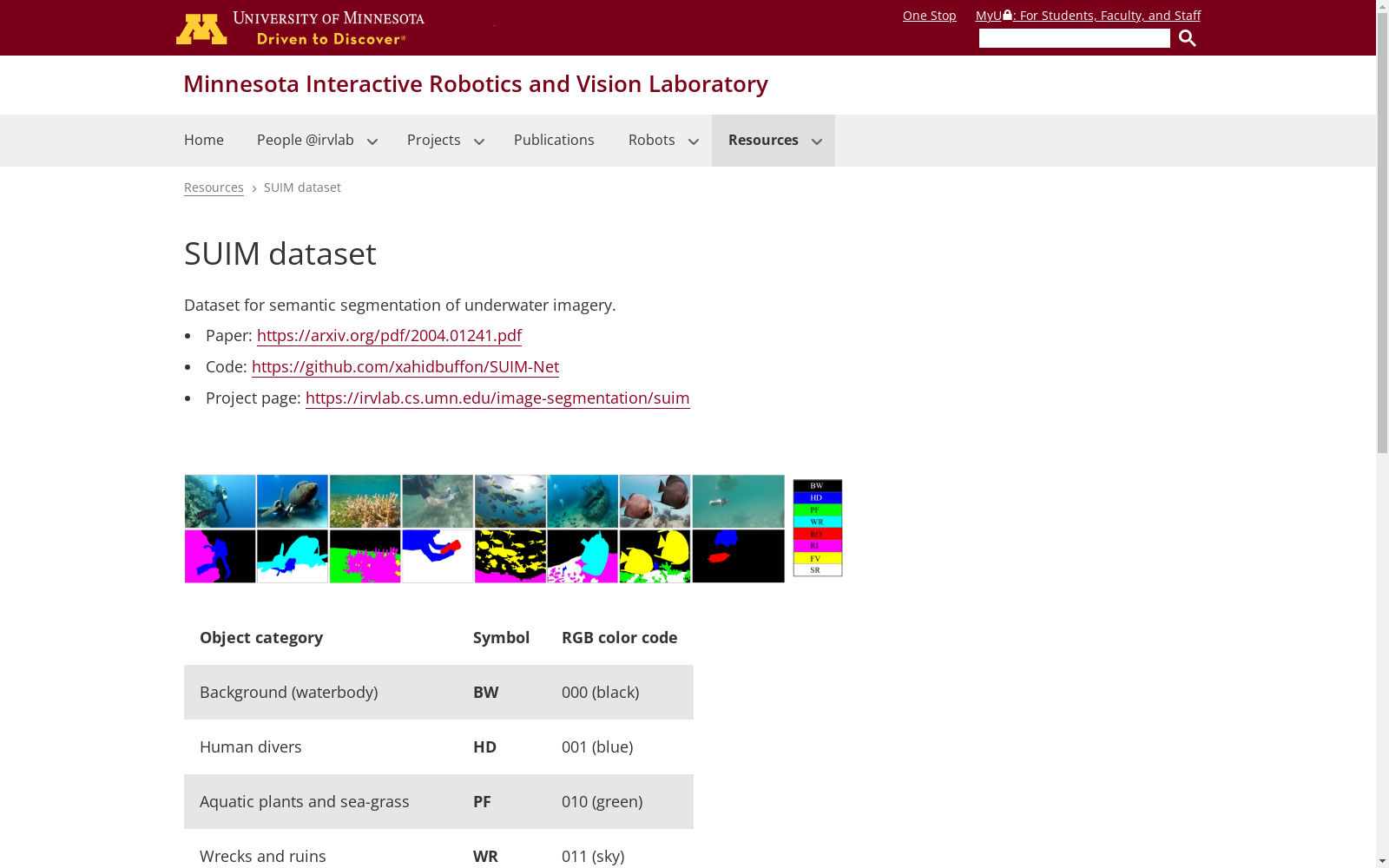

- 1Semantic Segmentation of Underwater Imagery: Dataset and Benchmark交互式机器人与视觉实验室 · 2020年

Google Scholar

Google Scholar是一个学术搜索引擎,旨在检索学术文献、论文、书籍、摘要和文章等。它涵盖了广泛的学科领域,包括自然科学、社会科学、艺术和人文学科。用户可以通过关键词搜索、作者姓名、出版物名称等方式查找相关学术资源。

scholar.google.com 收录

ChemBL

ChemBL是一个化学信息学数据库,包含大量生物活性数据,涵盖了药物发现和开发过程中的各种化学实体。数据集包括化合物的结构信息、生物活性数据、靶点信息等。

www.ebi.ac.uk 收录

AgiBot World

为了进一步推动通用具身智能领域研究进展,让高质量机器人数据触手可及,作为上海模塑申城语料普惠计划中的一份子,智元机器人携手上海人工智能实验室、国家地方共建人形机器人创新中心以及上海库帕思,重磅发布全球首个基于全域真实场景、全能硬件平台、全程质量把控的百万真机数据集开源项目 AgiBot World。这一里程碑式的开源项目,旨在构建国际领先的开源技术底座,标志着具身智能领域 「ImageNet 时刻」已到来。AgiBot World 是全球首个基于全域真实场景、全能硬件平台、全程质量把控的大规模机器人数据集。相比于 Google 开源的 Open X-Embodiment 数据集,AgiBot World 的长程数据规模高出 10 倍,场景范围覆盖面扩大 100 倍,数据质量从实验室级上升到工业级标准。AgiBot World 数据集收录了八十余种日常生活中的多样化技能,从抓取、放置、推、拉等基础操作,到搅拌、折叠、熨烫等精细长程、双臂协同复杂交互,几乎涵盖了日常生活所需的绝大多数动作需求。

github 收录

China Health and Nutrition Survey (CHNS)

China Health and Nutrition Survey(CHNS)是一项由美国北卡罗来纳大学人口中心与中国疾病预防控制中心营养与健康所合作开展的长期开放性队列研究项目,旨在评估国家和地方政府的健康、营养与家庭计划政策对人群健康和营养状况的影响,以及社会经济转型对居民健康行为和健康结果的作用。该调查覆盖中国15个省份和直辖市的约7200户家庭、超过30000名个体,采用多阶段随机抽样方法,收集了家庭、个体以及社区层面的详细数据,包括饮食、健康、经济和社会因素等信息。自2011年起,CHNS不断扩展,新增多个城市和省份,并持续完善纵向数据链接,为研究中国社会经济变化与健康营养的动态关系提供了重要的数据支持。

www.cpc.unc.edu 收录

insurance.csv

该数据集包含医疗保险费用的相关信息,用于分析患者的各种属性及其对保险费用的影响。

github 收录