MAP-CC|自然语言处理数据集|预训练数据集数据集

收藏github2024-04-05 更新2024-05-31 收录

下载链接:

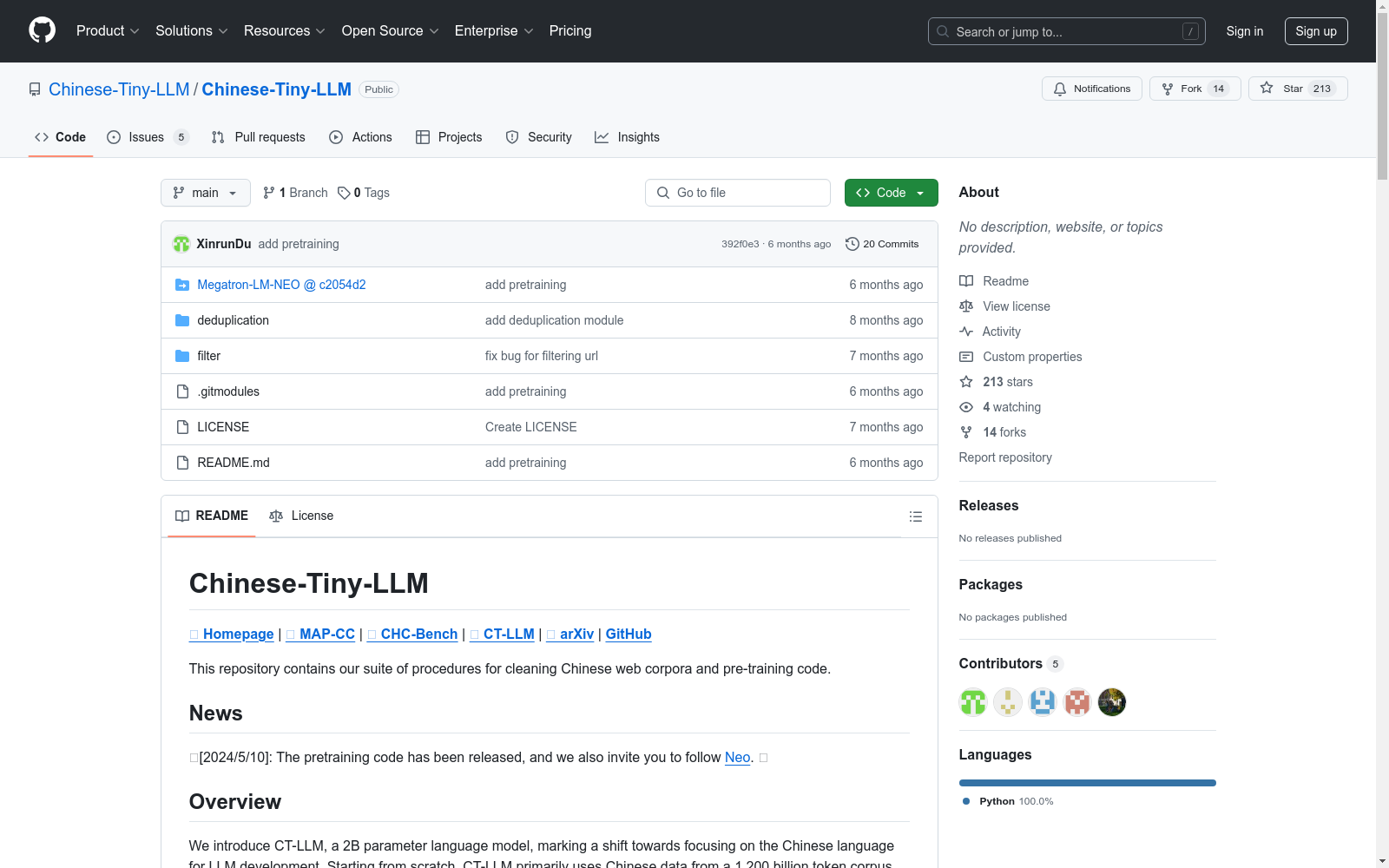

https://github.com/Chinese-Tiny-LLM/Chinese-Tiny-LLM

下载链接

链接失效反馈资源简介:

MAP-CC An open-source Chinese pretraining dataset with a scale of 800 billion tokens, along with a detailed suite of procedures for cleaning Chinese web corpora, offering the NLP community high-quality Chinese pretraining data and an effective methodology for data preparation.

MAP-CC:一款开源的中文预训练数据集,规模达800亿个token,附带详尽的清洗中文网络语料库的流程,为自然语言处理领域提供高质量中文预训练数据和高效的数据准备方法。

提供机构:

Multimodal Art Projection 、复旦大学、北京大学等

创建时间:

2024-04-05

原始信息汇总

数据集概述

数据集名称: CT-LLM

数据集描述: CT-LLM是一个2亿参数的语言模型,专注于中文语言处理。该模型主要使用包含1,200亿令牌的语料库进行训练,其中800亿为中文令牌,300亿为英文令牌,100亿为代码令牌。通过使用中文数据和调整技术,CT-LLM在处理中文语言任务上表现出色,并通过SFT在英文上也表现良好。

数据集组件

-

MAP-CC

- 描述: 一个开放源代码的中文预训练数据集,包含800亿令牌,以及一套详细的清理中文网络语料库的程序。

- 目的: 为自然语言处理社区提供高质量的中文预训练数据和有效的数据准备方法。

-

CHC-Bench

- 描述: 一个精选的多学科中文硬案例指令理解和遵循基准。

- 目的: 用于评估和改进模型在中文复杂案例处理上的能力。

-

CT-LLM

- 描述: 首个以中文为中心的大型语言模型,主要在中文语料库上进行预训练和微调。

- 目的: 提供关于潜在偏见、中文语言能力和多语言适应性的深入见解。

数据处理流程

-

过滤

- 步骤: 使用fasttext模型进行文本过滤。

- 命令示例:

python3 filter/filter.py --input_data input_dir --output_dir output_dir --success_dir success_dir --log_dir log_dir --worker num_worker

-

去重

-

全文本去重

- 命令示例:

python3 deduplication/full_text_dedup/full_text_dedup.py --input_dir input_dir --output_dir output_dir --content_field_name content_field_name

- 命令示例:

-

Minhash LSH去重

- 生成Minhash

- 命令示例:

python3 deduplication/minhash_lsh/generate_minhash.py --input_dir input_dir --output_dir output_dir --workers num_workers --content_field_name content_field_name

- 命令示例:

- 生成重复对

- 命令示例:

python3 deduplication/minhash_lsh/generate_dup_pairs.py --input_dir input_dir --output_dir output_dir

- 命令示例:

- 生成连接组件

- 命令示例:

python3 deduplication/minhash_lsh/generate_connected_components.py --input_dir input_dir --output_file output_file --num_workers num_workers

- 命令示例:

- 生成每个文件的重复行ID

- 命令示例:

python3 deduplication/minhash_lsh/generate_dup_line_id_for_each_file.py --input_file input_file --output_dir output_dir

- 命令示例:

- 移除重复项

- 命令示例:

python3 deduplication/minhash_lsh/remove_dup.py --input_dir input_dir --output_dir output_dir --dup_line_id_dir dup_line_id_dir --worker num_worker

- 命令示例:

- 生成Minhash

-

相似行去重

- 命令示例:

python3 deduplication/simlar_line_dedup/similar_line_dedup.py --input_dir input_dir --output_dir output_dir --wokers num_worker --content_field_name content_field_name

- 命令示例:

-

预训练信息

- 预训练代码访问: 请参考Neo。

许可证

- 许可证类型: 创意共享署名-非商业性使用-禁止演绎4.0国际许可协议(CC BY-NC-ND 4.0)。

- 使用条款: 允许非商业性共享(复制和分发材料),不得进行修改或衍生,必须给予适当的署名。

引用信息

@misc{du2024chinese, title={Chinese Tiny LLM: Pretraining a Chinese-Centric Large Language Model}, author={Xinrun Du and Zhouliang Yu and Songyang Gao and Ding Pan and Yuyang Cheng and Ziyang Ma and Ruibin Yuan and Xingwei Qu and Jiaheng Liu and Tianyu Zheng and Xinchen Luo and Guorui Zhou and Binhang Yuan and Wenhu Chen and Jie Fu and Ge Zhang}, year={2024}, eprint={2404.04167}, archivePrefix={arXiv}, primaryClass={cs.CL} }

AI搜集汇总

数据集介绍

构建方式

MAP-CC数据集的构建始于对1,200亿标记的语料库进行筛选和预处理,其中包含800亿中文、300亿英文和100亿代码标记。通过使用fasttext模型进行语言识别过滤,确保数据集的语言纯度。随后,数据集经历了全文去重和相似行去重两个主要去重阶段,分别采用Minhash LSH算法和全文本比对技术,以确保数据的高质量和多样性。最终,经过严格的数据清洗和去重处理,形成了800亿标记的高质量中文预训练数据集。

特点

MAP-CC数据集以其庞大的规模和高质量著称,包含800亿中文标记,为中文自然语言处理任务提供了丰富的训练资源。其构建过程中采用的多层次去重技术,确保了数据集的多样性和无重复性,从而提升了模型的训练效果。此外,数据集的开源性质和详细的构建流程,为学术界和工业界提供了宝贵的参考和复现依据,推动了中文语言模型研究的进一步发展。

使用方法

使用MAP-CC数据集进行预训练时,用户需首先下载fasttext模型并进行数据过滤,随后按照提供的脚本进行全文去重和相似行去重处理。完成数据预处理后,用户可参考Neo项目中的预训练代码进行模型训练。数据集的详细使用方法和代码示例均在GitHub页面中提供,用户可根据自身需求进行调整和优化。需要注意的是,数据集的使用需遵循CC BY-NC-ND 4.0许可协议,确保非商业用途和数据完整性。

背景与挑战

背景概述

近年来,随着自然语言处理(NLP)技术的迅猛发展,大规模语言模型(LLM)在多语言处理中展现出显著优势。MAP-CC数据集,作为这一领域的杰出代表,由多模态艺术投影(MAP)团队于2024年创建,旨在推动以中文为中心的LLM研究。该数据集包含800亿个中文预训练标记,结合了300亿英语和100亿代码标记,显著提升了模型对中文的处理能力。通过开源其训练过程和数据处理方法,MAP-CC不仅为NLP社区提供了高质量的中文预训练数据,还为多语言模型的训练方法提供了新的视角,对推动中文语言处理技术的发展具有重要意义。

当前挑战

尽管MAP-CC数据集在推动中文语言模型的发展方面取得了显著成就,但其构建过程中仍面临诸多挑战。首先,数据清洗和预处理过程复杂,涉及多语言数据的高效过滤和去重,这对数据处理技术提出了高要求。其次,如何在保持数据质量的同时,处理大规模数据集的存储和计算资源问题,是构建过程中的一大难题。此外,如何确保模型在多语言环境下的适应性和鲁棒性,以及如何避免数据偏见和提高模型的公平性,也是当前研究中亟待解决的问题。这些挑战不仅影响数据集的构建效率,也对模型的实际应用效果产生深远影响。

常用场景

经典使用场景

MAP-CC数据集在自然语言处理领域中,主要用于预训练大规模语言模型,特别是以中文为中心的模型。其经典使用场景包括构建和优化中文语言模型,通过提供高质量的中文预训练数据,增强模型对中文文本的理解和生成能力。此外,MAP-CC还支持多语言模型的训练,通过混合中文、英文和代码数据,提升模型在多语言环境下的适应性和表现。

实际应用

在实际应用中,MAP-CC数据集被广泛用于开发智能客服、机器翻译、文本生成等应用。例如,在智能客服系统中,使用MAP-CC预训练的模型能够更准确地理解和回应用户的中文查询,提高客户服务的效率和满意度。此外,MAP-CC还支持跨语言的内容生成和翻译,为全球化应用提供了技术支持。

衍生相关工作

基于MAP-CC数据集,研究者们开发了多种衍生工作,包括但不限于中文硬案例基准(CHC-Bench)和CT-LLM模型。CHC-Bench通过提供多学科的中文硬案例,帮助评估和提升模型的理解和执行能力。CT-LLM模型则通过专注于中文数据的预训练和微调,展示了在中文语言任务中的卓越表现,并为后续的多语言模型研究提供了宝贵的经验和数据支持。

以上内容由AI搜集并总结生成